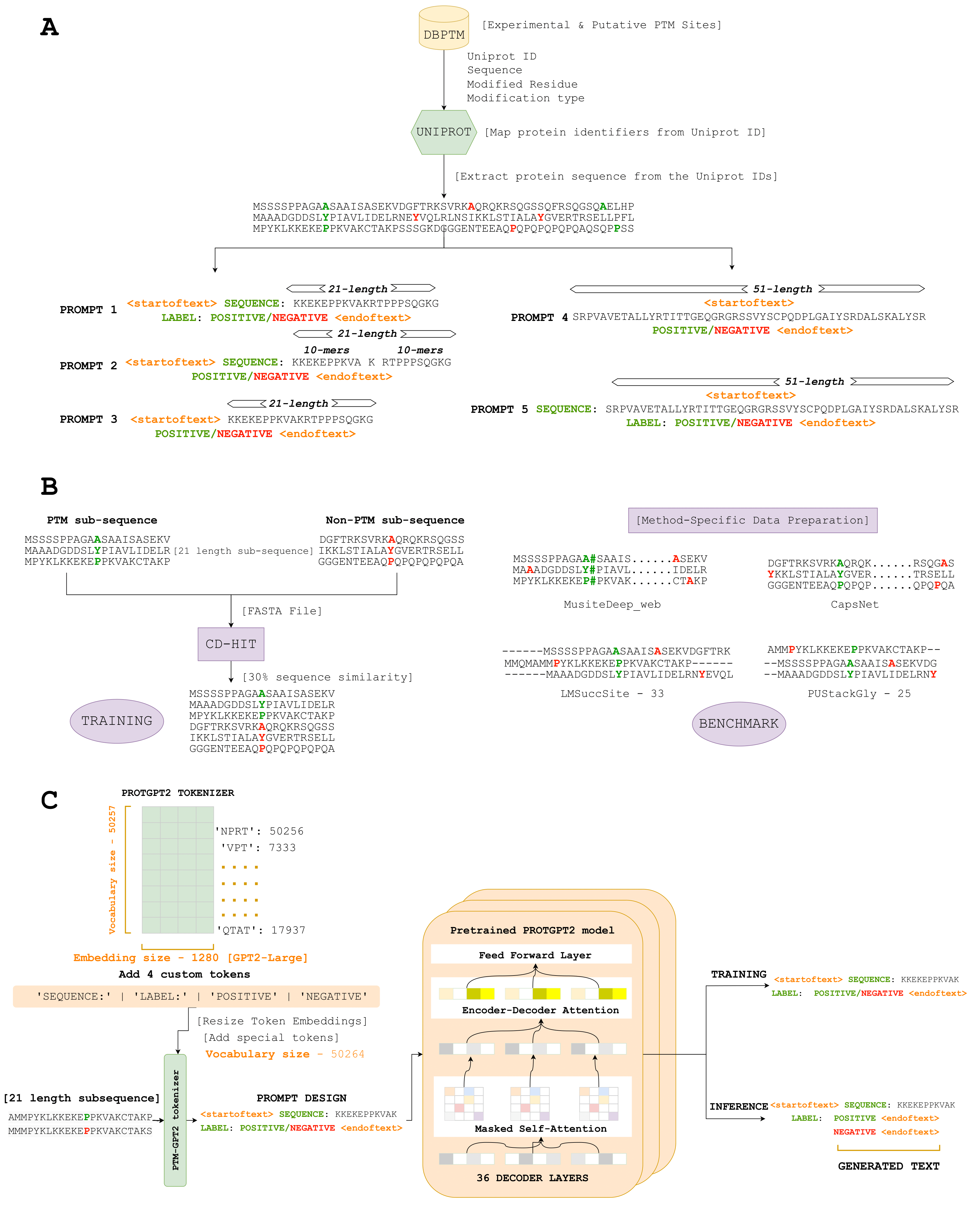

Di sini, kami memperkenalkan PTMGPT2, serangkaian model yang mampu menghasilkan token yang menandakan urutan protein yang dimodifikasi, penting untuk mengidentifikasi situs PTM. Inti dari platform ini adalah Protgpt2, model transformator autoregresif. Kami telah mengadaptasi ProtGPT2, memanfaatkannya sebagai model pra-terlatih, dan selanjutnya disempurnakan untuk tugas spesifik untuk menghasilkan label klasifikasi untuk tipe PTM yang diberikan. Uniknya, PTMGPT2 menggunakan arsitektur decoder-only, yang menghilangkan kebutuhan untuk kepala klasifikasi khusus tugas selama pelatihan. Sebaliknya, lapisan akhir dari dekoder berfungsi sebagai proyeksi kembali ke ruang kosa kata, secara efektif menghasilkan token berikutnya yang mungkin berdasarkan pada pola yang dipelajari di antara token dalam prompt input.

Link - (https://nsclbio.jbnu.ac.kr/gpt_model/)

Hubungi kami langsung di [email protected] untuk prediksi curah dan model terlatih

Link - (https://nsclbio.jbnu.ac.kr/tools/ptmgpt2/)

Link - (https://doi.org/10.5281/zenodo.11371883)

Link - (https://zenodo.org/records/11362322)

Link - (https://doi.org/10.5281/zenodo.11377398)

Python 3.11.3

Transformers 4.29.2

scikit-learn 1.2.2

Pytorch 2.0.1

Pytorch-Cuda 11.7

• Model: Folder ini meng -host model sampel yang dirancang untuk memprediksi situs PTM dari urutan protein yang diberikan, menggambarkan aplikasi PTMGPT2.

• Tokenizer: Folder ini berisi tokenizer sampel yang bertanggung jawab untuk urutan protein tokenisasi, termasuk token buatan tangan untuk asam atau motif amino tertentu.

• Inference.IPYNB: File ini menyediakan kode yang dapat dieksekusi untuk menerapkan model dan tokenizer PTMGPT2 untuk memprediksi situs PTM, berfungsi sebagai panduan praktis bagi pengguna untuk menerapkan model ke set data mereka.