FastSpeech2-Pytorch-Korean-Multi-Speaker

Ce projet est mis en œuvre dans des TTS multi-pardeurs coréens en combinant HIFI-GoNODER avec FastSpeech2.

Introduction

Ce projet vise à développer le TTS du projet «Visible personnalisé AI Speaker» . Il est remplacé par les voix des gens autour de vous, plutôt que par les voix de «Siri», «Bixby» et «Ari». (Ex. Conjoint, fils, fille, parents, etc.)

Afin de faire face à la production immédiate des haut-parleurs d'IA, au lieu d'excellentes performances de Tacotron2 et de lubrification des vagues, le modèle de vocoder Mostoregressitif Mostoregressitif et le modèle de vocodeur GAN, HIFI-GAN, a adopté la qualité et la vitesse de production.

Basé sur le code source FastSpeech2 qui correspond à l'ensemble de données coréen KSS implémenté dans DLLAB.

Objectif du projet

- Utilisation du modèle acoustique-fastSpeech2, Vocoder-Hifigan pour une vitesse de synthèse rapide et des performances élevées

- Transférer l'utilisation de l'apprentissage pour personnaliser avec de petites quantités de données (

+ Clonage zéro Projet latéral ) - Implémentation de l'intégration des conférenciers pour apprendre le multi-haut-parleur pour pré-train

- Configuration du pipeline afin que le processus d'apprentissage soit effectué dans l'ensemble de données coréen à la fin

Ensemble de données

- Pour le pré-train, apprenez en utilisant la voix de conversation gratuite d'Aihub.

- En moyenne, 1 heure et 30 minutes, apprenant avec 30 hommes et 28 données féminines en considération de la qualité

- Chaque orateur a accordé un identifiant de numéro unique dans le processus de prétraitement

- Pour la dine, reportez-vous au script KSS et enregistrez la voix du nouveau haut-parleur en 100 phrases de phrases-300 phrase-600 pour évaluer les performances.

Contribution (Ajouter du projet Precius)

Le contenu ajouté dans le code utilisé est le suivant.

Implémentation de l'intégration des conférenciers (FastSpeech Multi-Speaker coréen)

- Ajouter une couche d'intégration au modèle

- Sortie de l'encodeur et implémentation de code (intégrateur de haut-parleur)

- Implémentation de la fonction get_speakers () qui importe et stocke des informations d'intégration

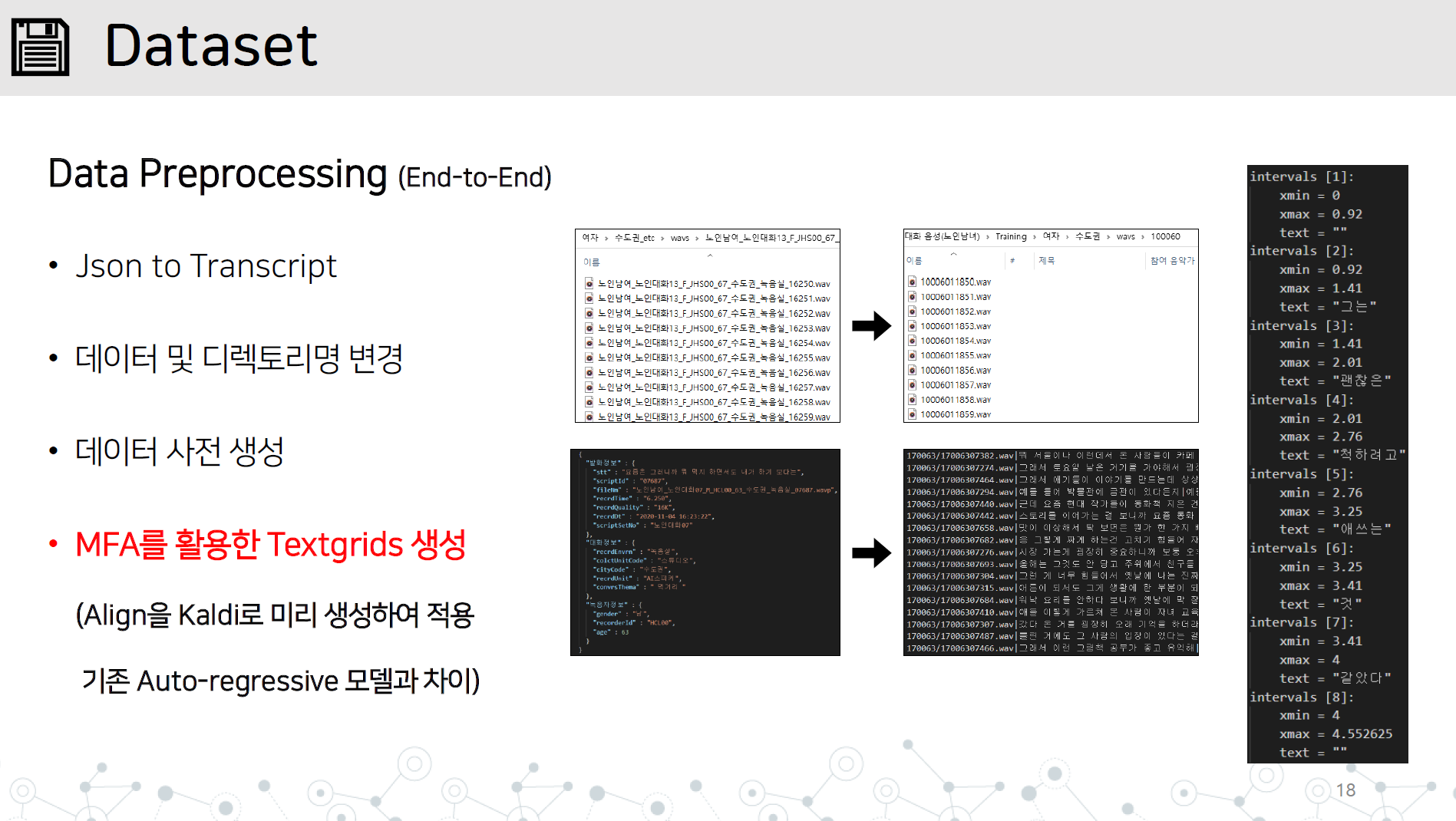

Data_preprocessing.py-end-end-end data prétraitement implémentation contenant tous les éléments ci-dessous

Réponse à la synthèse instable de phrases longues

- Réglez-le pour être attaché après la synthèse dans une unité de caractères spéciaux (unité de phrase)

Importation du code source G2PK et appliquant uniquement les nombres et l'anglais

- Modifiez le package du G2PK existant vers une langue coréenne uniquement sans installation PIP.

Œuvres prévues

Enregistrez le répertoire WAV et le fichier JSON ou Transcript dans le répertoire de jeu de données / nom de données comme indiqué.

Apprenez Montral a forcé Alinger à Kaldi à apprendre TextGrid en apprenant les données audio.

# lab 생성, mfa 학습, lab 분리

python data_preprocessing.py

Enregistrez le générateur appris par HiFI-AG pour l'évaluation lors de l'apprentissage dans le répertoire Vocoder / Preteen_Models.

- Écrivez les données directement en fonction du format ou créez une transcription en faisant référence à la fonction de data_preprocessing.py

- Stockez la transcription générée et le répertoire des données dans DataSet et exécutez le data_proprocessing.py

- Le travail MFA est terminé et le fichier textgrid.zip est créé dans le répertoire supérieur

- Preprocess.py effectue et vérifie le dossier prétraité.

Former

Configurez le chemin de la taille du lot de Hparam.py, du générateur Hifi-Agan et commencez à apprendre.

Si vous étudiez, vous pouvez apprendre en ajoutant Restore_step.

python train.py --restore_step [step]

Transfert d'apprentissage

Si vous effectuez un pré-train pour le multi-orage, le stockage Speaker_info.json généré automatiquement pendant l'apprentissage pré-train

Mettez Speaker_info.json en haut du répertoire

Exécutez Python de la même manière que la réalisation d'une étude dans le train

python train.py --restore_step [pre-train의 step]

Synthétiser

- Synthétisé avec le fichier SnytheSize.py.

python synthesize.py --step [step수]

- Sélection synthétique 1, 2, 3 comme un script présenté au hasard

- 4 SELECT 4

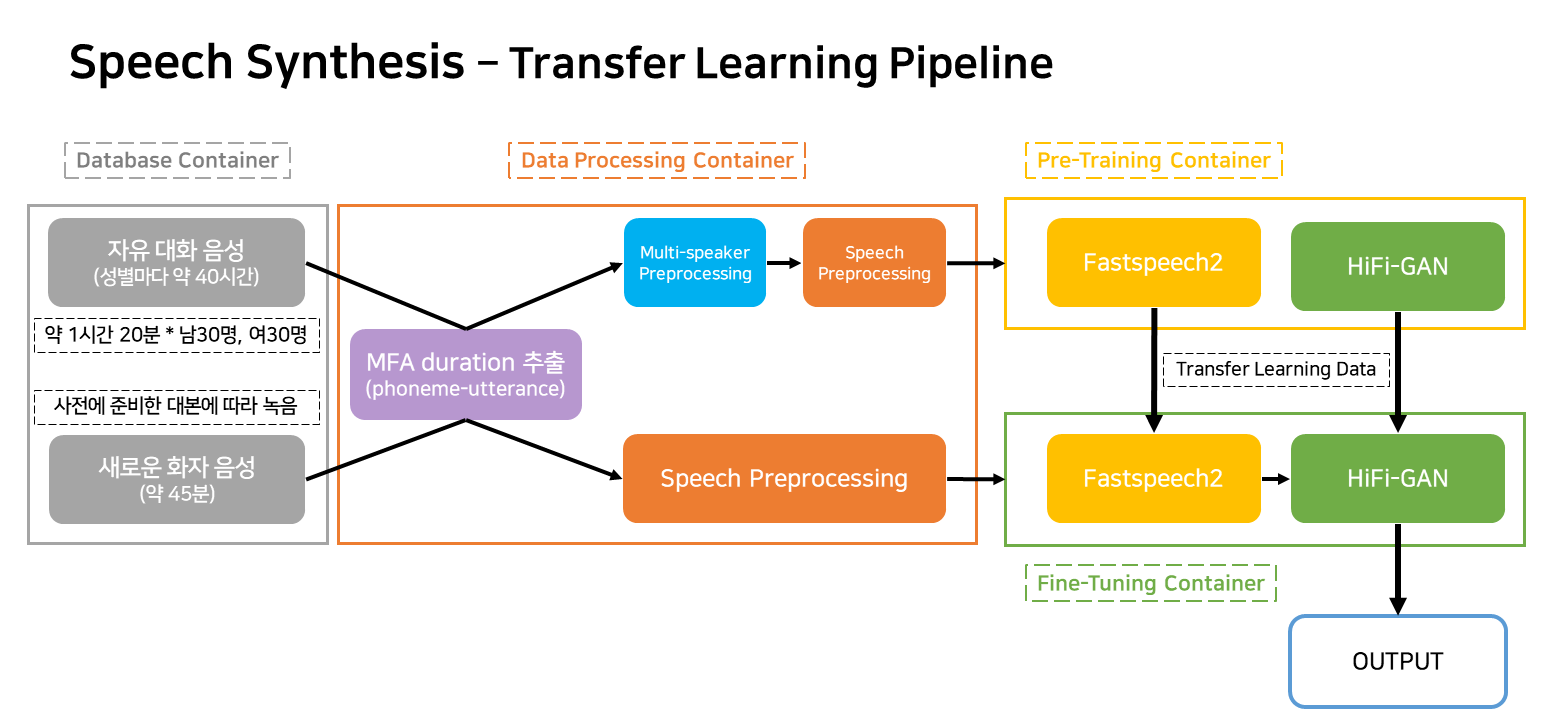

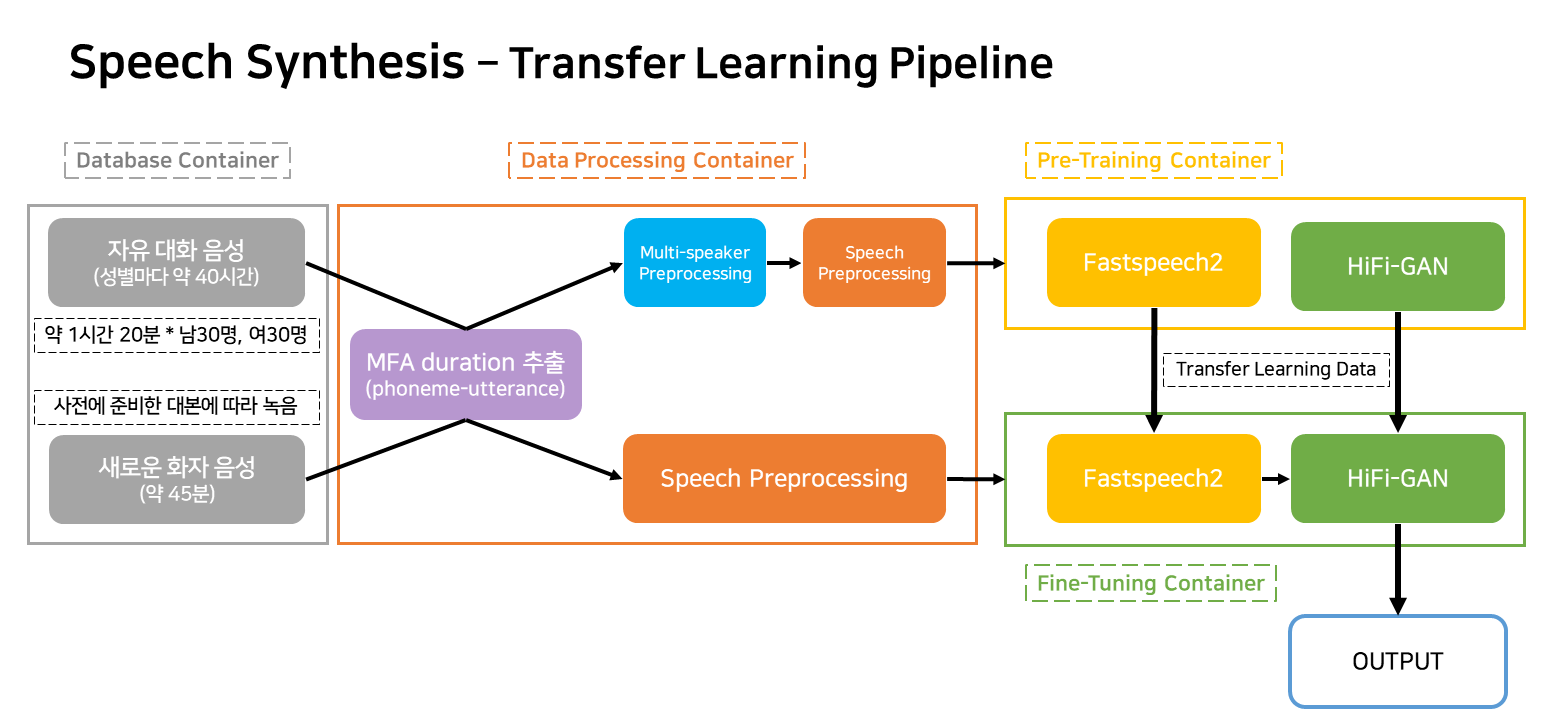

Pipeline de modèles

Ce pipeline est un pipeline de flux pour l'apprentissage et la création TTS qui correspond au service.

Les conteneurs sont largement classés comme quatre.

- Conteneur de base de données contenant le chemin d'accès et les informations utilisateur des données

- Création de transcription, simplification du nom de fichier, extraction de TextGrid avec MFA, conteneur de prétraitement des données pour le modèle

- Conteneur d'apprentissage pour la pré-formation

- Conteneur d'apprentissage pour un réglage fin sur de nouvelles données

Dans la situation de service réelle, seuls trois conteneurs fonctionneront.