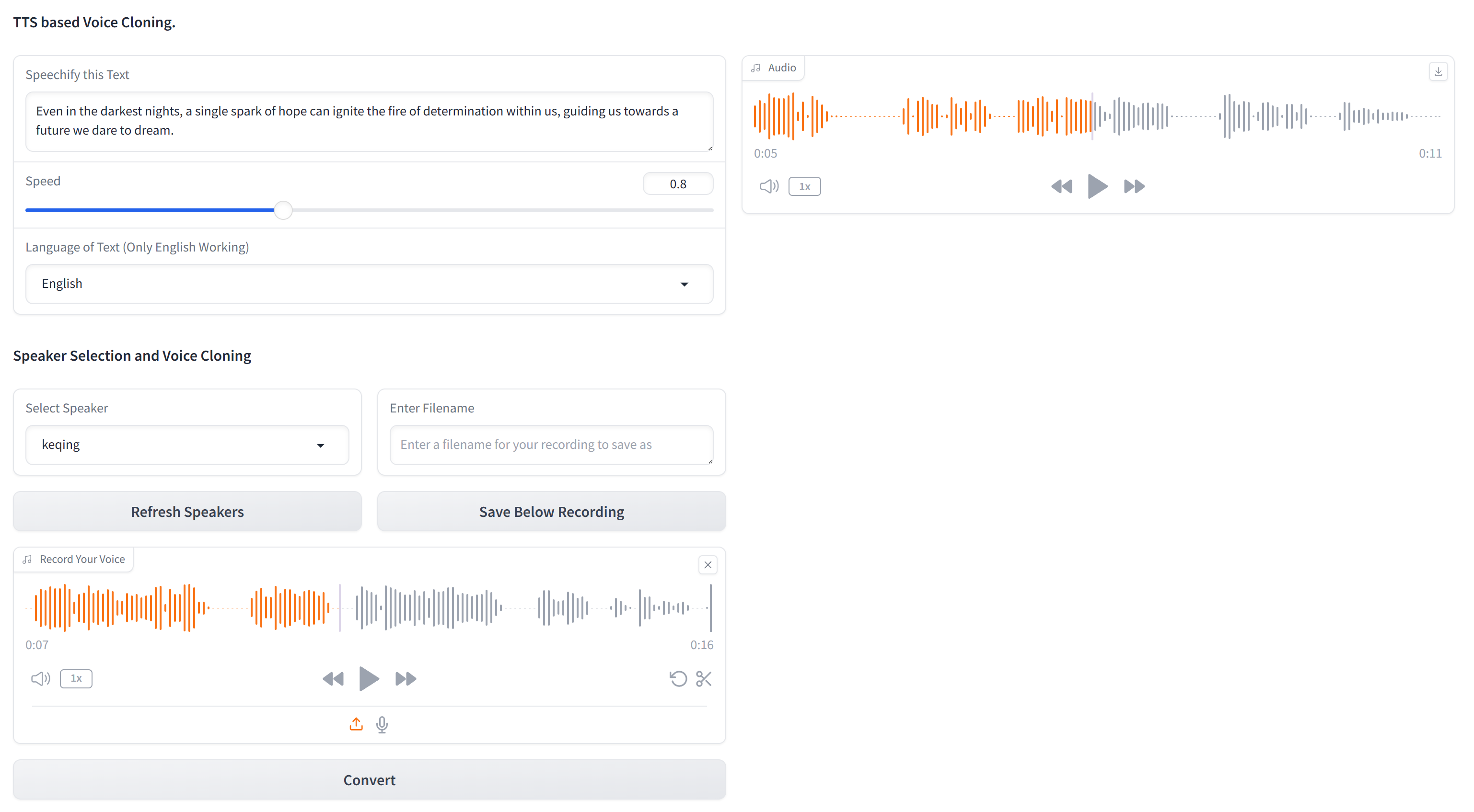

Dieses Repository enthält den essentiellen Code für die Klonierung einer Sprache mit nur Text und einem 10-Sekunden-Audio-Beispiel der Zielstimme. XTTS-2-UI ist einfach zu richten und zu verwenden. Beispielergebnisse?

Arbeitet in 16 Sprachen und verfügt über eine integrierte Sprachaufzeichnung/-aufladung. Hinweis: Erwarten Sie nicht die Qualität der EL -Ebene, es ist noch nicht da.

Das verwendete Modell ist tts_models/multilingual/multi-dataset/xtts_v2 . Weitere Informationen finden Sie unter Umarmungsgesicht-XTTS-V2 und seine spezifische Version XTTS-V2 Version 2.0.2.

Um dieses Projekt einzurichten, befolgen Sie diese Schritte in einem Terminal:

Klonen Sie das Repository

git clone https://github.com/pbanuru/xtts2-ui.git

cd xtts2-uiErstellen Sie eine virtuelle Umgebung:

python -m venv venvFenster:

# cmd prompt

venv S cripts a ctivateoder

# git bash

source venv/Scripts/activateLinux/Mac:

source venv/bin/activatePytorch installieren:

nvcc --versionpip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118Installieren Sie andere erforderliche Pakete:

pip install -r requirements.txtpip install --upgrade TTSNach Abschluss dieser Schritte sollte Ihr Setup abgeschlossen sein und Sie können das Projekt verwenden.

Modelle werden beim ersten Gebrauch automatisch heruntergeladen.

Pfade herunterladen:

/Users/USR/Library/Application Support/tts/tts_models--multilingual--multi-dataset--xtts_v2C:Users YOUR-USER-ACCOUNT AppDataLocalttstts_models--multilingual--multi-dataset--xtts_v2/home/${USER}/.local/share/tts/tts_models--multilingual--multi-dataset--xtts_v2 home/$ <uusertiere Um die Anwendung auszuführen:

python app.py

OR

streamlit run app2.py

Oder Sie können auch vom Terminal selbst auslaufen, indem Sie Beispiel -Eingabetexte auf text.json bereitstellen und mehrere Audios mit mehreren Lautsprechern generieren (möglicherweise müssen Sie auf Appterminal.py anpassen).

python appTerminal.py

Bei der ersten Verwendung müssen Sie den Bedingungen zustimmen:

[XTTS] Loading XTTS...

> tts_models/multilingual/multi-dataset/xtts_v2 has been updated, clearing model cache...

> You must agree to the terms of service to use this model.

| > Please see the terms of service at https://coqui.ai/cpml.txt

| > "I have read, understood and agreed to the Terms and Conditions." - [y/n]

| | >

Wenn Ihr Modell jeden Lauf erneut herunterladen, wenden Sie sich bitte an Ausgabe 4723 auf GitHub.

Der Datensatz besteht aus einem einzelnen Ordner mit dem Namen targets , der mit mehreren Stimmen für Testzwecke vorgepopiert wird.

Erstellen Sie eine 24 -kHz -WAV -Datei von ungefähr 10 Sekunden, um weitere Stimmen hinzuzufügen (wenn Sie nicht die GUI durchgehen möchten) und platzieren Sie sie unter den Ordner targets . Sie können YT-DLP verwenden, um eine Stimme von YouTube zum Klonen herunterzuladen:

yt-dlp -x --audio-format wav "https://www.youtube.com/watch?"

| Sprache | Audio -Beispiel -Link |

|---|---|

| Englisch | |

| Russisch | |

| Arabisch |

Arabisch, Chinesisch, Tschechisch, Niederländisch, Englisch, Französisch, Deutsch, Ungarisch, Italienisch, Japanisch (siehe Setup), Koreanisch, Polnisch, Portugiesisch, Russisch, Spanisch, türkisch

Wenn Sie Japanisch als Zielsprache auswählen möchten, müssen Sie ein Wörterbuch installieren.

# Lite version

pip install fugashi[unidic-lite]oder für ernsthaftere Verarbeitung:

# Full version

pip install fugashi[unidic]

python -m unidic downloadWeitere Details hier.