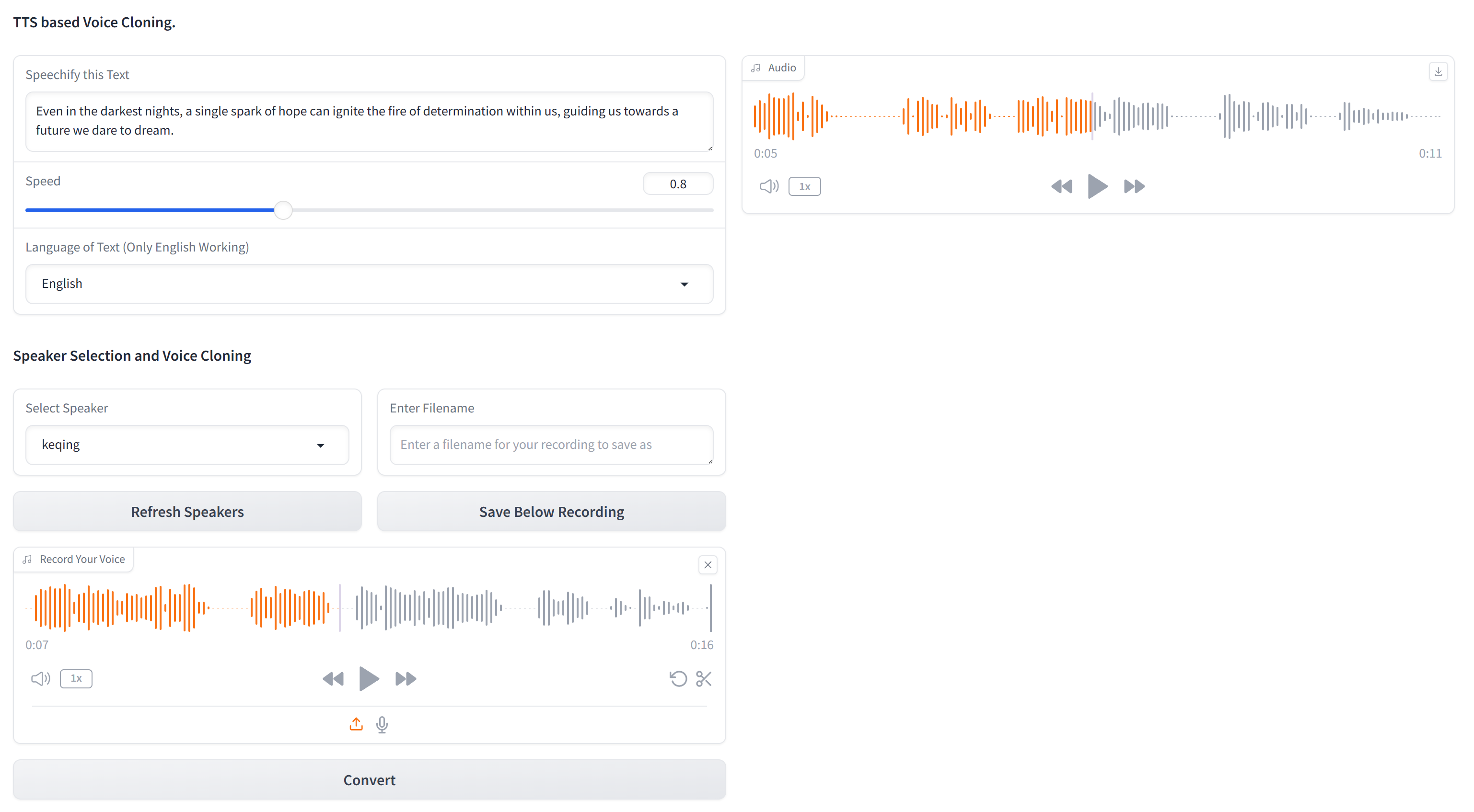

يحتوي هذا المستودع على الكود الأساسي لاستنساخ أي صوت باستخدام نص عادل وعينة صوتية مدتها 10 ثوان من الصوت المستهدف. XTTS-2-UI سهل الإعداد والاستخدام. مثال النتائج؟

يعمل في 16 لغة ولديه تسجيل/تحميل صوتي مدمج. ملاحظة: لا تتوقع جودة مستوى EL ، فهي ليست موجودة بعد.

النموذج المستخدم هو tts_models/multilingual/multi-dataset/xtts_v2 . لمزيد من التفاصيل ، راجع Hugging Face-XTTS-V2 وإصدارها المحدد XTTS-V2 الإصدار 2.0.2.

لإعداد هذا المشروع ، اتبع هذه الخطوات في محطة:

استنساخ المستودع

git clone https://github.com/pbanuru/xtts2-ui.git

cd xtts2-uiإنشاء بيئة افتراضية:

python -m venv venvWindows:

# cmd prompt

venv S cripts a ctivateأو

# git bash

source venv/Scripts/activateLinux/Mac:

source venv/bin/activateتثبيت Pytorch:

nvcc --versionpip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118تثبيت الحزم المطلوبة الأخرى:

pip install -r requirements.txtpip install --upgrade TTSبعد الانتهاء من هذه الخطوات ، يجب أن يكون الإعداد الخاص بك مكتملًا ويمكنك البدء في استخدام المشروع.

سيتم تنزيل النماذج تلقائيًا عند الاستخدام الأول.

مسارات التنزيل:

/Users/USR/Library/Application Support/tts/tts_models--multilingual--multi-dataset--xtts_v2C:Users YOUR-USER-ACCOUNT AppDataLocalttstts_models--multilingual--multi-dataset--xtts_v2/home/${USER}/.local/share/tts/tts_models--multilingual--multi-dataset--xtts_v2 share/tts/tts_models--multilingual--multi-dataset--xts_v2 لتشغيل التطبيق:

python app.py

OR

streamlit run app2.py

أو ، يمكنك أيضًا تشغيل من المحطة نفسها ، من خلال توفير عينة من نصوص الإدخال على النصوص

python appTerminal.py

عند الاستخدام الأولي ، ستحتاج إلى الموافقة على الشروط:

[XTTS] Loading XTTS...

> tts_models/multilingual/multi-dataset/xtts_v2 has been updated, clearing model cache...

> You must agree to the terms of service to use this model.

| > Please see the terms of service at https://coqui.ai/cpml.txt

| > "I have read, understood and agreed to the Terms and Conditions." - [y/n]

| | >

إذا تم إعادة تنزيل النموذج الخاص بك ، فيرجى استشارة العدد 4723 على Github.

تتكون مجموعة البيانات من مجلد واحد يدعى targets ، تم تحريكه مسبقًا مع عدة أصوات لأغراض الاختبار.

لإضافة المزيد من الأصوات (إذا كنت لا ترغب في المرور عبر واجهة المستخدم الرسومية) ، قم بإنشاء ملف WAV 24 كيلو هرتز بحوالي 10 ثوانٍ ووضعه تحت مجلد targets . يمكنك استخدام YT-DLP لتنزيل صوت من YouTube من أجل الاستنساخ:

yt-dlp -x --audio-format wav "https://www.youtube.com/watch?"

| لغة | رابط عينة الصوت |

|---|---|

| إنجليزي | |

| الروسية | |

| عربي |

العربية ، الصينية ، التشيكية ، الهولندية ، الإنجليزية ، الفرنسية ، الألمانية ، الهنغارية ، الإيطالية ، اليابانية (انظر الإعداد) ، الكورية ، البولندية ، البرتغالية ، الروسية ، الإسبانية ، التركية

إذا كنت ترغب في تحديد اليابانية كلغة مستهدفة ، فيجب عليك تثبيت قاموس.

# Lite version

pip install fugashi[unidic-lite]أو لمعالجة أكثر جدية:

# Full version

pip install fugashi[unidic]

python -m unidic downloadمزيد من التفاصيل هنا.