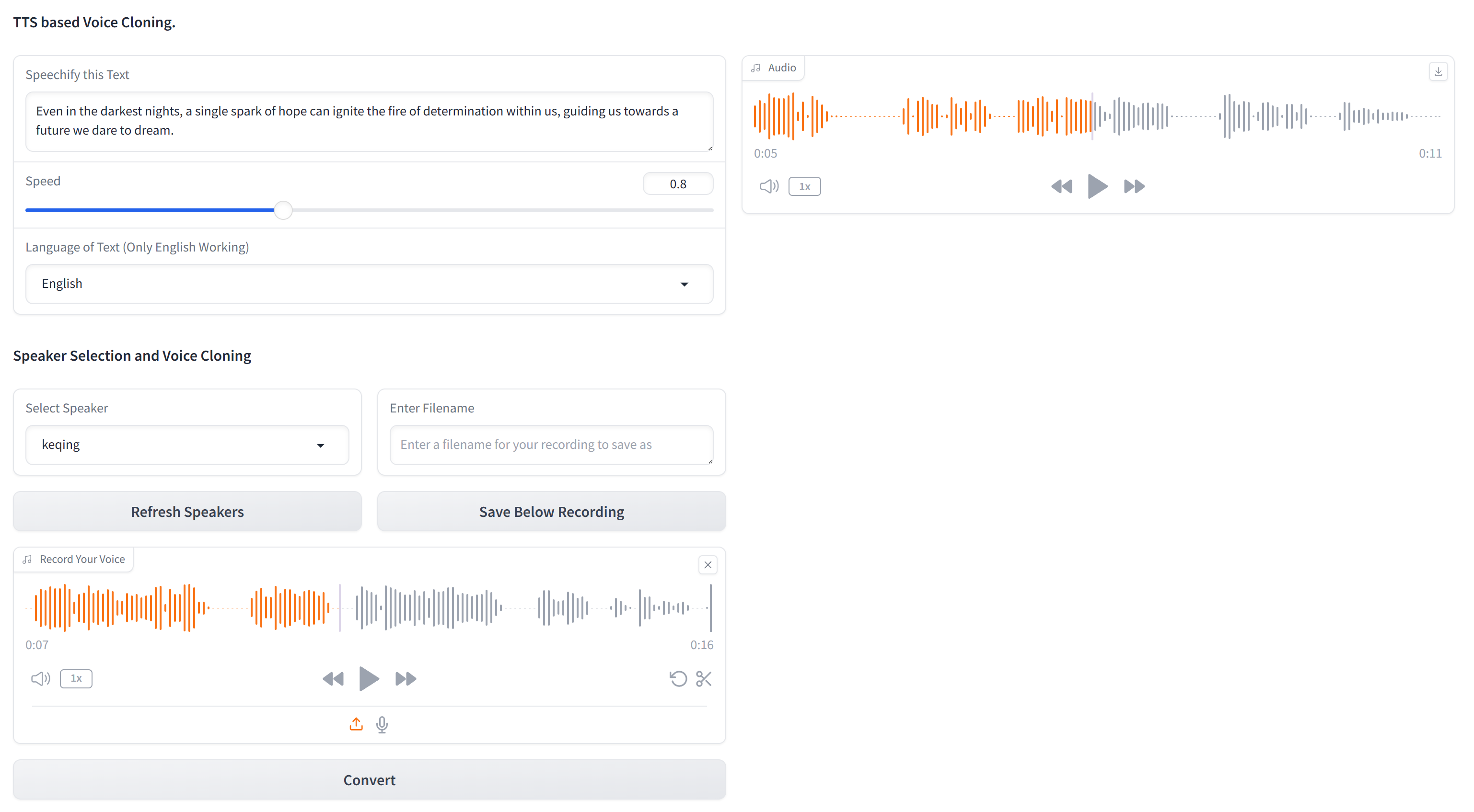

Este repositorio contiene el código esencial para clonar cualquier voz usando solo texto y una muestra de audio de 10 segundos de la voz de destino. XTTS-2-UI es simple de configurar y usar. ¿Resultados de ejemplo?

Funciona en 16 idiomas y tiene grabación/carga de voz incorporada. Nota: No espere la calidad del nivel EL, aún no está allí.

El modelo utilizado es tts_models/multilingual/multi-dataset/xtts_v2 . Para obtener más detalles, consulte Hugging Face-XTTS-V2 y su versión específica de XTTS-V2 versión 2.0.2.

Para configurar este proyecto, siga estos pasos en una terminal:

Clonar el repositorio

git clone https://github.com/pbanuru/xtts2-ui.git

cd xtts2-uiCrear un entorno virtual:

python -m venv venvWindows:

# cmd prompt

venv S cripts a ctivateo

# git bash

source venv/Scripts/activateLinux/Mac:

source venv/bin/activateInstalar pytorch:

nvcc --versionpip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118Instale otros paquetes requeridos:

pip install -r requirements.txtpip install --upgrade TTSDespués de completar estos pasos, su configuración debe estar completa y puede comenzar a usar el proyecto.

Los modelos se descargarán automáticamente tras el primer uso.

Descargar rutas:

/Users/USR/Library/Application Support/tts/tts_models--multilingual--multi-dataset--xtts_v2C:Users YOUR-USER-ACCOUNT AppDataLocalttstts_models--multilingual--multi-dataset--xtts_v2/home/${USER}/.local/share/tts/tts_models--multilingual--multi-dataset--xtts_v2 /$ =user'/.local/share/tts/tts_models ---multilingüe --multi-dataset--xts_v2 Para ejecutar la aplicación:

python app.py

OR

streamlit run app2.py

O bien, también puede ejecutar desde el terminal en sí, proporcionando textos de entrada de muestra en texts.json y generar múltiples audios con múltiples altavoces (es posible que deba ajustar en appMerminal.py)

python appTerminal.py

En el uso inicial, deberá aceptar los términos:

[XTTS] Loading XTTS...

> tts_models/multilingual/multi-dataset/xtts_v2 has been updated, clearing model cache...

> You must agree to the terms of service to use this model.

| > Please see the terms of service at https://coqui.ai/cpml.txt

| > "I have read, understood and agreed to the Terms and Conditions." - [y/n]

| | >

Si su modelo está volviendo a descargar cada ejecución, consulte el problema 4723 en GitHub.

El conjunto de datos consta de una sola carpeta llamada targets , prepoblado con varias voces para fines de prueba.

Para agregar más voces (si no desea pasar por la GUI), cree un archivo WAV de 24 kHz de aproximadamente 10 segundos y colóquelo debajo de la carpeta targets . Puede usar YT-DLP para descargar una voz de YouTube para la clonación:

yt-dlp -x --audio-format wav "https://www.youtube.com/watch?"

| Idioma | Enlace de muestra de audio |

|---|---|

| Inglés | |

| ruso | |

| árabe |

Árabe, chino, checo, holandés, inglés, francés, alemán, húngaro, italiano, japonés (ver configuración), coreano, polaco, portugués, ruso, español, turco

Si desea seleccionar el japonés como idioma de destino, debe instalar un diccionario.

# Lite version

pip install fugashi[unidic-lite]o para un procesamiento más serio:

# Full version

pip install fugashi[unidic]

python -m unidic downloadMás detalles aquí.