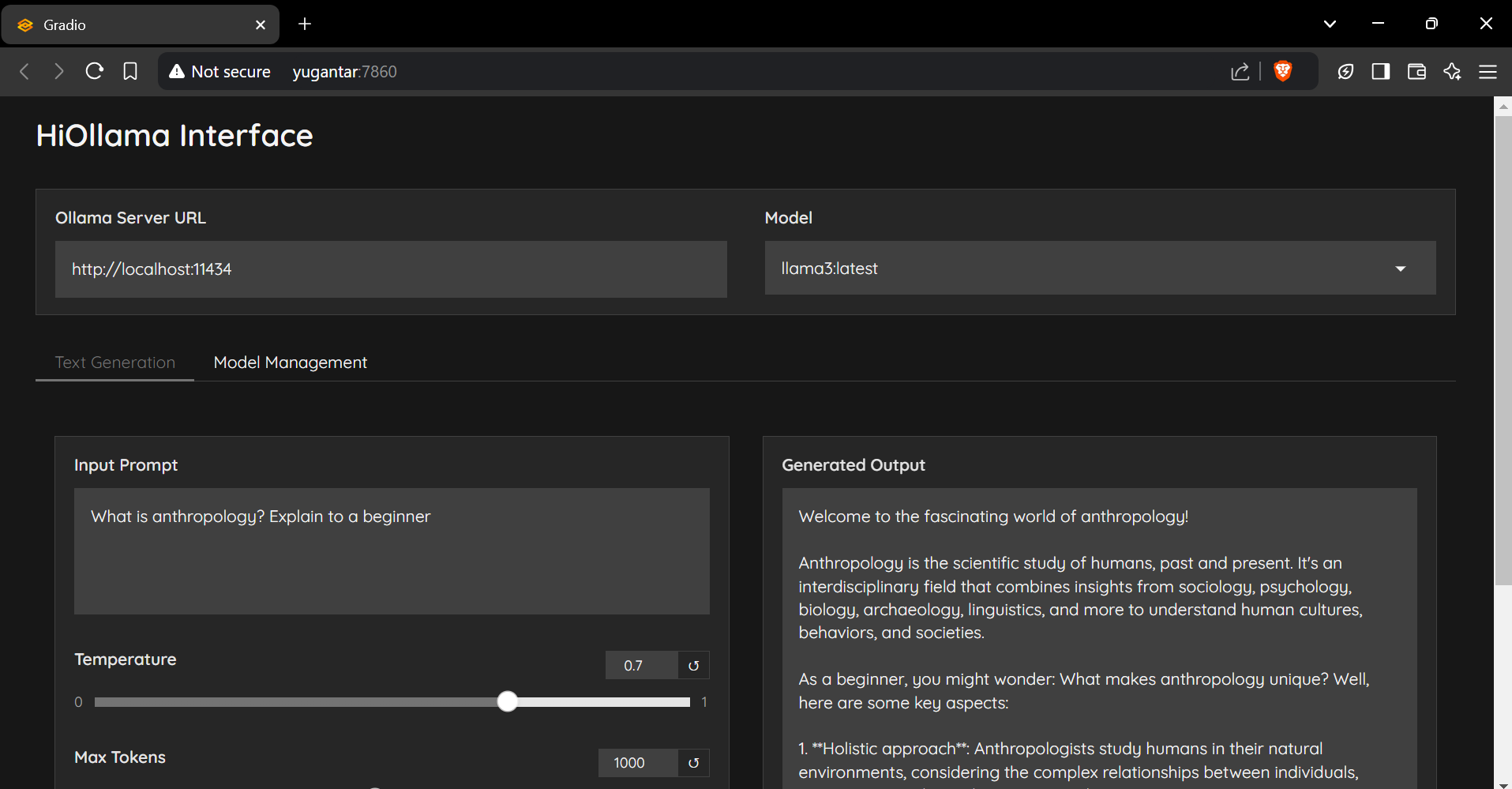

HiOllama

1.0.0

Eine schlanke und benutzerfreundliche Schnittstelle zum Interagieren mit Ollama-Modellen, die mit Python und Gradio gebaut wurden.

git clone https://github.com/smaranjitghose/HiOllama.git

cd HiOllama # Windows

python -m venv env

. e nv S cripts a ctivate

# Linux/Mac

python3 -m venv env

source env/bin/activatepip install -r requirements.txt # Linux/Mac

curl -fsSL https://ollama.ai/install.sh | sh

# For Windows, install WSL2 first, then run the above command ollama servepython main.py http://localhost:7860

Standardeinstellungen können in main.py geändert werden:

DEFAULT_OLLAMA_URL = "http://localhost:11434"

DEFAULT_MODEL_NAME = "llama3" Verbindungsfehler

ollama serve )Modell nicht gefunden

ollama pull model_nameollama listHafenkonflikt

main.py : app . launch ( server_port = 7860 ) # Change to another port Beiträge sind willkommen! Bitte zögern Sie nicht, eine Pull -Anfrage einzureichen.

git checkout -b feature/AmazingFeature ).git commit -m 'Add some AmazingFeature' )git push origin feature/AmazingFeature )Dieses Projekt ist unter der MIT -Lizenz lizenziert - Einzelheiten finden Sie in der Lizenzdatei.

Gemacht mit ❤️ von Smaranjit Ghose