تطبيق Pytorch غير رسمي لـ Vall-E ، استنادًا إلى رمز Encodec.

لعبة جوجل كولاب مثال :. يرجى ملاحظة أن هذا المثال يفرط في نطق واحد تحت

data/testولا يمكن استخدامه. النموذج المسبق لم يأت بعد.

نظرًا لأن المدرب يعتمد على السرعة العميقة ، فستحتاج إلى الحصول على وحدة معالجة الرسومات التي قام بها Deepspeed بتطويرها واختبارها ، بالإضافة إلى تثبيت مترجم CUDA أو ROCM لتثبيت هذه الحزمة.

pip install git+https://github.com/enhuiz/vall-e

أو يمكنك استنساخ:

git clone --recurse-submodules https://github.com/enhuiz/vall-e.git

لاحظ أنه يتم اختبار الرمز فقط تحت Python 3.10.7 .

ضع بياناتك في مجلد ، على سبيل المثال data/your_data . يجب تسمية الملفات الصوتية مع الملفات .wav والملفات النصية مع .normalized.txt .

كمية البيانات:

python -m vall_e.emb.qnt data/your_data

python -m vall_e.emb.g2p data/your_data

تخصيص التكوين الخاص بك عن طريق إنشاء config/your_data/ar.yml و config/your_data/nar.yml . ارجع إلى مثال التكوينات في config/test و vall_e/config.py للحصول على التفاصيل. يمكنك اختيار إعدادات نموذجية مختلفة ، تحقق من vall_e/vall_e/__init__.py .

تدريب نموذج AR أو NAR باستخدام البرامج النصية التالية:

python -m vall_e.train yaml=config/your_data/ar_or_nar.yml

يمكنك ترك التدريب الخاص بك في أي وقت عن طريق كتابة quit في CLI. سيتم حفظ أحدث نقطة تفتيش تلقائيًا.

يجب تصدير كلا النموذجين المدربين إلى مسار معين. لتصدير أي منهما ، قم بالتشغيل:

python -m vall_e.export zoo/ar_or_nar.pt yaml=config/your_data/ar_or_nar.yml

سيؤدي هذا إلى تصدير أحدث نقطة تفتيش.

python -m vall_e <text> <ref_path> <out_path> --ar-ckpt zoo/ar.pt --nar-ckpt zoo/nar.pt

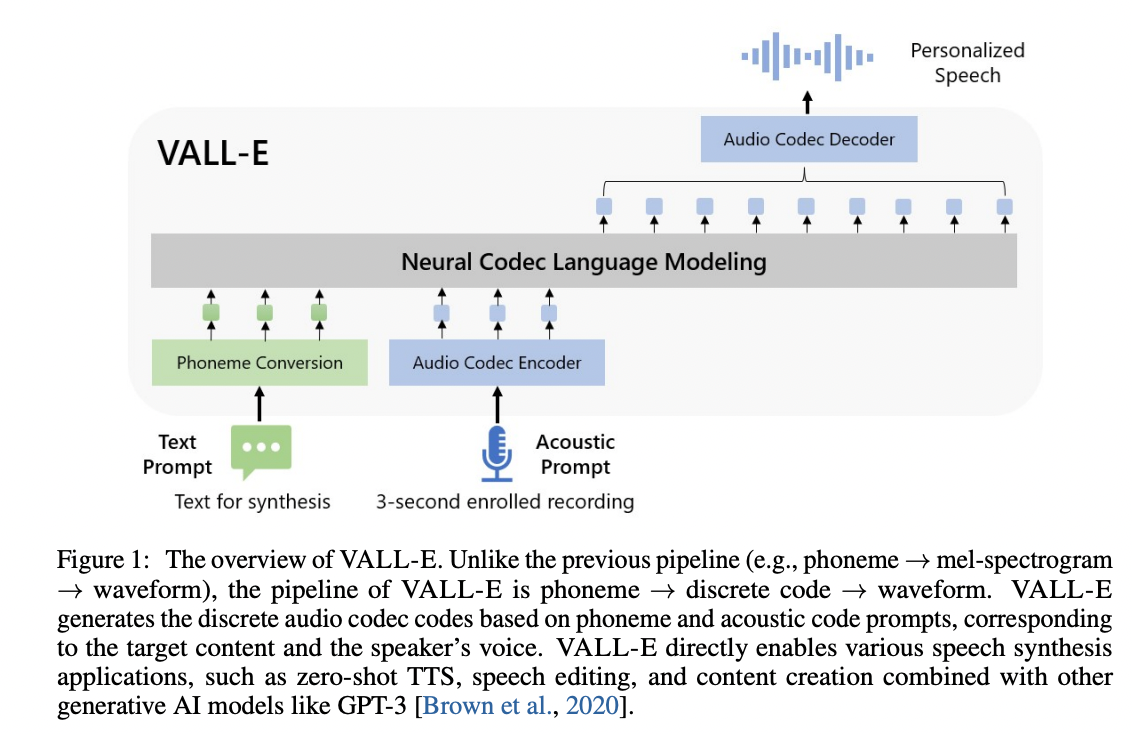

@article { wang2023neural ,

title = { Neural Codec Language Models are Zero-Shot Text to Speech Synthesizers } ,

author = { Wang, Chengyi and Chen, Sanyuan and Wu, Yu and Zhang, Ziqiang and Zhou, Long and Liu, Shujie and Chen, Zhuo and Liu, Yanqing and Wang, Huaming and Li, Jinyu and others } ,

journal = { arXiv preprint arXiv:2301.02111 } ,

year = { 2023 }

} @article { defossez2022highfi ,

title = { High Fidelity Neural Audio Compression } ,

author = { Défossez, Alexandre and Copet, Jade and Synnaeve, Gabriel and Adi, Yossi } ,

journal = { arXiv preprint arXiv:2210.13438 } ,

year = { 2022 }

}