《Factorio》作為一款以建造和資源管理為核心的複雜電腦遊戲,近年來成為了研究人員評估人工智能能力的重要工具。這款遊戲不僅要求玩家規劃和構建複雜的系統,還需要同時管理多個資源和生產鏈,因此能夠有效測試語言模型在復雜環境中的表現。通過模擬真實世界中的資源分配和生產流程,《Factorio》為人工智能研究提供了一個極具挑戰性的平台。

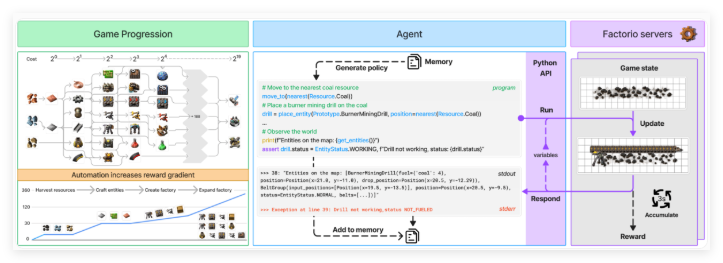

為了更系統地評估人工智能的能力,研究團隊開發了一個名為“Factorio 學習環境”(FLE)的系統。該系統提供了兩種不同的測試模式:“實驗模式”和“開放模式”。在實驗模式中,AI代理需要完成24個結構化挑戰,這些挑戰從簡單的兩台機器建造到復雜的近百台機器工廠不等,設定了具體目標和有限資源。而在開放模式下,AI代理可以自由探索程序生成的地圖,唯一目標是建造盡可能大的工廠。這兩種模式分別測試了AI在受限環境和自由環境中的表現。

AI代理通過一個Python API與《Factorio》進行交互,能夠生成代碼以執行各種操作並檢查遊戲狀態。這個API允許代理執行諸如放置和連接組件、管理資源和監控生產進度等功能。通過這種方式,研究團隊能夠測試語言模型在合成程序和處理複雜系統方面的能力。 API的設計使得AI代理能夠在遊戲中模擬真實世界中的決策過程,從而為研究提供了豐富的數據。

為了評估AI代理的表現,研究者使用了兩個關鍵指標:“生產評分”和“里程碑”。生產評分用於計算總產出價值,且隨著生產鏈複雜性的增加而呈指數增長;里程碑則跟踪諸如創造新物品或研究技術等重要成就。遊戲的經濟模擬還考慮了資源稀缺性、市場價格和生產效率等因素,使得評估更加全面和真實。

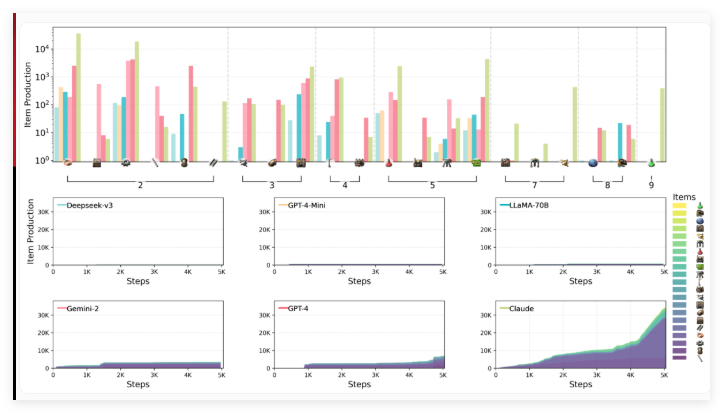

研究團隊,包括來自Anthropic的科學家,評估了六種領先的語言模型在FLE環境下的表現,包括Claude3.5Sonnet、GPT-4o及其迷你版、DeepSeek-V3、Gemini2.0Flash以及Llama-3.3-70B-Instruct。在這輪測試中,未包含大型推理模型(LRMs),但以往的基準測試表明,像o1這樣的模型在規劃能力上表現優異,儘管自身也存在局限性。

測試結果顯示,參與評估的語言模型在空間推理、長期規劃和錯誤糾正方面面臨顯著挑戰。構建工廠時,AI代理在高效安排和連接機器方面出現困難,導致了次優佈局和生產瓶頸。戰略思維同樣成為挑戰,模型們普遍更傾向於優先考慮短期目標,而不是長期規劃。此外,儘管它們能夠處理基本的故障排查,但在面對更複雜問題時,往往陷入低效的調試循環。

在測試的模型中,Claude3.5Sonnet表現最為出色,但仍未能掌握所有挑戰。在實驗模式中,Claude成功完成了24個任務中的15個,而其他模型最多也只完成了10個。在開放測試中,Claude的生產評分達到2456分,GPT-4o以1789分緊隨其後。 Claude展現出複雜的《Factorio》遊戲玩法,通過其戰略性製造和研究方法,快速從基礎產品轉向複雜生產過程,尤其是電鑽技術的提升,顯著提高了鐵板的生產速度。

研究者認為,FLE開放且可擴展的特性,使其在未來測試更強大的語言模型時具有重要價值。他們建議擴展該環境以包含多代理場景和人類表現基準,以便提供更好的評估背景。這項工作進一步豐富了基於遊戲的AI基準測試的集合,其中還包括BALROG和即將推出的MCBench,這些都將利用《Minecraft》進行模型測試。

Factorio 學習環境:https://top.aibase.com/tool/factorio-learning-environment

劃重點:

《Factorio》遊戲成為評估AI能力的新工具,測試語言模型的複雜系統管理能力。

Factorio 學習環境(FLE)提供實驗和開放模式,允許AI在不同條件下進行挑戰。

測試顯示Claude3.5Sonnet表現最佳,但仍存在長期規劃和復雜問題處理的困難。