Como um jogo de computador complexo centrado na construção e gerenciamento de recursos, o Factorio se tornou uma ferramenta importante para os pesquisadores avaliarem as capacidades de inteligência artificial nos últimos anos. Este jogo não apenas exige que os jogadores planejem e construam sistemas complexos, mas também precisam gerenciar vários recursos e cadeias de produção ao mesmo tempo, para que possa efetivamente testar o desempenho de modelos de idiomas em ambientes complexos. Ao simular os processos de alocação de recursos e produção no mundo real, o Factorio fornece uma plataforma extremamente desafiadora para a pesquisa de inteligência artificial.

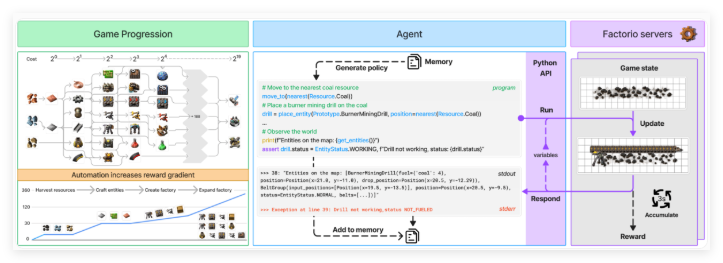

Para avaliar mais sistematicamente as capacidades da inteligência artificial, a equipe de pesquisa desenvolveu um sistema chamado Factorio Learning Environment (FLE). O sistema fornece dois modos de teste diferentes: "modo experimental" e "modo aberto". No modo experimental, os agentes de IA precisam concluir 24 desafios estruturados, desde simples duas máquinas até complexas quase uma fábrica de cem máquinas, estabelecendo metas específicas e recursos limitados. No modo aberto, os agentes da IA podem explorar livremente os mapas gerados pelo programa, com o único objetivo de construir a maior fábrica possível. Esses dois modos testam o desempenho da IA em ambientes restritos e livres, respectivamente.

O agente da IA interage com o Factorio através de uma API Python e é capaz de gerar código para executar várias operações e verificar o status do jogo. Essa API permite que o agente execute funções, como colocar e conectar componentes, gerenciar recursos e monitorar o progresso da produção. Dessa forma, a equipe de pesquisa conseguiu testar a capacidade dos modelos de idiomas de sintetizar programas e lidar com sistemas complexos. A API foi projetada para permitir que os agentes de IA simule os processos de tomada de decisão do mundo real nos jogos, fornecendo dados ricos para a pesquisa.

Para avaliar o desempenho dos agentes da IA, os pesquisadores usaram duas métricas principais: "Pontuação de produção" e "Milestone". As pontuações de produção são usadas para calcular o valor da saída total e crescer exponencialmente à medida que a complexidade da cadeia de produção aumenta; Os marcos rastreiam realizações importantes, como criar novos itens ou pesquisa de tecnologia. A simulação econômica do jogo também leva em consideração fatores como escassez de recursos, preço de mercado e eficiência da produção, tornando a avaliação mais abrangente e autêntica.

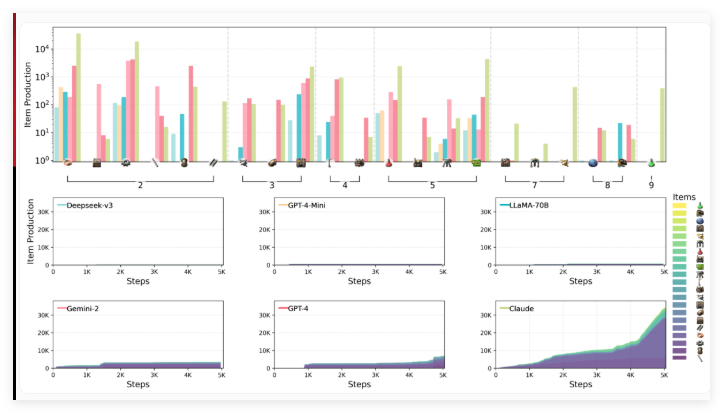

A equipe de pesquisa, incluindo cientistas da Anthropic, avaliou o desempenho de seis modelos de idiomas líderes no ambiente de FLE, incluindo Claude3.5SONNET, GPT-4O e sua mini versão, Deepseek-V3, Gemini2.0flash e LLAMA-3.3-70B-Instruct. Grandes modelos de inferência (LRMS) não foram incluídos nesta rodada de testes, mas os benchmarks anteriores mostraram que modelos como O1 tiveram um bom desempenho nas capacidades de planejamento, embora também tivessem limitações.

Os resultados dos testes mostram que os modelos de idiomas envolvidos na avaliação enfrentam desafios significativos no raciocínio espacial, planejamento de longo prazo e correção de erros. Ao construir uma fábrica, os agentes da IA têm dificuldades em organizar e conectar eficientemente máquinas, resultando em gargalos de layout e produção abaixo do ideal. O pensamento estratégico também é um desafio, e os modelos geralmente preferem priorizar as metas de curto prazo em relação ao planejamento de longo prazo. Além disso, embora possam lidar com a solução de problemas básicos, eles tendem a cair em um loop de depuração ineficiente ao enfrentar problemas mais complexos.

Entre os modelos testados, o Claude 3.5SONnet teve o melhor, mas ainda não conseguiu entender todos os desafios. No modo experimental, Claude concluiu com êxito 15 de 24 tarefas, enquanto outros modelos completaram apenas 10 no máximo. No teste aberto, a pontuação de produção de Claude alcançou 2456 pontos, com o GPT-4o seguindo de perto com 1789 pontos. Claude mostra a jogabilidade complexa de "Factorio" e usa seus métodos estratégicos de fabricação e pesquisa para mudar rapidamente de produtos básicos para processos complexos de produção, especialmente a melhoria da tecnologia de perfuração elétrica, o que melhora significativamente a velocidade de produção das placas de ferro.

Os pesquisadores acreditam que os recursos abertos e escaláveis do FLE tornam o valor importante em testes futuros de modelos de linguagem mais poderosos. Eles sugerem estender o ambiente para incluir cenários multi-agentes e referências de desempenho humano, a fim de fornecer um melhor contexto de avaliação. Este trabalho enriquece ainda mais a coleção de benchmarks de AI baseados em jogos, que também incluem Balrog e o próximo McBench, que será modelado usando o Minecraft.

Ambiente de aprendizagem fatorio: https://top.aibase.com/tool/factorio-learning-environment

Pontos -chave:

O jogo Factorio se tornou uma nova ferramenta para avaliar os recursos de IA e testar os complexos recursos de gerenciamento do sistema dos modelos de linguagem.

O Factorio Learning Environment (FLE) fornece modos experimentais e abertos que permitem que a IA desafie sob diferentes condições.

Os testes mostram que o Claude3.5SONNET tem um desempenho melhor, mas ainda há dificuldades no planejamento e no tratamento de problemas complexos de planejamento de longo prazo.