Como un complejo juego de computadora centrado en la construcción y la gestión de recursos, Factorio se ha convertido en una herramienta importante para que los investigadores evalúen las capacidades de inteligencia artificial en los últimos años. Este juego no solo requiere que los jugadores planifiquen y creen sistemas complejos, sino que también necesita administrar múltiples recursos y cadenas de producción al mismo tiempo, por lo que puede probar efectivamente el rendimiento de los modelos de idiomas en entornos complejos. Al simular la asignación de recursos y los procesos de producción en el mundo real, Factorio proporciona una plataforma extremadamente desafiante para la investigación de inteligencia artificial.

Para evaluar de manera más sistemática las capacidades de la inteligencia artificial, el equipo de investigación desarrolló un sistema llamado Factorio Learning Environment (FLE). El sistema proporciona dos modos de prueba diferentes: "modo experimental" y "modo abierto". En el modo experimental, los agentes de IA deben completar 24 desafíos estructurados que van desde dos máquinas simples hasta complejas casi cien máquinas de fábrica, estableciendo objetivos específicos y recursos limitados. En modo abierto, los agentes de IA pueden explorar libremente mapas generados por el programa, con el único objetivo de construir la fábrica más grande posible. Estos dos modos prueban el rendimiento de la IA en entornos restringidos y libres, respectivamente.

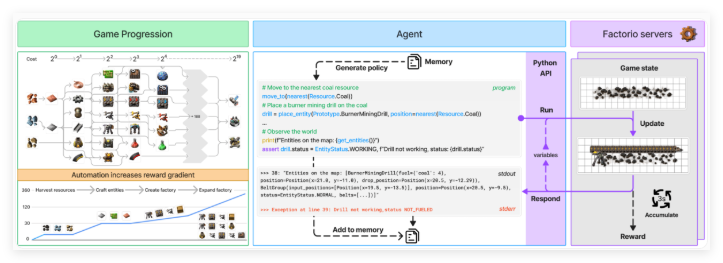

El agente de IA interactúa con Factorio a través de una API de Python, y puede generar código para realizar varias operaciones y verificar el estado del juego. Esta API permite al agente realizar funciones como colocar y conectar componentes, administrar recursos y monitorear el progreso de la producción. De esta manera, el equipo de investigación pudo probar la capacidad de los modelos de lenguaje para sintetizar programas y manejar sistemas complejos. La API está diseñada para permitir a los agentes de IA simular procesos de toma de decisiones del mundo real en los juegos, proporcionando así datos ricos para la investigación.

Para evaluar el rendimiento de los agentes de IA, los investigadores utilizaron dos métricas clave: "puntuación de producción" y "hito". Los puntajes de producción se utilizan para calcular el valor de la producción total y crecer exponencialmente a medida que aumenta la complejidad de la cadena de producción; Los hitos rastrean logros importantes, como la creación de nuevos elementos o la tecnología de investigación. La simulación económica del juego también tiene en cuenta factores como la escasez de recursos, el precio del mercado y la eficiencia de la producción, lo que hace que la evaluación sea más completa y auténtica.

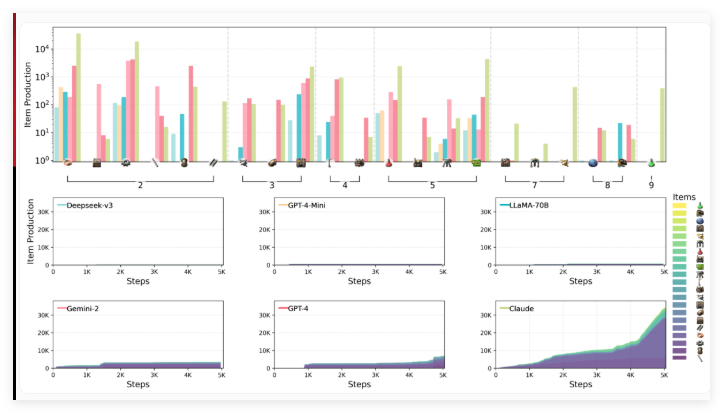

El equipo de investigación, incluidos los científicos de antrópico, evaluó el rendimiento de seis modelos de idiomas líderes en el entorno FLE, incluidos Claude3.5sonnet, GPT-4O y su Mini versión, Deepseek-V3, Gemini2.0flash y Llama-3.3-70B-Instructo. No se incluyeron grandes modelos de inferencia (LRM) en esta ronda de pruebas, pero los puntos de referencia anteriores mostraron que modelos como O1 funcionaban bien en las capacidades de planificación, aunque también tenían limitaciones.

Los resultados de la prueba muestran que los modelos de lenguaje involucrados en la evaluación enfrentan desafíos significativos en el razonamiento espacial, la planificación a largo plazo y la corrección de errores. Al construir una fábrica, los agentes de IA tienen dificultades para organizar y conectar máquinas de manera eficiente, lo que resulta en un diseño subóptimo y cuellos de botella de producción. El pensamiento estratégico también es un desafío, y los modelos generalmente prefieren priorizar los objetivos a corto plazo sobre la planificación a largo plazo. Además, si bien pueden manejar la resolución básica de problemas, tienden a caer en un ciclo de depuración ineficiente cuando se enfrentan a problemas más complejos.

Entre los modelos probados, Claude 3.5sonnet funcionó mejor, pero aún no logró comprender todos los desafíos. En modo experimental, Claude completó con éxito 15 de 24 tareas, mientras que otros modelos solo completaron 10 como máximo. En la prueba abierta, el puntaje de producción de Claude alcanzó 2456 puntos, con GPT-4O siguiendo de cerca con 1789 puntos. Claude muestra el juego complejo de "Factorio" y utiliza sus métodos estratégicos de fabricación e investigación para cambiar rápidamente de productos básicos a procesos de producción complejos, especialmente la mejora de la tecnología de perforación eléctrica, lo que mejora significativamente la velocidad de producción de las placas de hierro.

Los investigadores creen que las características abiertas y escalables de Fle lo hacen de un valor importante en las pruebas futuras de modelos de idiomas más potentes. Sugieren extender el entorno para incluir escenarios de múltiples agentes y puntos de referencia de rendimiento humano para proporcionar un mejor contexto de evaluación. Este trabajo enriquece aún más la colección de puntos de referencia de IA basados en juegos, que también incluyen Balrog y el próximo McBench, que se modelará con Minecraft.

Entorno de aprendizaje de Factorio: https://top.aibase.com/tool/factorio-letarning-environment

Puntos clave:

El juego Factorio se ha convertido en una nueva herramienta para evaluar las capacidades de IA y probar las complejas capacidades de gestión del sistema de los modelos de idiomas.

El entorno de aprendizaje de Factorio (FLE) proporciona modos experimentales y abiertos que permiten a la IA desafiar en diferentes condiciones.

Las pruebas muestran que Claude3.5sonnet funciona mejor, pero todavía hay dificultades en la planificación a largo plazo y el manejo de problemas complejos.