Als komplexes Computerspiel, das sich auf Konstruktions- und Ressourcenmanagement konzentriert, ist Faktorio in den letzten Jahren zu einem wichtigen Instrument für Forscher geworden, um künstliche Intelligenzfunktionen zu bewerten. Für dieses Spiel müssen die Spieler nicht nur komplexe Systeme planen und aufbauen, sondern auch gleichzeitig mehrere Ressourcen und Produktionsketten verwalten, damit die Leistung von Sprachmodellen in komplexen Umgebungen effektiv testen kann. Faktorio simuliert Ressourcenzuweisung und Produktionsprozesse in der realen Welt und bietet eine äußerst herausfordernde Plattform für die Forschung für künstliche Intelligenz.

Um die Fähigkeiten der künstlichen Intelligenz systematisch zu bewerten, entwickelte das Forschungsteam ein System namens Faktorio Learning Environment (FLE). Das System bietet zwei verschiedene Testmodi: "Experimentalmodus" und "Open -Modus". Im experimentellen Modus müssen KI -Agenten 24 strukturierte Herausforderungen abschließen, die von einfachen zwei Maschinen bis zu komplexen fast hundert Maschinenfabrik reichen und spezifische Ziele und begrenzte Ressourcen festlegen. Im offenen Modus können AI-Agenten Programm-generierte Karten frei erkunden, um das einzige Ziel zu bauen. Diese beiden Modi testen die Leistung von KI in eingeschränkten bzw. freien Umgebungen.

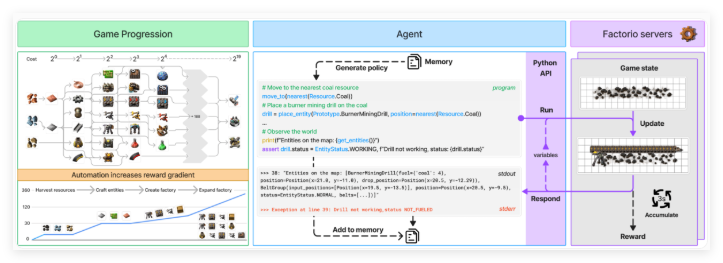

Der AI -Agent interagiert mit Faktorio über eine Python -API und kann Code generieren, um verschiedene Vorgänge auszuführen und den Spielstatus zu überprüfen. Mit dieser API kann der Agent Funktionen wie das Platzieren und Verbinden von Komponenten, das Verwalten von Ressourcen und die Überwachung des Produktionsfortschritts ausführen. Auf diese Weise konnte das Forschungsteam die Fähigkeit von Sprachmodellen testen, Programme zu synthetisieren und komplexe Systeme zu bewältigen. Die API soll es KI-Agenten ermöglichen, reale Entscheidungsprozesse in Spielen zu simulieren und so große Daten für die Forschung bereitzustellen.

Um die Leistung von AI -Agenten zu bewerten, verwendeten die Forscher zwei wichtige Metriken: „Produktionswert“ und „Meilenstein“. Die Produktionswerte werden verwendet, um den Wert der Gesamtleistung zu berechnen und exponentiell zu wachsen, wenn die Komplexität der Produktionskette zunimmt. Meilensteine verfolgen wichtige Erfolge wie das Erstellen neuer Elemente oder die Erforschung von Technologie. Die wirtschaftliche Simulation des Spiels berücksichtigt auch Faktoren wie Ressourcenknappheit, Marktpreis und Produktionseffizienz, wodurch die Bewertung umfassender und authentischer wird.

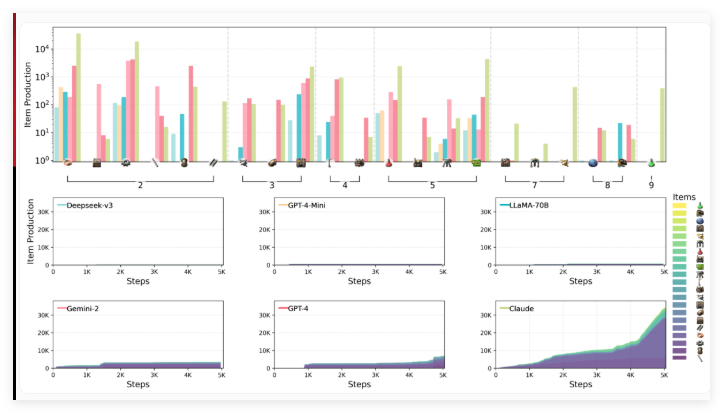

Das Forschungsteam, einschließlich Wissenschaftlern von Anthropic, bewertete die Leistung von sechs führenden Sprachmodellen in der FLE-Umgebung, darunter Claude3.5Sonnet, GPT-4O und seine Mini-Version, Deepseek-V3, Gemini2.0Flash und LLAMA-3,3-70B-Instruction. Große Inferenzmodelle (LRMs) wurden in dieser Testrunde nicht enthalten, aber frühere Benchmarks zeigten, dass Modelle wie O1 in den Planungsfähigkeiten gut abschnitten, obwohl sie auch Einschränkungen hatten.

Die Testergebnisse zeigen, dass die an der Bewertung beteiligten Sprachmodelle mit erheblichen Herausforderungen in Bezug auf räumliches Denken, Langzeitplanung und Fehlerkorrektur stehen. Beim Bau einer Fabrik haben KI -Agenten Schwierigkeiten, Maschinen effizient zu arrangieren und zu verbinden, was zu suboptimalen Layout- und Produktion Engpässen führt. Strategisches Denken ist ebenfalls eine Herausforderung, und Modelle bevorzugen es im Allgemeinen, kurzfristige Ziele für die langfristige Planung zu priorisieren. Darüber hinaus können sie zwar mit der grundlegenden Fehlerbehebung umgehen, aber sie tendieren dazu, in eine ineffiziente Debugging -Schleife zu geraten, wenn sie komplexere Probleme haben.

Unter den getesteten Modellen führte Claude 3.5Sonnet das Beste aus, konnte jedoch immer noch alle Herausforderungen erfassen. Im experimentellen Modus erledigte Claude erfolgreich 15 von 24 Aufgaben, während andere Modelle höchstens 10 abgeschlossen haben. Beim offenen Test erreichte die Produktionsbewertung von Claude 2456 Punkte, wobei GPT-4O mit 1789 Punkten eng hinterher danach folgte. Claude zeigt das komplexe Gameplay von "Faktorio" und verwendet seine strategischen Herstellungs- und Forschungsmethoden, um sich schnell von grundlegenden Produkten zu komplexen Produktionsprozessen, insbesondere der Verbesserung der elektrischen Bohrtechnologie, zu verlagern, was die Produktionsgeschwindigkeit von Eisenplatten erheblich verbessert.

Die Forscher glauben, dass die offenen und skalierbaren Merkmale von FLE den wichtigsten Wert bei zukünftigen Tests von leistungsfähigeren Sprachmodellen machen. Sie schlagen vor, die Umgebung auf Multi-Agent-Szenarien und menschliche Leistungsbenchmarks einzubeziehen, um einen besseren Bewertungskontext zu bieten. Diese Arbeit bereichert die Sammlung von spielbasierten KI-Benchmarks weiter, zu denen auch Balrog und die kommende McBench gehören, die mit Minecraft modelliert werden.

Faktorio-Lernumgebung: https://top.aibase.com/tool/factorio-learning-umvironment

Schlüsselpunkte:

Das Faktorio -Spiel ist zu einem neuen Tool zur Bewertung von KI -Funktionen und zum Testen der komplexen Systemmanagementfunktionen von Sprachmodellen geworden.

Die Faktorio -Lernumgebung (FLE) bietet experimentelle und offene Modi, mit denen die KI unter verschiedenen Bedingungen herausfordern kann.

Tests zeigen, dass Claude3.5Sonnet am besten funktioniert, aber es gibt immer noch Schwierigkeiten bei der langfristigen Planungs- und Umgang mit komplexen Problemen.