Construction and Resource Management에 중점을 둔 복잡한 컴퓨터 게임으로서 Factorio는 최근 몇 년 동안 인공 지능 기능을 평가하는 데 중요한 도구가되었습니다. 이 게임은 플레이어가 복잡한 시스템을 계획하고 구축해야 할뿐만 아니라 동시에 여러 리소스 및 생산 체인을 관리해야하므로 복잡한 환경에서 언어 모델의 성능을 효과적으로 테스트 할 수 있습니다. 실제 세계에서 자원 할당 및 생산 프로세스를 시뮬레이션함으로써 Atcationio는 인공 지능 연구를위한 매우 어려운 플랫폼을 제공합니다.

인공 지능의 능력을보다 체계적으로 평가하기 위해 연구팀은 The Factorio Learning Environment (FLE)라는 시스템을 개발했습니다. 이 시스템은 "실험 모드"와 "오픈 모드"라는 두 가지 테스트 모드를 제공합니다. 실험 모드에서 AI 에이전트는 간단한 두 기계에서 복잡한 거의 백 기계 공장에 이르기까지 24 개의 구조화 된 과제를 완료해야하며 특정 목표와 제한된 리소스를 설정해야합니다. 오픈 모드에서 AI 에이전트는 최대 규모의 공장을 구축하는 유일한 목표로 프로그램 생성지도를 자유롭게 탐색 할 수 있습니다. 이 두 모드는 각각 제한 및 자유 환경에서 AI의 성능을 테스트합니다.

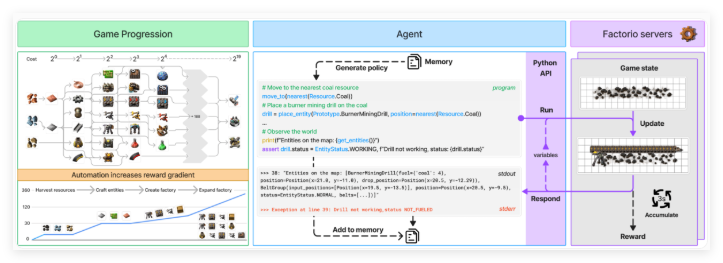

AI 에이전트는 Python API를 통해 Factorio와 상호 작용하며 다양한 작업을 수행하고 게임 상태를 확인하기 위해 코드를 생성 할 수 있습니다. 이 API를 통해 에이전트는 구성 요소 배치 및 연결, 리소스 관리 및 생산 진행 상황 모니터링과 같은 기능을 수행 할 수 있습니다. 이러한 방식으로 연구팀은 프로그램을 종합하고 복잡한 시스템을 처리하는 언어 모델의 능력을 테스트 할 수있었습니다. API는 AI 에이전트가 게임에서 실제 의사 결정 프로세스를 시뮬레이션 할 수 있도록 설계되어 연구를위한 풍부한 데이터를 제공합니다.

AI 에이전트의 성능을 평가하기 위해 연구원들은“생산 점수”와“milestone”이라는 두 가지 주요 메트릭을 사용했습니다. 생산 점수는 생산 체인의 복잡성이 증가함에 따라 총 출력의 값을 계산하고 기하 급수적으로 증가하는 데 사용됩니다. 이정표는 새로운 항목 만들거나 기술 연구와 같은 중요한 업적을 추적합니다. 이 게임의 경제 시뮬레이션은 또한 자원 부족, 시장 가격 및 생산 효율성과 같은 요소를 고려하여 평가를보다 포괄적이고 정통하게 만듭니다.

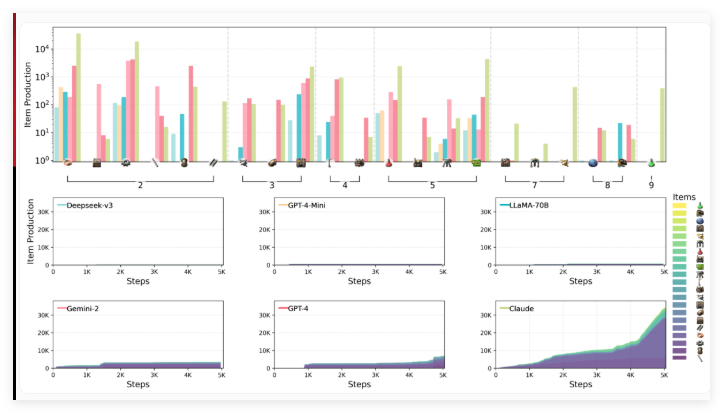

Anthropic의 과학자를 포함한 연구팀은 Claude3.5sonnet, GPT-4O 및 Mini 버전, DeepSeek-V3, Gemini2.0flash 및 Llama-3.3-70B Instruct를 포함한 Fle 환경에서 6 개의 주요 언어 모델의 성능을 평가했습니다. 이 테스트 라운드에는 큰 추론 모델 (LRM)이 포함되지 않았지만 이전의 벤치 마크는 O1과 같은 모델이 한계가 있었지만 계획 기능에서 잘 수행 된 것으로 나타났습니다.

테스트 결과는 평가와 관련된 언어 모델이 공간 추론, 장기 계획 및 오류 수정에서 중대한 문제에 직면 함을 보여줍니다. 공장을 구축 할 때 AI 에이전트는 기계를 효율적으로 배열하고 연결하는 데 어려움이있어 최적의 레이아웃 및 생산 병목 현상이 발생합니다. 전략적 사고는 또한 도전이며, 모델은 일반적으로 장기 계획보다 단기 목표를 우선시하는 것을 선호합니다. 또한 기본 문제 해결을 처리 할 수는 있지만 더 복잡한 문제에 직면 할 때 비효율적 인 디버깅 루프에 빠지는 경향이 있습니다.

테스트 된 모델 중 Claude 3.5Sonnet은 최고를 수행했지만 여전히 모든 과제를 파악하지 못했습니다. 실험 모드에서 Claude는 24 개의 작업 중 15 개를 성공적으로 완료 한 반면 다른 모델은 최대 10 개만 완료했습니다. 공개 테스트에서 Claude의 생산 점수는 2456 점에 도달했으며 GPT-4O는 1789 점으로 뒤쳐졌습니다. Claude는 "Factorio"의 복잡한 게임 플레이를 보여주고 전략적 제조 및 연구 방법을 사용하여 기본 제품에서 복잡한 생산 공정, 특히 전기 드릴링 기술의 개선으로 빠르게 전환하여 철판의 생산 속도를 크게 향상시킵니다.

연구원들은 FLE의 개방적이고 확장 가능한 기능이 향후 강력한 언어 모델을 테스트하는 데 중요한 가치가 있다고 생각합니다. 그들은 더 나은 평가 컨텍스트를 제공하기 위해 여러 에이전트 시나리오와 인간 성능 벤치 마크를 포함하도록 환경을 확장하는 것이 좋습니다. 이 작업은 Balrog와 다가오는 McBench를 포함하여 Minecraft를 사용하여 게임 기반 AI 벤치 마크 모음을 더욱 풍부하게합니다.

Factorio 학습 환경 : https://top.aibase.com/tool/factorio-learning-environment

핵심 사항 :

Factorio 게임은 AI 기능을 평가하고 언어 모델의 복잡한 시스템 관리 기능을 테스트하기위한 새로운 도구가되었습니다.

FLO (Factorio Learning Environment)는 AI가 다른 조건에서 도전 할 수있는 실험적이고 개방형 모드를 제공합니다.

테스트에 따르면 Claude3.5sonnet은 가장 잘 수행되는 것으로 나타 났지만 장기 계획 및 복잡한 문제를 처리하는 데 여전히 어려움이 있습니다.