《Factorio》作为一款以建造和资源管理为核心的复杂电脑游戏,近年来成为了研究人员评估人工智能能力的重要工具。这款游戏不仅要求玩家规划和构建复杂的系统,还需要同时管理多个资源和生产链,因此能够有效测试语言模型在复杂环境中的表现。通过模拟真实世界中的资源分配和生产流程,《Factorio》为人工智能研究提供了一个极具挑战性的平台。

为了更系统地评估人工智能的能力,研究团队开发了一个名为“Factorio 学习环境”(FLE)的系统。该系统提供了两种不同的测试模式:“实验模式”和“开放模式”。在实验模式中,AI代理需要完成24个结构化挑战,这些挑战从简单的两台机器建造到复杂的近百台机器工厂不等,设定了具体目标和有限资源。而在开放模式下,AI代理可以自由探索程序生成的地图,唯一目标是建造尽可能大的工厂。这两种模式分别测试了AI在受限环境和自由环境中的表现。

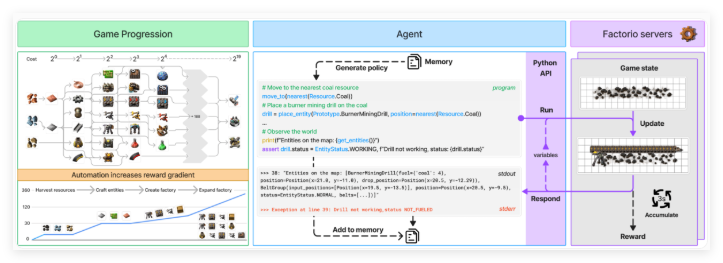

AI代理通过一个Python API与《Factorio》进行交互,能够生成代码以执行各种操作并检查游戏状态。这个API允许代理执行诸如放置和连接组件、管理资源和监控生产进度等功能。通过这种方式,研究团队能够测试语言模型在合成程序和处理复杂系统方面的能力。API的设计使得AI代理能够在游戏中模拟真实世界中的决策过程,从而为研究提供了丰富的数据。

为了评估AI代理的表现,研究者使用了两个关键指标:“生产评分”和“里程碑”。生产评分用于计算总产出价值,且随着生产链复杂性的增加而呈指数增长;里程碑则跟踪诸如创造新物品或研究技术等重要成就。游戏的经济模拟还考虑了资源稀缺性、市场价格和生产效率等因素,使得评估更加全面和真实。

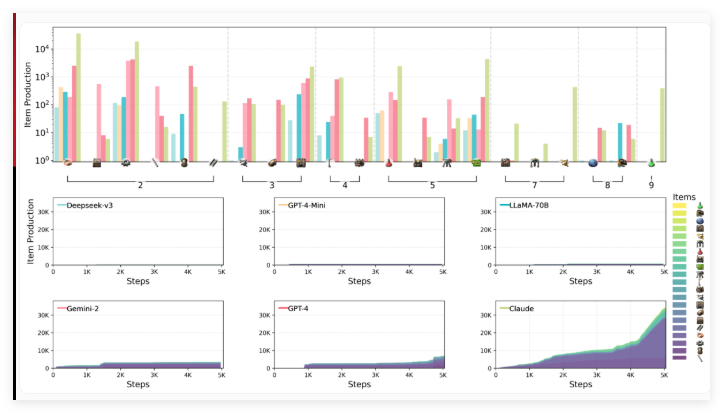

研究团队,包括来自Anthropic的科学家,评估了六种领先的语言模型在FLE环境下的表现,包括Claude3.5Sonnet、GPT-4o及其迷你版、DeepSeek-V3、Gemini2.0Flash以及Llama-3.3-70B-Instruct。在这轮测试中,未包含大型推理模型(LRMs),但以往的基准测试表明,像o1这样的模型在规划能力上表现优异,尽管自身也存在局限性。

测试结果显示,参与评估的语言模型在空间推理、长期规划和错误纠正方面面临显著挑战。构建工厂时,AI代理在高效安排和连接机器方面出现困难,导致了次优布局和生产瓶颈。战略思维同样成为挑战,模型们普遍更倾向于优先考虑短期目标,而不是长期规划。此外,尽管它们能够处理基本的故障排查,但在面对更复杂问题时,往往陷入低效的调试循环。

在测试的模型中,Claude3.5Sonnet表现最为出色,但仍未能掌握所有挑战。在实验模式中,Claude成功完成了24个任务中的15个,而其他模型最多也只完成了10个。在开放测试中,Claude的生产评分达到2456分,GPT-4o以1789分紧随其后。Claude展现出复杂的《Factorio》游戏玩法,通过其战略性制造和研究方法,快速从基础产品转向复杂生产过程,尤其是电钻技术的提升,显著提高了铁板的生产速度。

研究者认为,FLE开放且可扩展的特性,使其在未来测试更强大的语言模型时具有重要价值。他们建议扩展该环境以包含多代理场景和人类表现基准,以便提供更好的评估背景。这项工作进一步丰富了基于游戏的AI基准测试的集合,其中还包括BALROG和即将推出的MCBench,这些都将利用《Minecraft》进行模型测试。

Factorio 学习环境:https://top.aibase.com/tool/factorio-learning-environment

划重点:

《Factorio》游戏成为评估AI能力的新工具,测试语言模型的复杂系统管理能力。

Factorio 学习环境(FLE)提供实验和开放模式,允许AI在不同条件下进行挑战。

测试显示Claude3.5Sonnet表现最佳,但仍存在长期规划和复杂问题处理的困难。