En tant que jeu informatique complexe centré sur la construction et la gestion des ressources, Factoro est devenu un outil important pour les chercheurs afin d'évaluer les capacités d'intelligence artificielle ces dernières années. Ce jeu oblige non seulement les joueurs à planifier et à construire des systèmes complexes, mais doit également gérer plusieurs ressources et chaînes de production en même temps, il peut donc tester efficacement les performances des modèles de langage dans des environnements complexes. En simulant les processus d'allocation et de production des ressources dans le monde réel, Factoro fournit une plate-forme extrêmement difficile pour la recherche sur l'intelligence artificielle.

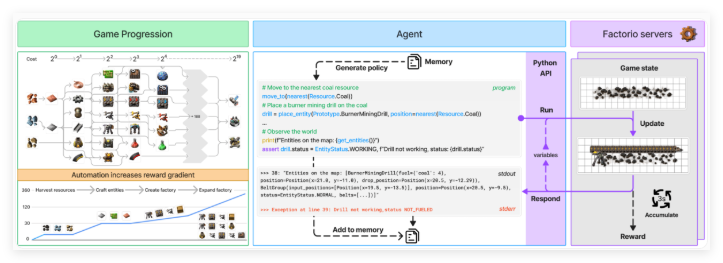

Pour évaluer plus systématiquement les capacités de l'intelligence artificielle, l'équipe de recherche a développé un système appelé Facto Learning Environment (FLE). Le système fournit deux modes de test différents: "mode expérimental" et "mode ouvert". En mode expérimental, les agents de l'IA doivent relever 24 défis structurés allant de deux machines simples à complexes près d'une centaine d'usine de machines, fixant des objectifs spécifiques et des ressources limitées. En mode ouvert, les agents de l'IA peuvent explorer librement les cartes générées par le programme, avec le seul objectif de construire la plus grande usine possible. Ces deux modes testent les performances de l'IA dans des environnements contraints et libres, respectivement.

L'agent AI interagit avec Factoro via une API Python et est capable de générer du code pour effectuer diverses opérations et vérifier l'état du jeu. Cette API permet à l'agent d'effectuer des fonctions telles que la mise en place et la connexion des composants, la gestion des ressources et la surveillance des progrès de la production. De cette façon, l'équipe de recherche a pu tester la capacité des modèles linguistiques à synthétiser les programmes et à gérer des systèmes complexes. L'API est conçue pour permettre aux agents de l'IA de simuler des processus décisionnels du monde réel dans les jeux, fournissant ainsi des données riches pour la recherche.

Pour évaluer les performances des agents de l'IA, les chercheurs ont utilisé deux mesures clés: «score de production» et «jalon». Les scores de production sont utilisés pour calculer la valeur de la production totale et se développer de façon exponentielle à mesure que la complexité de la chaîne de production augmente; Les jalons suivent des réalisations importantes telles que la création de nouveaux éléments ou la technologie de recherche. La simulation économique du jeu prend également en compte des facteurs tels que la rareté des ressources, le prix du marché et l'efficacité de la production, ce qui rend l'évaluation plus complète et authentique.

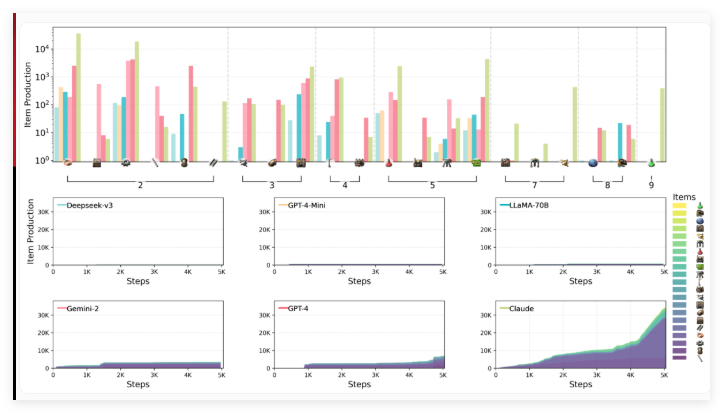

L'équipe de recherche, y compris des scientifiques d'Anthropic, a évalué les performances de six modèles de langue principaux dans l'environnement FLE, notamment Claude3.5Sonnet, GPT-4O et sa mini version, Deepseek-V3, Gemini2.0Flash et LLAMA-3.3-70B-Instructs. De grands modèles d'inférence (LRMS) n'ont pas été inclus dans cette série de tests, mais les repères précédents ont montré que des modèles comme O1 fonctionnaient bien dans les capacités de planification, bien qu'ils aient également des limites.

Les résultats des tests montrent que les modèles de langue impliqués dans l'évaluation sont confrontés à des défis importants dans le raisonnement spatial, la planification à long terme et la correction d'erreurs. Lors de la construction d'une usine, les agents de l'IA ont des difficultés à organiser et à connecter efficacement les machines, entraînant une disposition sous-optimale et des goulots d'étranglement de production. La pensée stratégique est également un défi et les modèles préfèrent généralement hiérarchiser les objectifs à court terme par rapport à la planification à long terme. De plus, bien qu'ils puissent gérer le dépannage de base, ils ont tendance à tomber dans une boucle de débogage inefficace lorsqu'ils sont confrontés à des problèmes plus complexes.

Parmi les modèles testés, Claude 3.5SONNET a effectué le meilleur, mais n'a toujours pas réussi à relever tous les défis. En mode expérimental, Claude a accompli avec succès 15 des 24 tâches, tandis que d'autres modèles n'étaient terminés que 10 au maximum. Dans le test ouvert, le score de production de Claude a atteint 2456 points, GPT-4O après de près avec 1789 points. Claude montre le gameplay complexe de "Factoro" et utilise ses méthodes de fabrication et de recherche stratégiques pour passer rapidement des produits de base aux processus de production complexes, en particulier l'amélioration de la technologie de forage électrique, qui améliore considérablement la vitesse de production des plaques de fer.

Les chercheurs pensent que les caractéristiques ouvertes et évolutives de FLE en font une valeur importante dans les tests futurs de modèles de langage plus puissants. Ils suggèrent d'étendre l'environnement pour inclure des scénarios multi-agents et des références de performance humaine afin de fournir un meilleur contexte d'évaluation. Ce travail enrichit en outre la collection de repères AI basés sur le jeu, qui incluent également Balrog et le prochain McBench, qui sera modélisé à l'aide de Minecraft.

Environnement d'apprentissage Factoro: https://top.aibase.com/tool/factorio-learning-environment

Points clés:

Le jeu Factorio est devenu un nouvel outil pour évaluer les capacités d'IA et tester les capacités complexes de gestion du système des modèles de langage.

Factoro Learning Environment (FLE) fournit des modes expérimentaux et ouverts qui permettent à l'IA de contester dans différentes conditions.

Les tests montrent que Claude3.5SONNET fonctionne le mieux, mais il y a encore des difficultés à planifier à long terme et à gérer des problèmes complexes.