本文介紹了ShareGPT4Video系列,一個旨在提升大規模視訊語言模型(LVLMs)視訊理解能力和文字到視訊模型(T2VMs)視訊生成能力的專案。該系列包含三個主要部分:由GPT4V註釋的40,000個視頻的密集字幕資料集ShareGPT4Video;一個高效的視頻字幕生成模型ShareCaptioner-Video,已用於註釋4,800,000個視頻;以及一個在三個視頻基準測試中取得SOTA效能的LVLM模型ShareGPT4Video-8B。研究團隊克服了現有方法在視訊字幕生成中存在的細節缺失和時間混亂等問題,透過精心設計的差分視訊字幕策略,實現了高品質、可擴展的視訊字幕生成。

1)ShareGPT4Video,由GPT4V 註釋的40,000個不同長度和來源影片的密集字幕,透過精心設計的資料過濾和註釋策略開發而成。

2)ShareCaptioner-Video,一種高效且功能強大的視頻字幕生成模型,適用於任意視頻,由它註釋了4,800,000個高質量美學視頻。

3)ShareGPT4Video-8B,一個簡單但卓越的LVLM,在三個先進的視訊基準測試中取得了SOTA 性能。

除了不具擴展性且成本高昂的人類標註者外,研究發現使用GPT4V 以簡單的多幀或幀串聯輸入策略為視頻生成字幕導致結果缺乏細節,並且有時會出現時間上的混亂。研究團隊認為設計高品質視訊字幕策略的挑戰在於三個面向:

1)理解幀間精確的時間變化。

2)描述幀內詳細的內容。

3)對於任意長度的視頻,幀數量的可擴展性。

為此,研究人員精心設計了差分視訊字幕策略,對於產生任意解析度、寬高比和長度的視訊字幕是穩定、可擴展且高效的。基於此構建了ShareGPT4Video,包含40,000個高品質視頻,涵蓋了廣泛的類別,生成的字幕包含豐富的世界知識、物體屬性、攝影機運動以及關鍵的事件詳細和精確的時間描述。

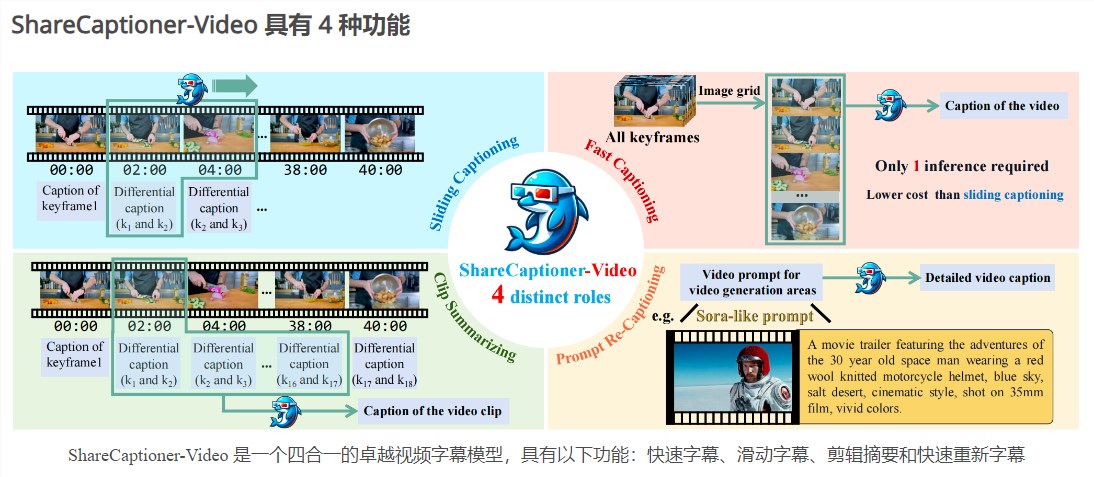

基於ShareGPT4Video,又進一步開發了ShareCaptioner-Video,優秀的字幕產生模型,能夠有效率地產生任意影片的高品質字幕。用它註釋了4,800,000個美學吸引力強的視頻,並在一個10秒的文本到視頻生成任務上驗證了它們的有效性。 ShareCaptioner-Video 是一個四合一的卓越視訊字幕模型,具有以下功能:快速字幕、滑動字幕、剪輯摘要和快速重新字幕。

在視訊理解方面,研究團隊也驗證了ShareGPT4Video 在幾個目前LVLM 體系結構的有效性,並呈現了出色的新LVLM ShareGPT4Video-8B。

產品入口:https://top.aibase.com/tool/sharegpt4video

ShareGPT4Video系列為視訊理解和生成領域帶來了顯著的進展,其高品質的資料集和模型有望推動相關技術的進一步發展。 造訪連結以了解更多細節。