In diesem Artikel wird die ShareGPT4Video-Reihe vorgestellt, ein Projekt, das darauf abzielt, die Videoverständnisfunktionen von LVLMs (Large-Scale Video Language Models) und die Videogenerierungsfunktionen von Text-to-Video-Modellen (T2VMs) zu verbessern. Die Serie besteht aus drei Hauptteilen: ShareGPT4Video, einem dichten Untertiteldatensatz von 40.000 mit GPT4V kommentierten Videos; ShareCaptioner-Video, einem effizienten Modell zur Generierung von Videountertiteln, das zum Kommentieren von 4.800.000 Videos verwendet wurde; und einem zu drei Video-Benchmarks ShareGPT4Video-8B , ein LVLM-Modell, das SOTA-Leistung erreicht. Das Forschungsteam überwand die Probleme mangelnder Details und Zeitverwirrung bei der Generierung von Videountertiteln mit bestehenden Methoden und erreichte durch eine sorgfältig entwickelte differenzielle Videountertitelstrategie eine qualitativ hochwertige und skalierbare Videountertitelgenerierung.

1) ShareGPT4Video, eine dichte Untertitelsammlung von 40.000 Videos unterschiedlicher Länge und Quellen, die von GPT4V mit Anmerkungen versehen wurden und durch sorgfältig entwickelte Datenfilterungs- und Anmerkungsstrategien entwickelt wurden.

2) ShareCaptioner-Video, ein effizientes und leistungsstarkes Modell zur Generierung von Videountertiteln, das für beliebige Videos geeignet ist und 4.800.000 hochwertige ästhetische Videos mit Anmerkungen versehen kann.

3) ShareGPT4Video-8B, ein einfacher, aber überlegener LVLM, erreicht SOTA-Leistung bei drei erweiterten Video-Benchmarks.

Zusätzlich zu nicht skalierbaren und kostspieligen menschlichen Annotatoren ergab die Studie, dass die Verwendung von GPT4V zur Generierung von Untertiteln für Videos mit einer einfachen Multi-Frame- oder Frame-Verkettungs-Eingabestrategie zu Ergebnissen führte, denen es an Details mangelte und die manchmal zeitlich verstümmelt waren. Das Forschungsteam ist davon überzeugt, dass die Herausforderung bei der Entwicklung hochwertiger Video-Untertitelstrategien in drei Aspekten liegt:

1) Verstehen Sie präzise zeitliche Änderungen zwischen Frames.

2) Beschreiben Sie den detaillierten Inhalt innerhalb des Frames.

3) Skalierbarkeit auf die Anzahl der Bilder für Videos beliebiger Länge.

Zu diesem Zweck haben die Forscher sorgfältig eine differenzielle Strategie für Videountertitel entwickelt, die stabil, skalierbar und effizient ist, um Videountertitel mit beliebigen Auflösungen, Seitenverhältnissen und Längen zu generieren. Darauf basiert ShareGPT4Video, das 40.000 hochwertige Videos enthält, die ein breites Spektrum an Kategorien abdecken. Die generierten Untertitel enthalten umfangreiches Weltwissen, Objekteigenschaften, Kamerabewegungen sowie detaillierte und präzise Zeitbeschreibungen wichtiger Ereignisse.

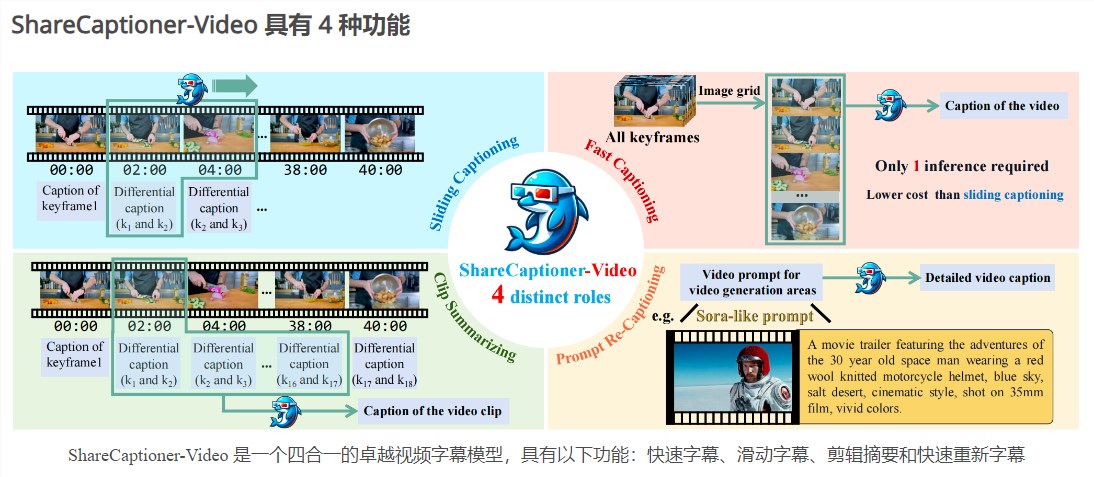

Basierend auf ShareGPT4Video wurde ShareCaptioner-Video weiterentwickelt, ein hervorragendes Modell zur Untertitelgenerierung, mit dem qualitativ hochwertige Untertitel für jedes Video effizient generiert werden können. Wir verwenden es, um 4.800.000 ästhetisch ansprechende Videos zu kommentieren und ihre Wirksamkeit anhand einer 10-sekündigen Text-zu-Video-Generierungsaufgabe zu überprüfen. ShareCaptioner-Video ist ein erstklassiges 4-in-1-Video-Untertitelmodell mit den folgenden Funktionen: Quick Caption, Sliding Caption, Clip Summary und Quick Re-Subtitle.

Im Hinblick auf das Videoverständnis überprüfte das Forschungsteam auch die Wirksamkeit von ShareGPT4Video auf mehreren aktuellen LVLM-Architekturen und stellte das herausragende neue LVLM ShareGPT4Video-8B vor.

Produkteingang: https://top.aibase.com/tool/sharegpt4video

Die ShareGPT4Video-Reihe hat erhebliche Fortschritte im Bereich des Videoverständnisses und der Videogenerierung gebracht, und ihre hochwertigen Datensätze und Modelle sollen die weitere Entwicklung verwandter Technologien vorantreiben. Weitere Informationen finden Sie unter dem Link.