В этой статье представлена серия ShareGPT4Video — проект, направленный на улучшение возможностей понимания видео крупномасштабных моделей языка видео (LVLM) и возможностей генерации видео моделей преобразования текста в видео (T2VM). Серия состоит из трех основных частей: ShareGPT4Video, плотный набор данных субтитров из 40 000 видео, аннотированных GPT4V, эффективная модель создания субтитров к видео, которая использовалась для аннотирования 4 800 000 видео и одного из трех тестов видео ShareGPT4Video-8B; , модель LVLM, обеспечивающая производительность SOTA. Исследовательская группа преодолела проблемы отсутствия деталей и путаницы во времени при создании видеосубтитров в существующих методах и добилась высококачественной и масштабируемой генерации видеосубтитров с помощью тщательно разработанной стратегии дифференциальных видеосубтитров.

1) ShareGPT4Video — плотная коллекция субтитров из 40 000 видеороликов различной длины и источников с аннотациями GPT4V, разработанная с помощью тщательно разработанных стратегий фильтрации данных и аннотирования.

2) ShareCaptioner-Video, эффективная и мощная модель создания видеосубтитров, подходящая для произвольных видео, которая аннотирует 4 800 000 высококачественных эстетических видеороликов.

3) ShareGPT4Video-8B, простой, но превосходный LVLM, обеспечивает производительность SOTA в трех расширенных тестах видео.

В дополнение к немасштабируемым и дорогостоящим аннотаторам, работающим вручную, исследование показало, что использование GPT4V для создания субтитров для видео с помощью простой стратегии ввода нескольких кадров или конкатенации кадров приводило к результатам, в которых не хватало деталей, а иногда были временно искажены. Исследовательская группа считает, что проблема разработки стратегий высококачественных видеосубтитров заключается в трех аспектах:

1) Поймите точные временные изменения между кадрами.

2) Опишите подробное содержание в кадре.

3) Масштабируемость по количеству кадров для видео произвольной длины.

С этой целью исследователи тщательно разработали стратегию дифференциальных видеосубтитров, которая является стабильной, масштабируемой и эффективной для создания видеосубтитров с произвольным разрешением, соотношением сторон и длиной. На этой основе был создан ShareGPT4Video, который содержит 40 000 высококачественных видеороликов, охватывающих широкий спектр категорий. Сгенерированные субтитры содержат обширные сведения о мире, свойствах объектов, движениях камеры, а также подробное и точное описание времени ключевых событий.

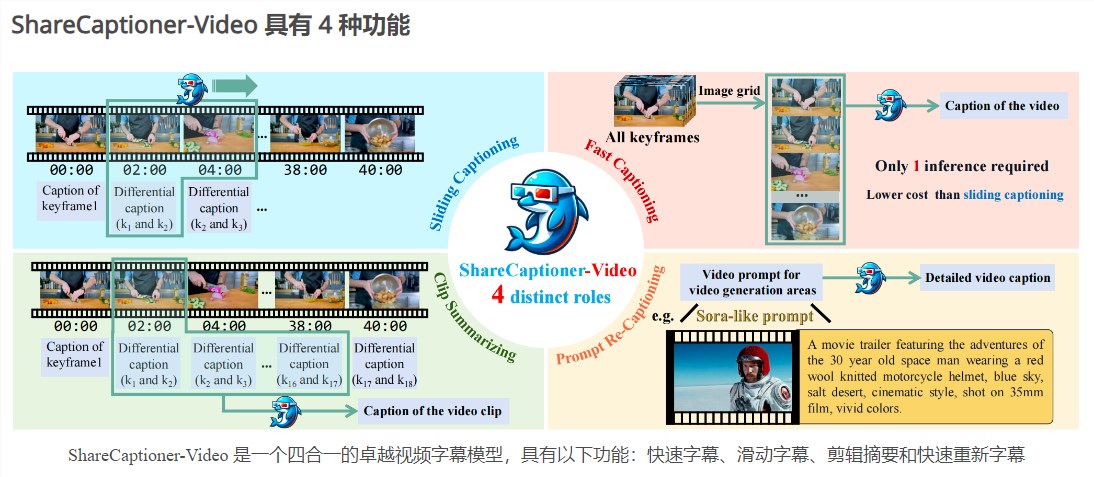

На основе ShareGPT4Video была доработана ShareCaptioner-Video — отличная модель создания субтитров, которая позволяет эффективно генерировать высококачественные субтитры для любого видео. Мы используем его для аннотирования 4 800 000 эстетически привлекательных видеороликов и проверки их эффективности при выполнении 10-секундной задачи по преобразованию текста в видео. ShareCaptioner-Video — это превосходная модель видеосубтитров «четыре в одном» со следующими функциями: быстрая подпись, скользящая подпись, сводка клипа и быстрое изменение субтитров.

Что касается понимания видео, исследовательская группа также проверила эффективность ShareGPT4Video на нескольких текущих архитектурах LVLM и представила выдающийся новый LVLM ShareGPT4Video-8B.

Вход в продукт: https://top.aibase.com/tool/sharegpt4video.

Серия ShareGPT4Video принесла значительный прогресс в области понимания и создания видео, а ее высококачественные наборы данных и модели, как ожидается, будут способствовать дальнейшему развитию соответствующих технологий. Посетите ссылку для более подробной информации.