이 기사에서는 LVLM(대규모 비디오 언어 모델)의 비디오 이해 기능과 T2VM(텍스트-비디오 모델)의 비디오 생성 기능을 향상시키는 것을 목표로 하는 프로젝트인 ShareGPT4Video 시리즈를 소개합니다. 이 시리즈는 세 가지 주요 부분으로 구성됩니다. GPT4V로 주석이 달린 40,000개의 비디오로 구성된 조밀한 캡션 데이터세트인 ShareCaptioner-Video는 4,800,000개의 비디오에 주석을 추가하는 데 사용된 ShareGPT4Video-8B입니다. , SOTA 성능을 달성하는 LVLM 모델입니다. 연구팀은 기존 방식의 영상 자막 생성 시 세부 정보 부족 및 시간 혼란 문제를 극복하고, 세심하게 설계된 차등 영상 자막 전략을 통해 고품질의 확장 가능한 영상 자막 생성을 달성했습니다.

1) ShareGPT4Video는 신중하게 설계된 데이터 필터링 및 주석 전략을 통해 개발된 GPT4V에서 주석을 추가한 다양한 길이와 소스의 40,000개 비디오로 구성된 조밀한 자막 컬렉션입니다.

2) 임의의 영상에 적합한 효율적이고 강력한 영상 자막 생성 모델인 ShareCaptioner-Video는 4,800,000개의 고품질 심미적 영상에 주석을 추가합니다.

3) 간단하지만 뛰어난 LVLM인 ShareGPT4Video-8B는 세 가지 고급 비디오 벤치마크에서 SOTA 성능을 달성했습니다.

확장이 불가능하고 비용이 많이 드는 인간 주석자 외에도 연구에서는 GPT4V를 사용하여 간단한 다중 프레임 또는 프레임 연결 입력 전략으로 비디오 자막을 생성하면 세부 정보가 부족하고 때로는 일시적으로 왜곡되는 결과가 발생한다는 사실을 발견했습니다. 연구팀은 고품질 비디오 자막 전략을 설계하는 데 있어 세 가지 측면이 있다고 생각합니다.

1) 프레임 간의 정확한 시간적 변화를 이해합니다.

2) 프레임 내에서 자세한 내용을 기술하세요.

3) 임의 길이의 비디오에 대한 프레임 수 확장성.

이를 위해 연구자들은 임의의 해상도, 종횡비 및 길이의 비디오 자막을 생성하기 위해 안정적이고 확장 가능하며 효율적인 차등 비디오 자막 전략을 신중하게 설계했습니다. ShareGPT4Video는 이를 기반으로 구축되었으며, 생성된 자막에는 풍부한 세계 지식, 개체 속성, 카메라 움직임 및 주요 이벤트에 대한 상세하고 정확한 시간 설명이 포함되어 있습니다.

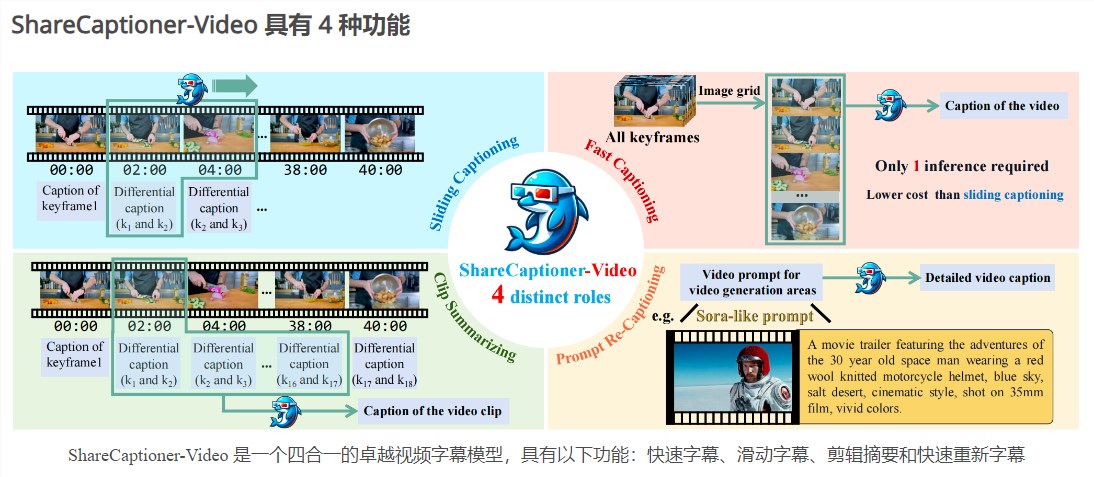

ShareGPT4Video를 기반으로 모든 비디오에 대해 고품질 자막을 효율적으로 생성할 수 있는 뛰어난 자막 생성 모델인 ShareCaptioner-Video가 더욱 개발되었습니다. 우리는 이를 사용하여 미학적으로 매력적인 4,800,000개의 비디오에 주석을 달고 10초 텍스트-비디오 생성 작업에서 그 효과를 검증합니다. ShareCaptioner-Video는 빠른 캡션, 슬라이딩 캡션, 클립 요약 및 빠른 재자막 기능을 갖춘 4가지 기능이 하나로 통합된 우수한 비디오 자막 모델입니다.

비디오 이해 측면에서 연구팀은 현재 여러 LVLM 아키텍처에서 ShareGPT4Video의 효율성을 검증하고 뛰어난 새 LVLM ShareGPT4Video-8B를 선보였습니다.

제품 입구: https://top.aibase.com/tool/sharegpt4video

ShareGPT4Video 시리즈는 비디오 이해 및 생성 분야에 상당한 진전을 가져왔으며, 고품질 데이터 세트 및 모델은 관련 기술의 추가 개발을 촉진할 것으로 예상됩니다. 자세한 내용을 보려면 링크를 방문하세요.