この記事では、大規模ビデオ言語モデル (LVLM) のビデオ理解機能とテキストからビデオへのモデル (T2VM) のビデオ生成機能を向上させることを目的としたプロジェクトである ShareGPT4Video シリーズについて紹介します。このシリーズは、GPT4V によって注釈が付けられた 40,000 個のビデオの高密度キャプション データセットである ShareGPT4Video、および 4,800,000 個のビデオに注釈を付けるために使用されている効率的なビデオ キャプション生成モデルである ShareGPT4Video-8B の 3 つの主要な部分で構成されています。 、SOTAパフォーマンスを実現するLVLMモデル。研究チームは、既存の手法におけるビデオ字幕生成における詳細の欠如と時間の混乱の問題を克服し、慎重に設計された差分ビデオ字幕戦略を通じて、高品質でスケーラブルなビデオ字幕生成を実現しました。

1) ShareGPT4Video は、さまざまな長さのビデオと GPT4V によって注釈が付けられたソースの 40,000 本の高密度の字幕コレクションであり、慎重に設計されたデータ フィルタリングと注釈戦略を通じて開発されました。

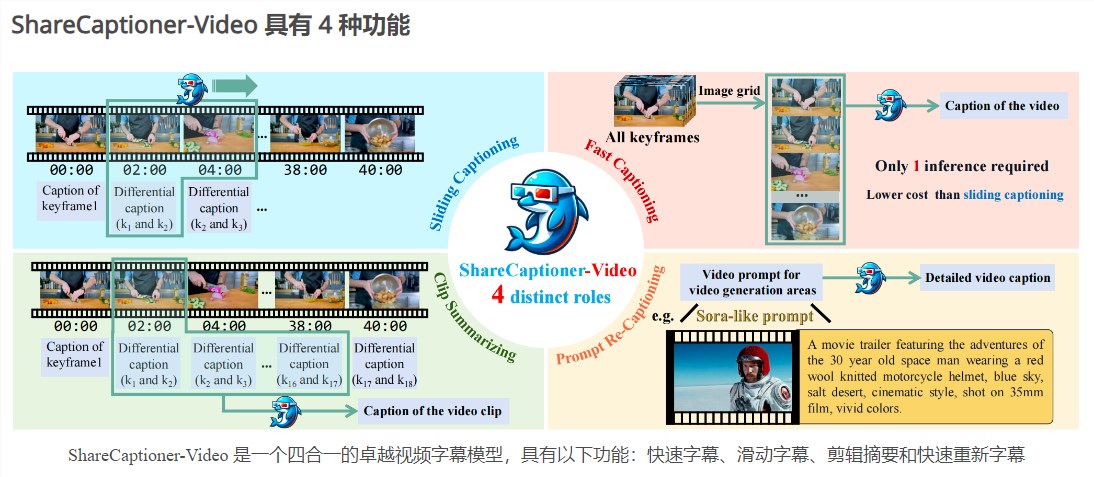

2) ShareCaptioner-Video は、任意のビデオに適した効率的かつ強力なビデオ字幕生成モデルであり、4,800,000 の高品質で美しいビデオに注釈を付けます。

3) シンプルだが優れた LVLM である ShareGPT4Video-8B は、3 つの高度なビデオ ベンチマークで SOTA パフォーマンスを達成します。

この研究では、スケーラブルでコストのかかる人間によるアノテーターに加えて、単純なマルチフレームまたはフレーム連結入力戦略でビデオの字幕を生成するために GPT4V を使用すると、詳細が欠如し、場合によっては時間的に文字化けする結果が得られることがわかりました。研究チームは、高品質ビデオの字幕戦略を設計する際の課題は次の 3 つの側面にあると考えています。

1) フレーム間の正確な時間的変化を理解します。

2) 枠内に詳細な内容を記載します。

3) 任意の長さのビデオのフレーム数に対するスケーラビリティ。

この目的を達成するために、研究者は、任意の解像度、アスペクト比、および長さのビデオ字幕を生成するための、安定性、スケーラブル、および効率的な差分ビデオ字幕戦略を慎重に設計しました。 ShareGPT4Video はこれに基づいて構築されており、幅広いカテゴリをカバーする 40,000 の高品質ビデオが含まれています。生成された字幕には、世界の豊富な知識、オブジェクトのプロパティ、カメラの動き、主要なイベントの詳細かつ正確な時間の説明が含まれています。

ShareGPT4Video に基づいて ShareCaptioner-Video がさらに開発され、あらゆるビデオに対して高品質の字幕を効率的に生成できる優れた字幕生成モデルです。私たちはこれを使用して 4,800,000 の美的に魅力的なビデオに注釈を付け、10 秒間のテキストからビデオへの生成タスクでの効果を検証します。 ShareCaptioner-Video は、クイック キャプション、スライド キャプション、クリップ サマリー、およびクイック再字幕の機能を備えた 4 つを 1 つにまとめた優れたビデオ字幕モデルです。

ビデオの理解に関して、研究チームはまた、いくつかの現在の LVLM アーキテクチャ上で ShareGPT4Video の有効性を検証し、優れた新しい LVLM ShareGPT4Video-8B を発表しました。

製品入口: https://top.aibase.com/tool/sharegpt4video

ShareGPT4Video シリーズはビデオの理解と生成の分野に大きな進歩をもたらし、その高品質のデータセットとモデルは関連技術のさらなる開発を促進することが期待されています。 詳細については、リンクを参照してください。