Cet article présente la série ShareGPT4Video, un projet visant à améliorer les capacités de compréhension vidéo des modèles de langage vidéo à grande échelle (LVLM) et les capacités de génération vidéo des modèles texte-vidéo (T2VM). La série se compose de trois parties principales : ShareGPT4Video, un ensemble de données de sous-titrage dense de 40 000 vidéos annotées par GPT4V ; ShareCaptioner-Video, un modèle de génération de sous-titres vidéo efficace, qui a été utilisé pour annoter 4 800 000 vidéos et un sur trois benchmarks vidéo ShareGPT4Video-8B ; , un modèle LVLM qui atteint les performances SOTA. L'équipe de recherche a surmonté les problèmes de manque de détails et de confusion temporelle dans la génération de sous-titres vidéo avec les méthodes existantes, et est parvenue à une génération de sous-titres vidéo de haute qualité et évolutive grâce à une stratégie de sous-titres vidéo différentiels soigneusement conçue.

1) ShareGPT4Video, une collection dense de sous-titres de 40 000 vidéos de différentes longueurs et sources annotées par GPT4V, développée grâce à des stratégies de filtrage et d'annotation de données soigneusement conçues.

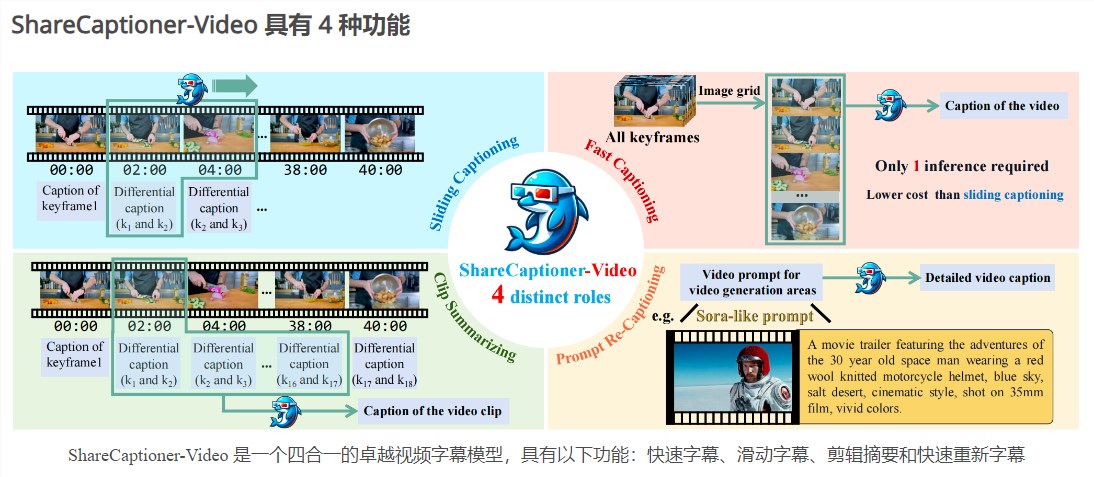

2) ShareCaptioner-Video, un modèle de génération de sous-titres vidéo efficace et puissant adapté aux vidéos arbitraires, qui annote 4 800 000 vidéos esthétiques de haute qualité.

3) ShareGPT4Video-8B, un LVLM simple mais supérieur, atteint des performances SOTA sur trois benchmarks vidéo avancés.

En plus des annotateurs humains non évolutifs et coûteux, l'étude a révélé que l'utilisation de GPT4V pour générer des sous-titres pour des vidéos avec une simple stratégie d'entrée multi-images ou de concaténation d'images aboutissait à des résultats manquant de détails et parfois tronqués dans le temps. L’équipe de recherche estime que le défi de la conception de stratégies de sous-titres vidéo de haute qualité réside dans trois aspects :

1) Comprendre les changements temporels précis entre les images.

2) Décrivez le contenu détaillé du cadre.

3) Évolutivité au nombre d'images pour les vidéos de longueur arbitraire.

À cette fin, les chercheurs ont soigneusement conçu une stratégie de sous-titres vidéo différentielle qui est stable, évolutive et efficace pour générer des sous-titres vidéo de résolutions, de formats et de longueurs arbitraires. ShareGPT4Video a été construit sur cette base, qui contient 40 000 vidéos de haute qualité couvrant un large éventail de catégories. Les sous-titres générés contiennent de riches connaissances du monde, des propriétés d'objets, des mouvements de caméra et des descriptions temporelles détaillées et précises des événements clés.

Basé sur ShareGPT4Video, ShareCaptioner-Video a été développé, un excellent modèle de génération de sous-titres capable de générer efficacement des sous-titres de haute qualité pour n'importe quelle vidéo. Nous l'utilisons pour annoter 4 800 000 vidéos esthétiquement attrayantes et vérifier leur efficacité sur une tâche de génération texte en vidéo de 10 secondes. ShareCaptioner-Video est un modèle de sous-titre vidéo supérieur quatre-en-un avec les fonctionnalités suivantes : sous-titre rapide, sous-titre coulissant, résumé du clip et re-sous-titre rapide.

En termes de compréhension vidéo, l'équipe de recherche a également vérifié l'efficacité de ShareGPT4Video sur plusieurs architectures LVLM actuelles et a présenté le nouveau LVLM ShareGPT4Video-8B exceptionnel.

Entrée du produit : https://top.aibase.com/tool/sharegpt4video

La série ShareGPT4Video a apporté des progrès significatifs dans le domaine de la compréhension et de la génération de vidéos, et ses ensembles de données et modèles de haute qualité devraient promouvoir le développement ultérieur des technologies associées. Visitez le lien pour plus de détails.