LoGU

1.0.0

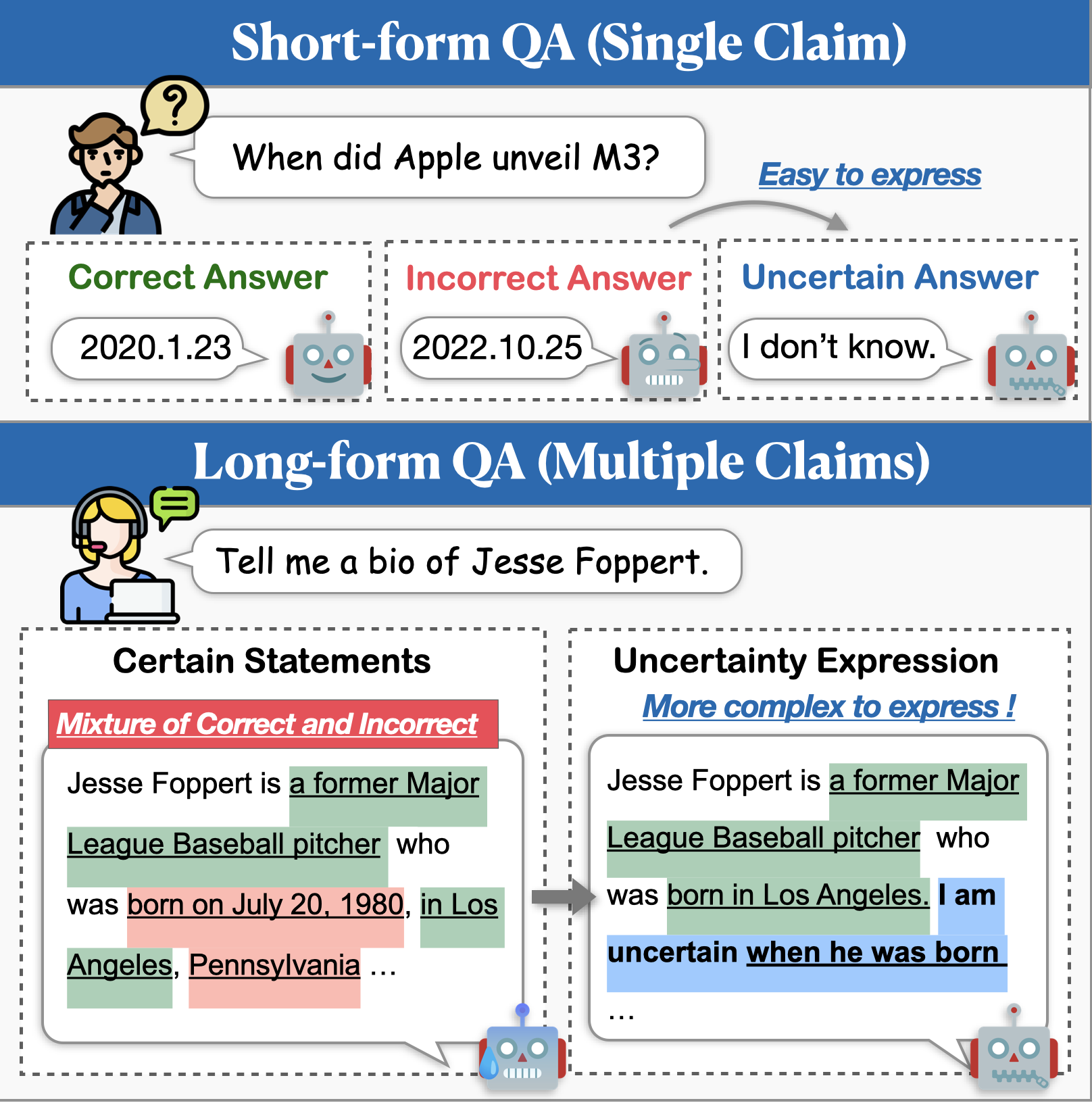

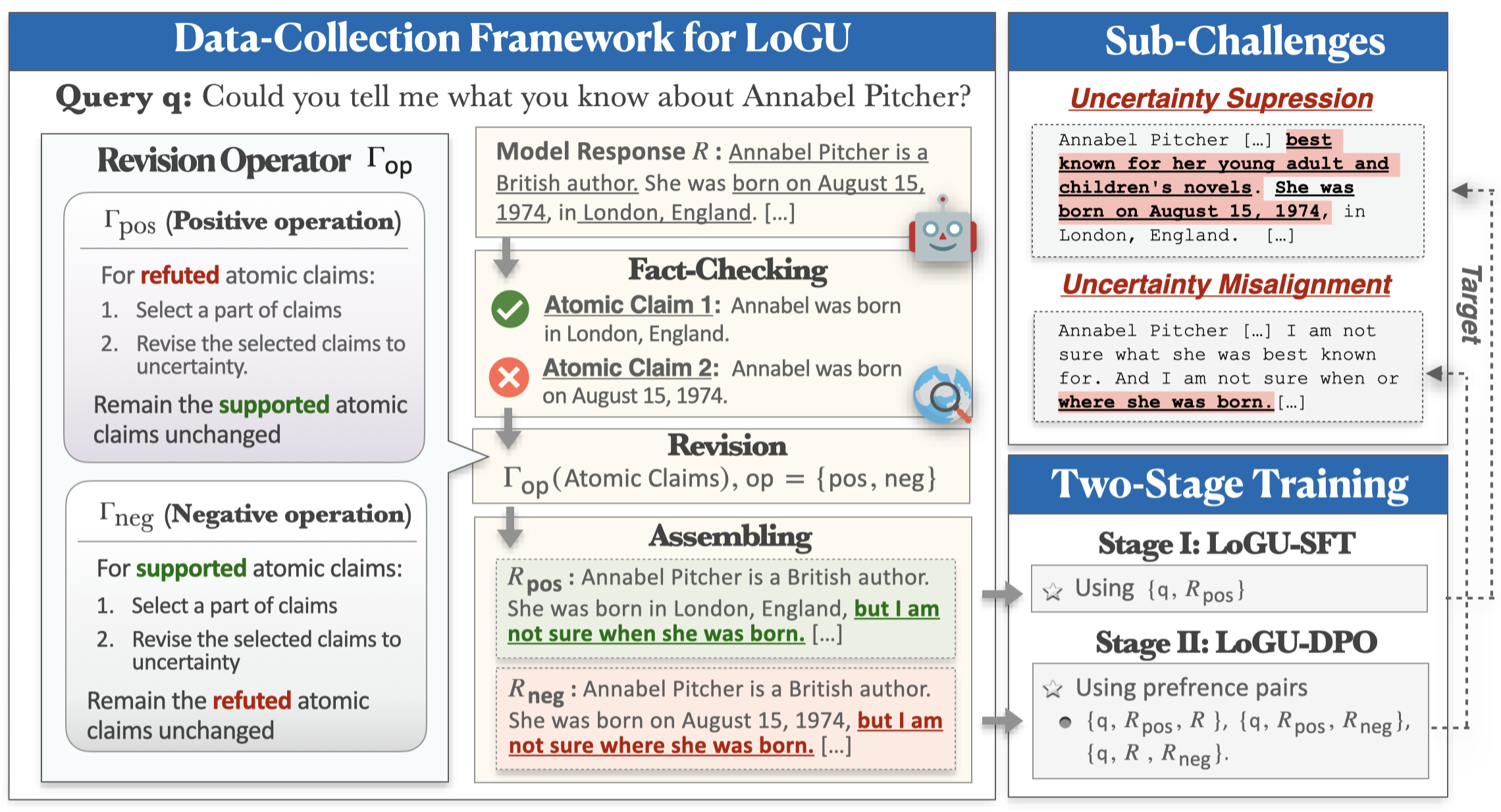

儘管大型語言模型(LLMS)表現出令人印象深刻的功能,但它們仍然在產生事實不正確的內容(即幻覺)方面很難。緩解此問題的一種有希望的方法是使模型在不確定時表達不確定性。對不確定性建模的先前研究主要集中在短形式質量質量質量質量質量質量質量質量質量質量質量請QA上,但是現實世界中的應用通常需要更長的響應。在這項工作中,我們介紹了不確定性(LOGU)的長形成生成任務。我們確定了兩個關鍵的挑戰:不確定性抑制,模型猶豫表達不確定性和不確定性未對準,其中模型不准確地傳達了不確定性。

為了應對這些挑戰,我們提出了一個基於改進的數據收集框架和兩階段的培訓管道。我們的框架採用了分裂和糾紛策略,根據原子主張來完善不確定性。然後,通過監督的微調(SFT)和直接偏好優化(DPO)將收集的數據用於訓練中,以增強不確定性表達。數據集之後的三個長形教學的廣泛實驗表明,我們的方法顯著提高了準確性,降低幻覺並保持響應的全面性。

您可以使用以下命令為Logu安裝環境:

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txt嘗試以下命令測試我們關於BIOS,Longfact,Wildhallu的方法:

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.sh即將推出!

我們還在Fast Trail的HuggingFace模型中心上提供了一些不確定性表達模型:

| 模型 | 關聯 |

|---|---|

| Rhyang2021/unctaine_llama3_8b | 擁抱面 |

| Rhyang2021/unctaine_mistral_7b | 擁抱面 |

如果您有任何疑問,請隨時給我發送電子郵件或給我一個問題。