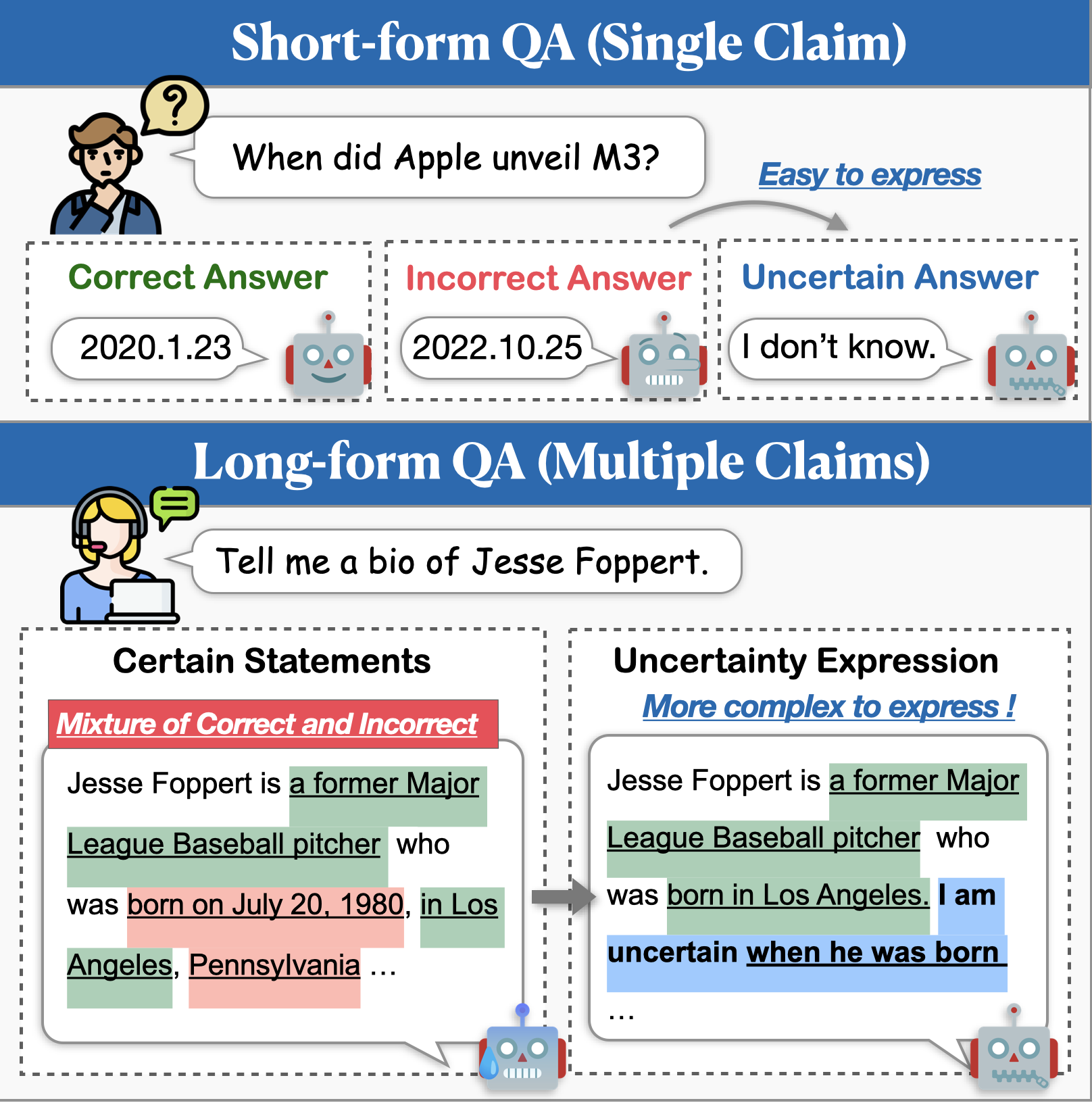

في حين أن نماذج اللغة الكبيرة (LLMS) تُظهر قدرات رائعة ، إلا أنها لا تزال تكافح مع توليد محتوى غير صحيح في الواقع (أي الهلوسة). إن النهج الواعد للتخفيف من هذه المشكلة هو تمكين النماذج من التعبير عن عدم اليقين عندما غير متأكد. ركزت الأبحاث السابقة حول نمذجة عدم اليقين في المقام الأول على ضمان الجودة القصير ، ولكن التطبيقات في العالم الحقيقي تتطلب غالبًا استجابات أطول بكثير. في هذا العمل ، نقدم مهمة توليد النمط الطويل مع عدم اليقين (LOGU). نحدد التحديين الرئيسيين: قمع عدم اليقين ، حيث تتردد النماذج في التعبير عن عدم اليقين ، واختلاف عدم اليقين ، حيث تنقل النماذج عدم اليقين بشكل غير دقيق.

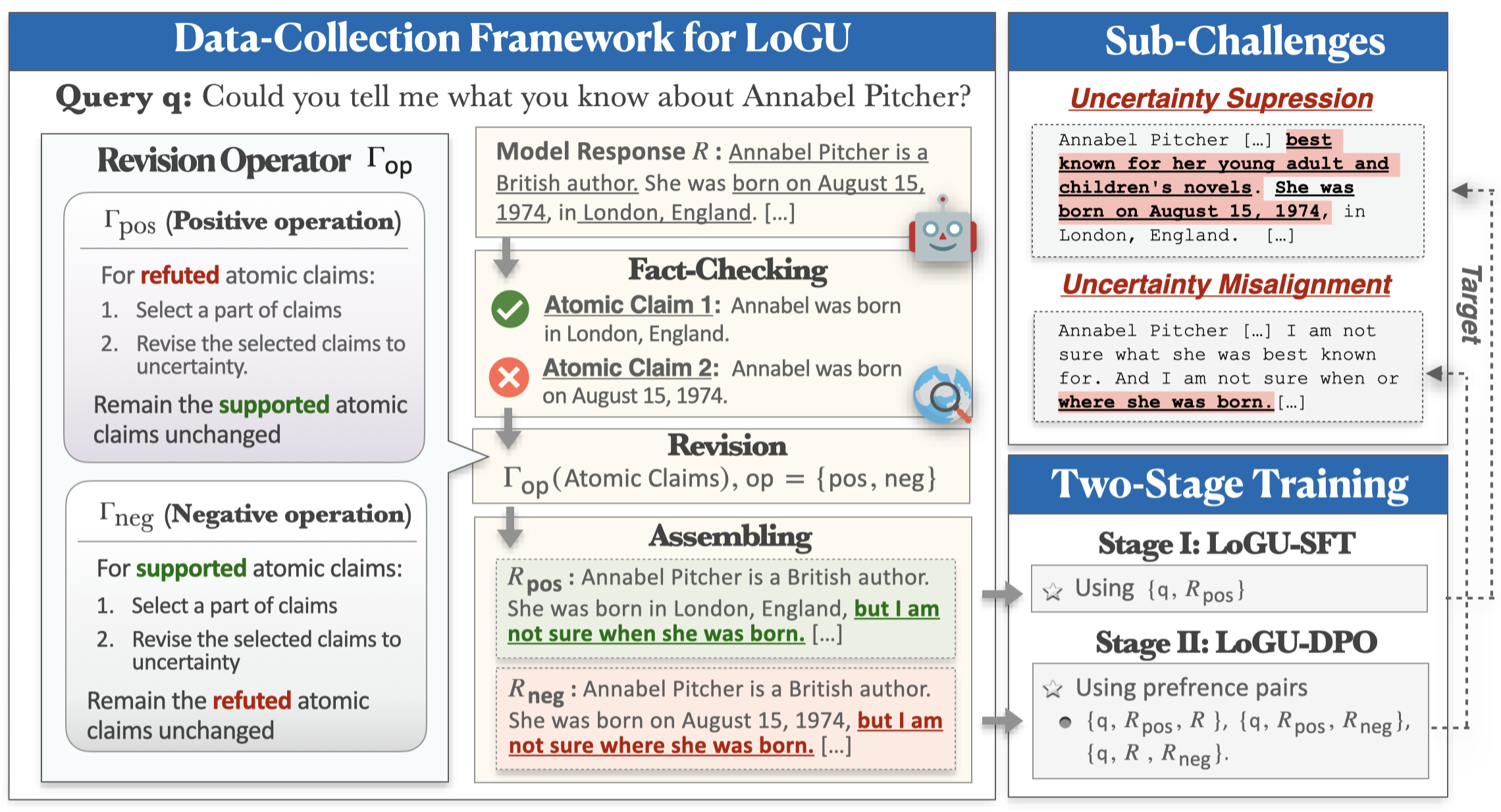

لمعالجة هذه التحديات ، نقترح إطار عمل لجمع البيانات القائم على التحسين وخط أنابيب تدريب على مرحلتين. يتبنى إطار عملنا استراتيجية للفجوة والقوس ، وتحسين عدم اليقين بناءً على المطالبات الذرية. ثم يتم استخدام البيانات التي تم جمعها في التدريب من خلال الضبط الخاضع للإشراف (SFT) وتحسين التفضيل المباشر (DPO) لتعزيز تعبير عدم اليقين. تُظهر تجارب مكثفة على ثلاثة تعليمات طويلة الشكل بعد مجموعات البيانات أن طريقتنا تحسن بشكل كبير من الدقة ، وتقلل من الهلوسة ، وتحافظ على شمولية الاستجابات.

يمكنك استخدام الأوامر التالية لتثبيت البيئة لـ LOGU:

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txtجرب الأمر التالي لاختبار طريقتنا على BIOS ، Longfact ، Wildhallu:

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.shقريباً!

نحن نقدم أيضًا بعض نماذج تعبير عدم اليقين على محور نموذج Huggingface للدرب السريع:

| نموذج | وصلة |

|---|---|

| rhyang2021/uncurner_llama3_8b | luggingface |

| rhyang2021/uncurner_mistral_7b | luggingface |

إذا كان لديك أي أسئلة ، فلا تتردد في مراسلتي عبر البريد الإلكتروني أو إسقاط مشكلة.