LoGU

1.0.0

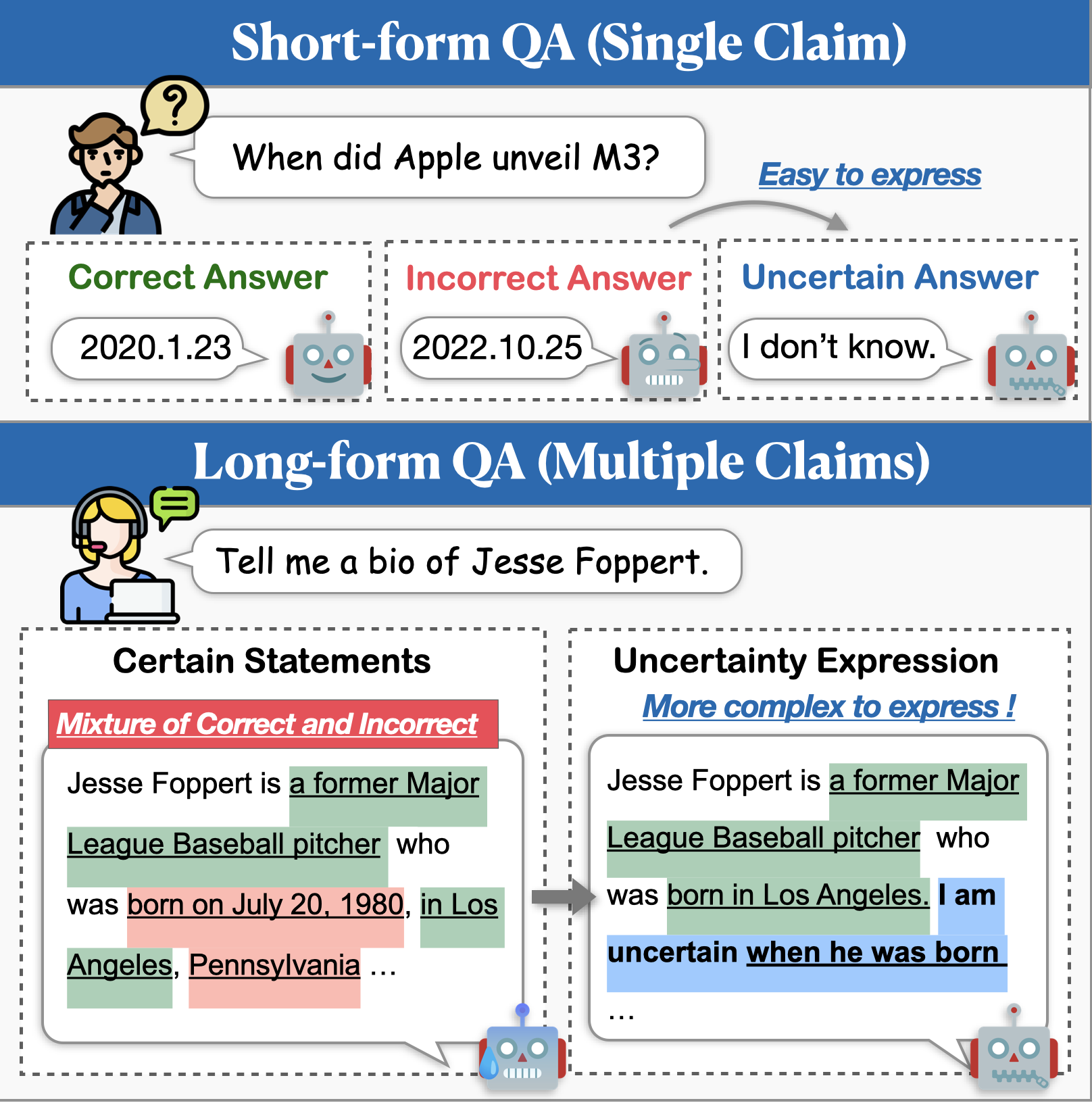

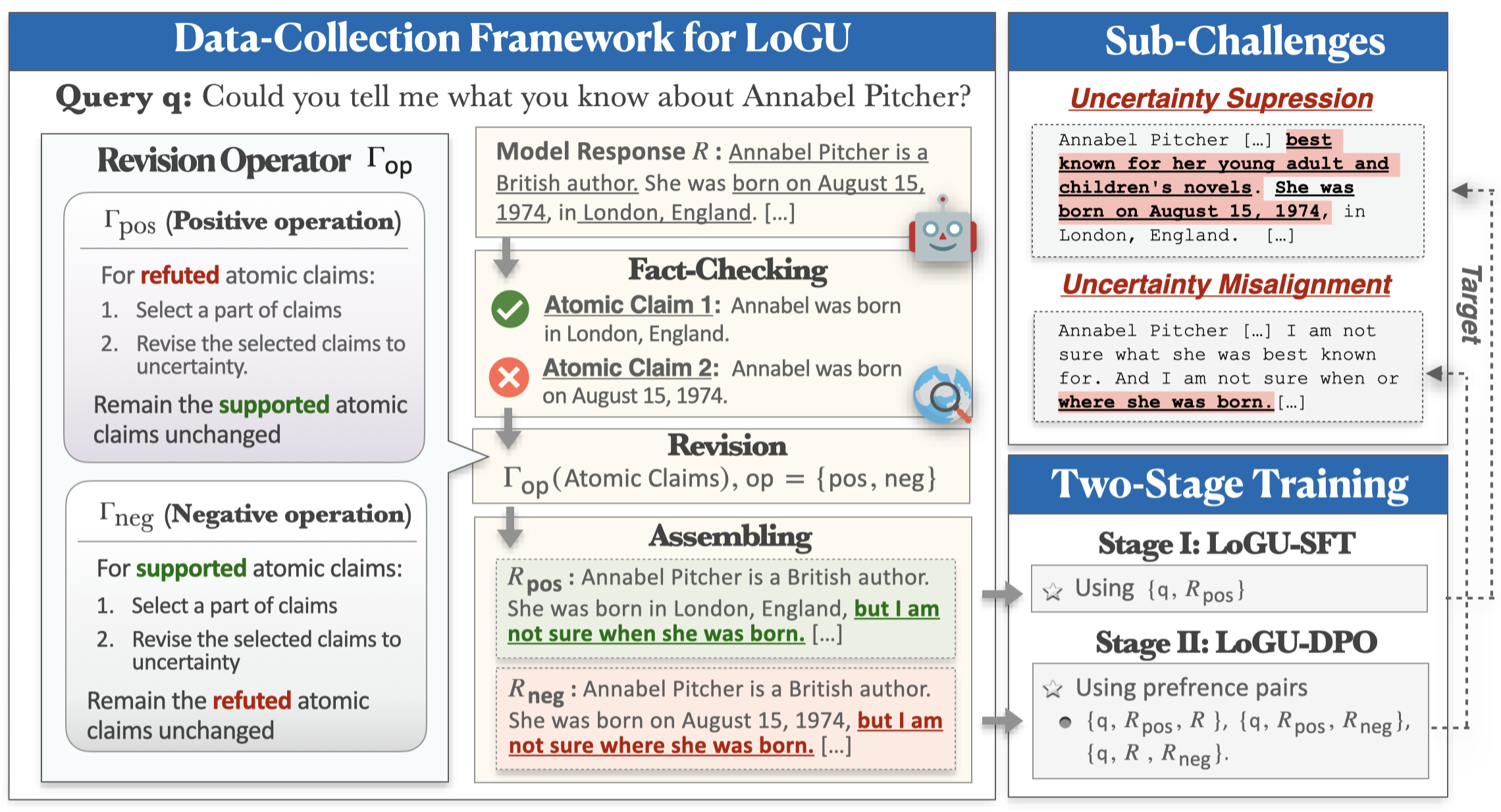

大規模な言語モデル(LLMS)は印象的な能力を示していますが、実際に不正確なコンテンツ(つまり、幻覚)の生成に苦労しています。この問題を軽減するための有望なアプローチは、モデルが不確かなときに不確実性を表現できるようにすることです。不確実性モデリングに関する以前の研究では、主にショートフォームのQAに焦点を当てていますが、実際のアプリケーションでははるかに長い応答が必要です。この作業では、不確実性(logu)を持つ長期生成のタスクを紹介します。 2つの重要な課題を特定します。モデルが不確実性を表現することをためらう不確実性の抑制と、モデルが不正確に不確実性を伝える不確実性の不整合です。

これらの課題に取り組むために、改良ベースのデータ収集フレームワークと2段階のトレーニングパイプラインを提案します。私たちのフレームワークは、原子の主張に基づいて不確実性を改善する分割統治戦略を採用しています。収集されたデータは、不確実性の発現を強化するために、監視された微調整(SFT)および直接選好最適化(DPO)を通じてトレーニングに使用されます。データセットに続く3つの長型命令に関する広範な実験は、この方法が精度を大幅に改善し、幻覚を減らし、応答の包括性を維持することを示しています。

次のコマンドを使用して、loguの環境をインストールできます。

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txt次のコマンドを試して、bios、longfact、wildhalluに関する方法をテストしてください。

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.sh近日公開!

また、高速トレイル用のハギングフェイスモデルハブに不確実な表現モデルを提供します。

| モデル | リンク |

|---|---|

| rhyang2021/cossent_llama3_8b | ハギングフェイス |

| rhyang2021/consect_mistral_7b | ハギングフェイス |

ご質問がある場合は、お気軽にメールでお問い合わせください。