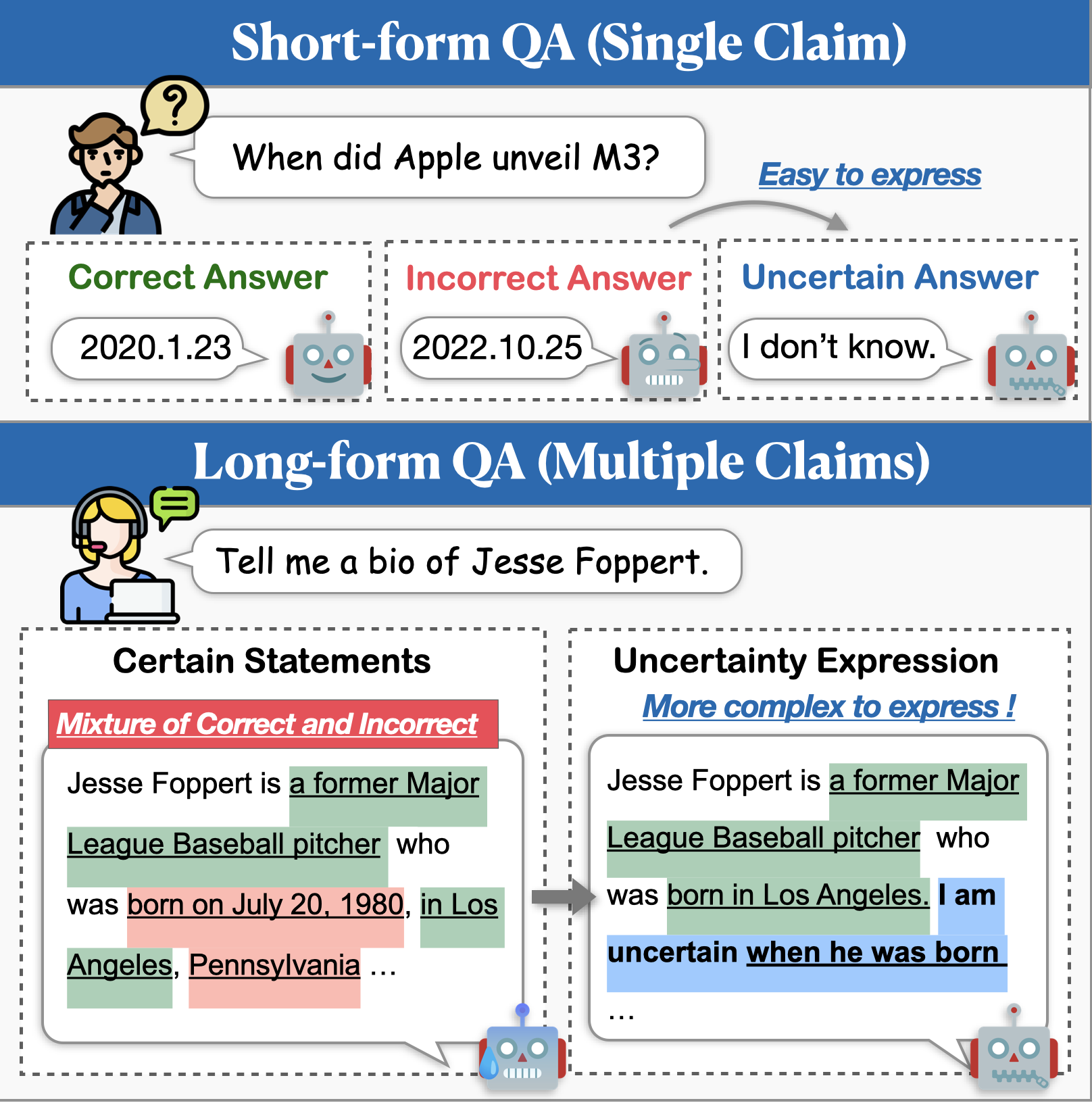

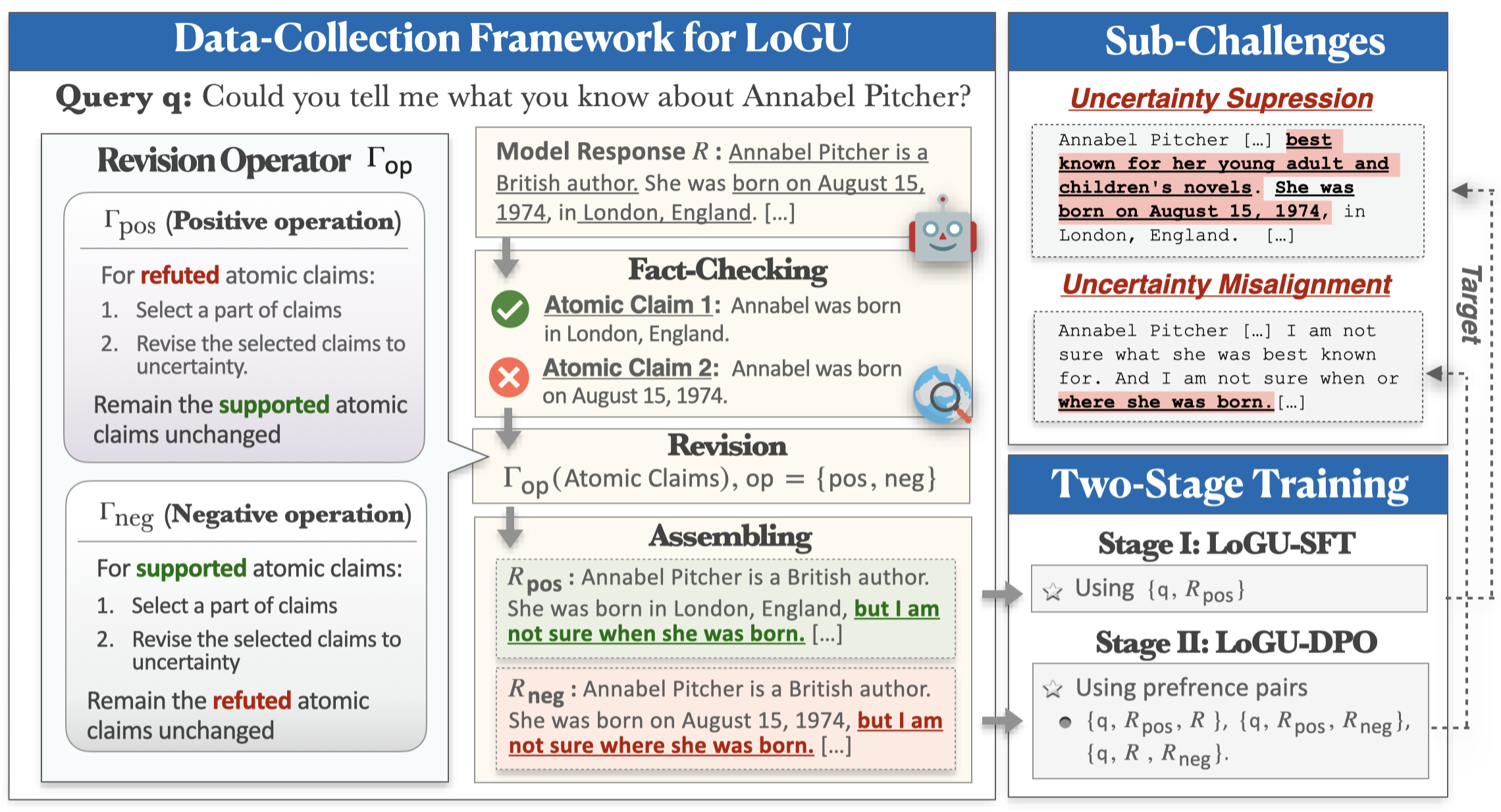

Si bien los modelos de idiomas grandes (LLM) demuestran capacidades impresionantes, todavía tienen dificultades para generar contenido fácticamente incorrecto (es decir, alucinaciones). Un enfoque prometedor para mitigar este problema es permitir que los modelos expresen incertidumbre cuando no están seguros. Investigaciones previas sobre el modelado de incertidumbre se han centrado principalmente en el control de calidad de forma corta, pero las aplicaciones del mundo real a menudo requieren respuestas mucho más largas. En este trabajo, presentamos la tarea de generación de forma larga con incertidumbre (LOGU). Identificamos dos desafíos clave: la supresión de la incertidumbre , donde los modelos dudan en expresar la incertidumbre y la desalineación de la incertidumbre , donde los modelos transmiten incertidumbre de manera inexacta.

Para abordar estos desafíos, proponemos un marco de recopilación de datos basado en el refinamiento y una tubería de capacitación en dos etapas. Nuestro marco adopta una estrategia de división y conquista, refinando la incertidumbre basada en afirmaciones atómicas. Los datos recopilados se usan luego en el entrenamiento a través de ajuste fino supervisado (SFT) y la optimización de preferencia directa (DPO) para mejorar la expresión de incertidumbre. Experimentos extensos sobre tres instrucciones de formato largo después de conjuntos de datos muestran que nuestro método mejora significativamente la precisión, reduce las alucinaciones y mantiene la amplitud de las respuestas.

Puede usar los siguientes comandos para instalar el entorno para Logu:

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txtPruebe el siguiente comando para probar nuestro método en BIOS, Longfact, Wildhallu:

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.sh¡Muy pronto!

También proporcionamos algunos modelos de expresión de incertidumbre en el HuB Model de Huggingface para Trail Fast:

| Modelo | Enlace |

|---|---|

| Rhyang2021/Incerter_llama3_8b | Cara de abrazo |

| Rhyang2021/Incerter_Mistral_7b | Cara de abrazo |

Si tiene alguna pregunta, no dude en enviarme un correo electrónico o enviarme un problema.