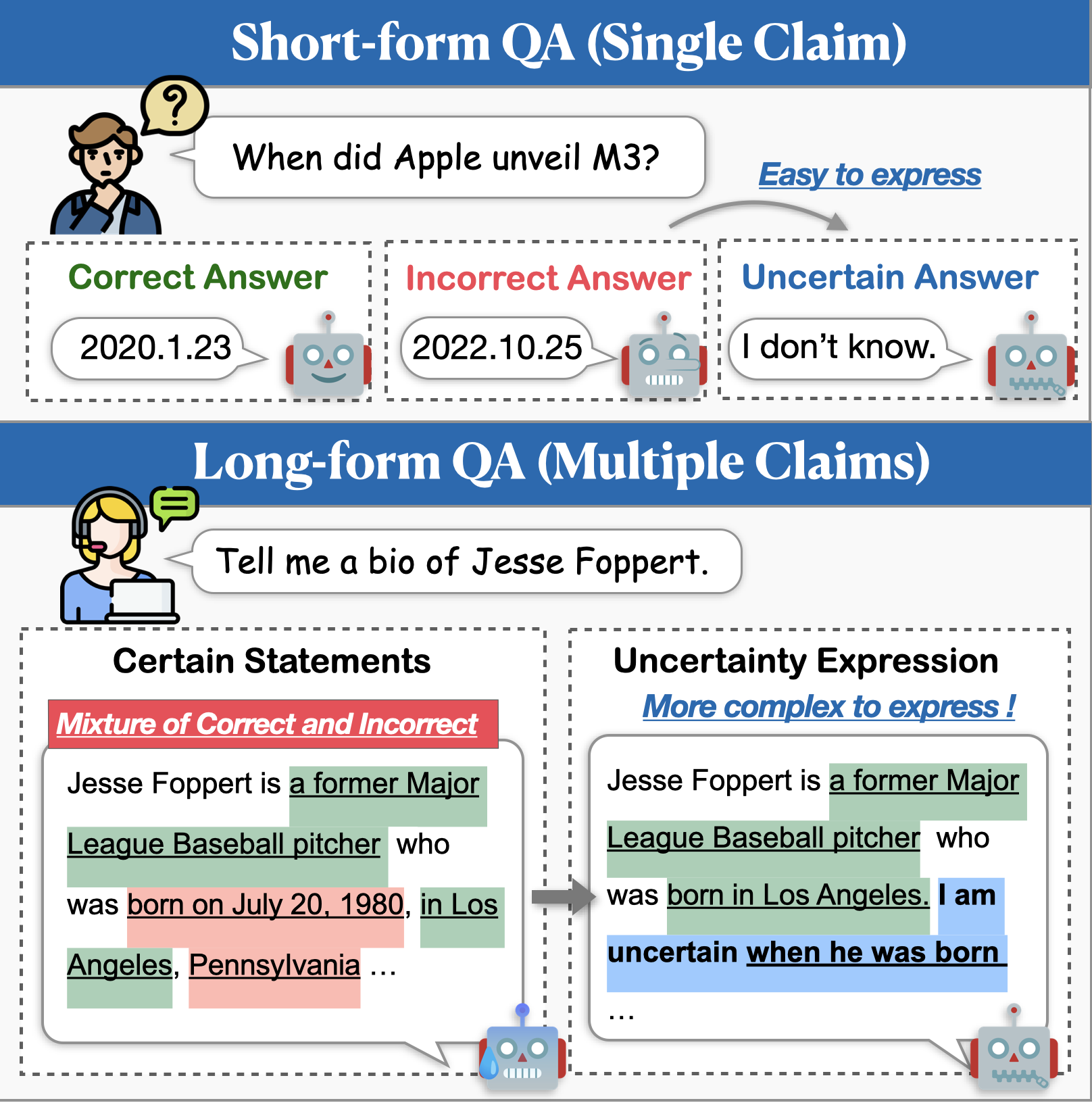

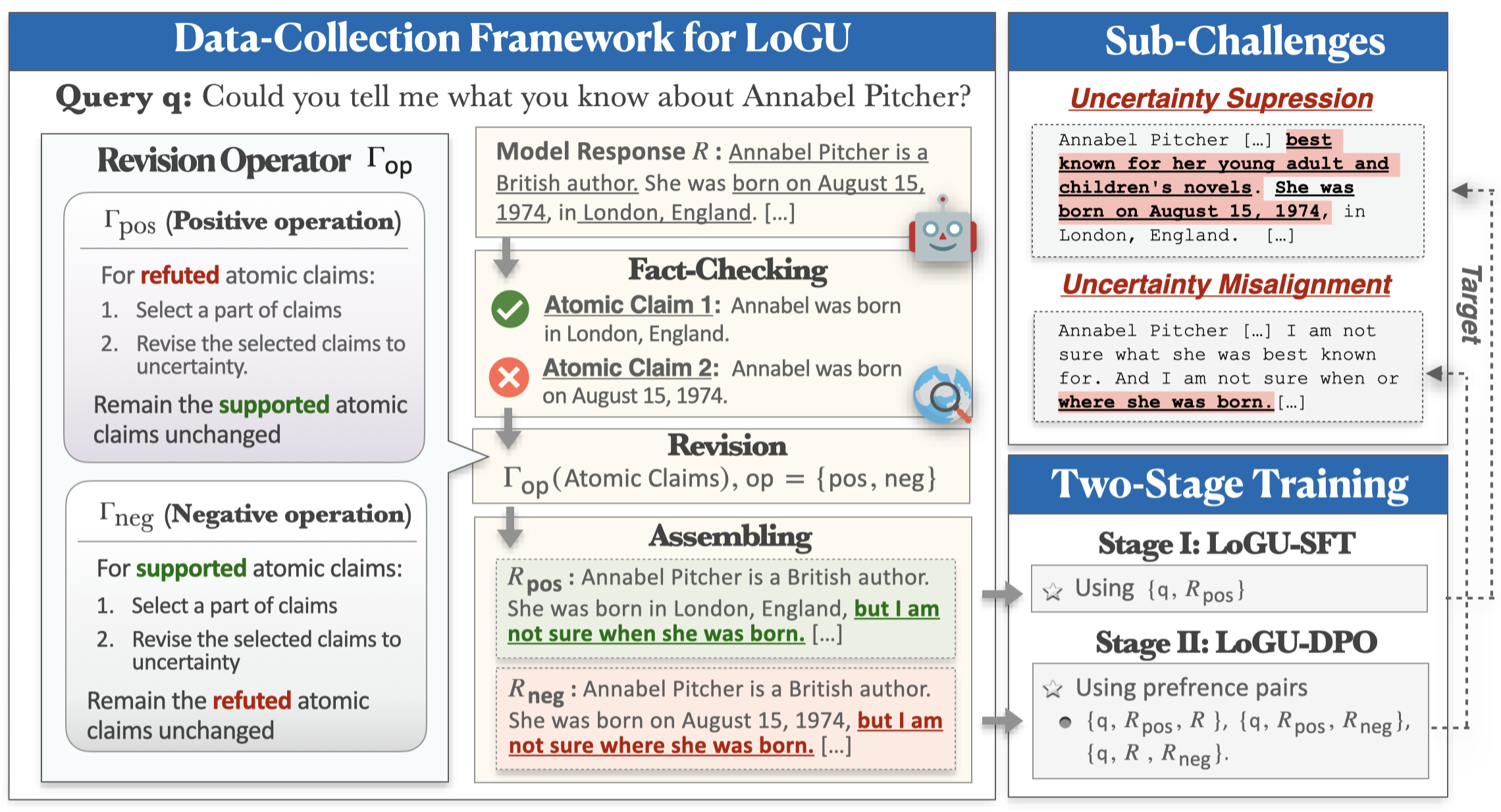

Während große Sprachmodelle (LLMs) beeindruckende Fähigkeiten zeigen, haben sie immer noch Schwierigkeiten, fakten falsche Inhalte (dh Halluzinationen) zu erzeugen. Ein vielversprechender Ansatz zur Minderung dieses Problems besteht darin, dass Modelle die Unsicherheit ausdrücken, wenn sie sich nicht sicher ausdrücken. Frühere Untersuchungen zur Unsicherheitsmodellierung haben sich in erster Linie auf kurzfristige QA konzentriert, aber reale Anwendungen erfordern häufig viel längere Antworten. In dieser Arbeit stellen wir die Aufgabe der Langformgenerierung mit Unsicherheit vor (Logu). Wir identifizieren zwei wichtige Herausforderungen: Unterdrückung der Unsicherheit , bei denen Modelle zögern, Unsicherheit auszudrücken, und Unsicherheit Fehlausrichtung , bei denen Modelle die Unsicherheit ungenau vermitteln.

Um diese Herausforderungen zu bewältigen, schlagen wir einen raffinierungsbasierten Datenerfassungsrahmen und eine zweistufige Trainingspipeline vor. In unserem Rahmen werden eine Strategie zur Kluft und Konquer angewendet, die die Unsicherheit auf der Grundlage von Atomansprüchen verfeinert. Die gesammelten Daten werden dann im Training durch beaufsichtigte Feinabstimmung (SFT) und direkte Präferenzoptimierung (DPO) verwendet, um die Unsicherheitsexpression zu verbessern. Umfangreiche Experimente zu drei Langformanweisungen, die nach Datensätzen folgen, zeigen, dass unsere Methode die Genauigkeit erheblich verbessert, die Halluzinationen verringert und die Vollständigkeit der Antworten beibehält.

Sie können die folgenden Befehle verwenden, um die Umgebung für Logu zu installieren:

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txtVersuchen Sie den folgenden Befehl, um unsere Methode auf BIOS, Longfact, Wildhallu zu testen:

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.shBald kommen!

Wir bieten auch einige Modelle für Unsicherheitxpression auf dem Huggingface -Modell -Hub für Fast Trail:

| Modell | Link |

|---|---|

| rhyang2021/unsicherheit_llama3_8b | Umarmung |

| rhyang2021/unsicherheit_mistal_7b | Umarmung |

Wenn Sie Fragen haben, können Sie mir bitte eine E -Mail senden oder mir ein Problem geben.