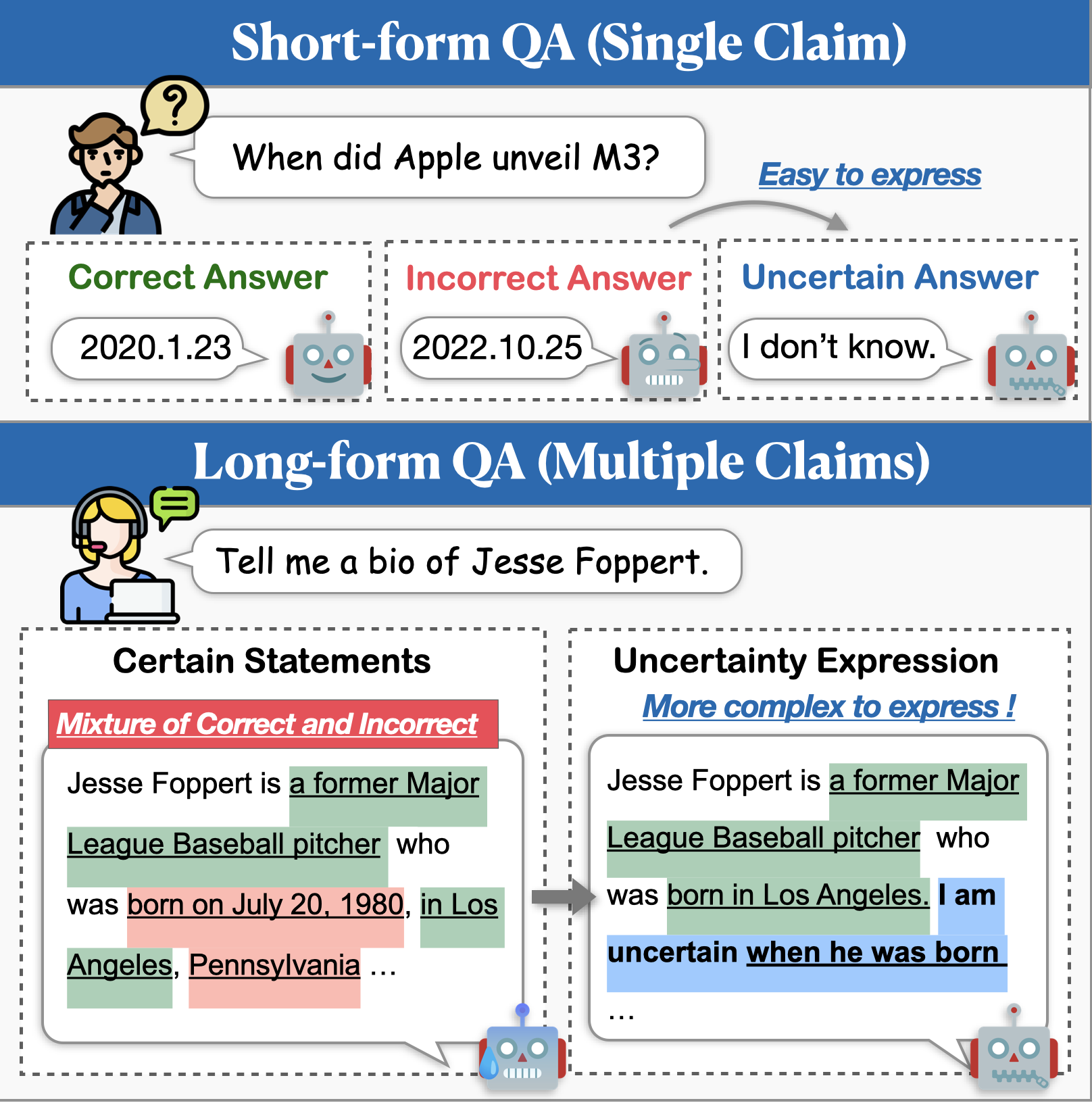

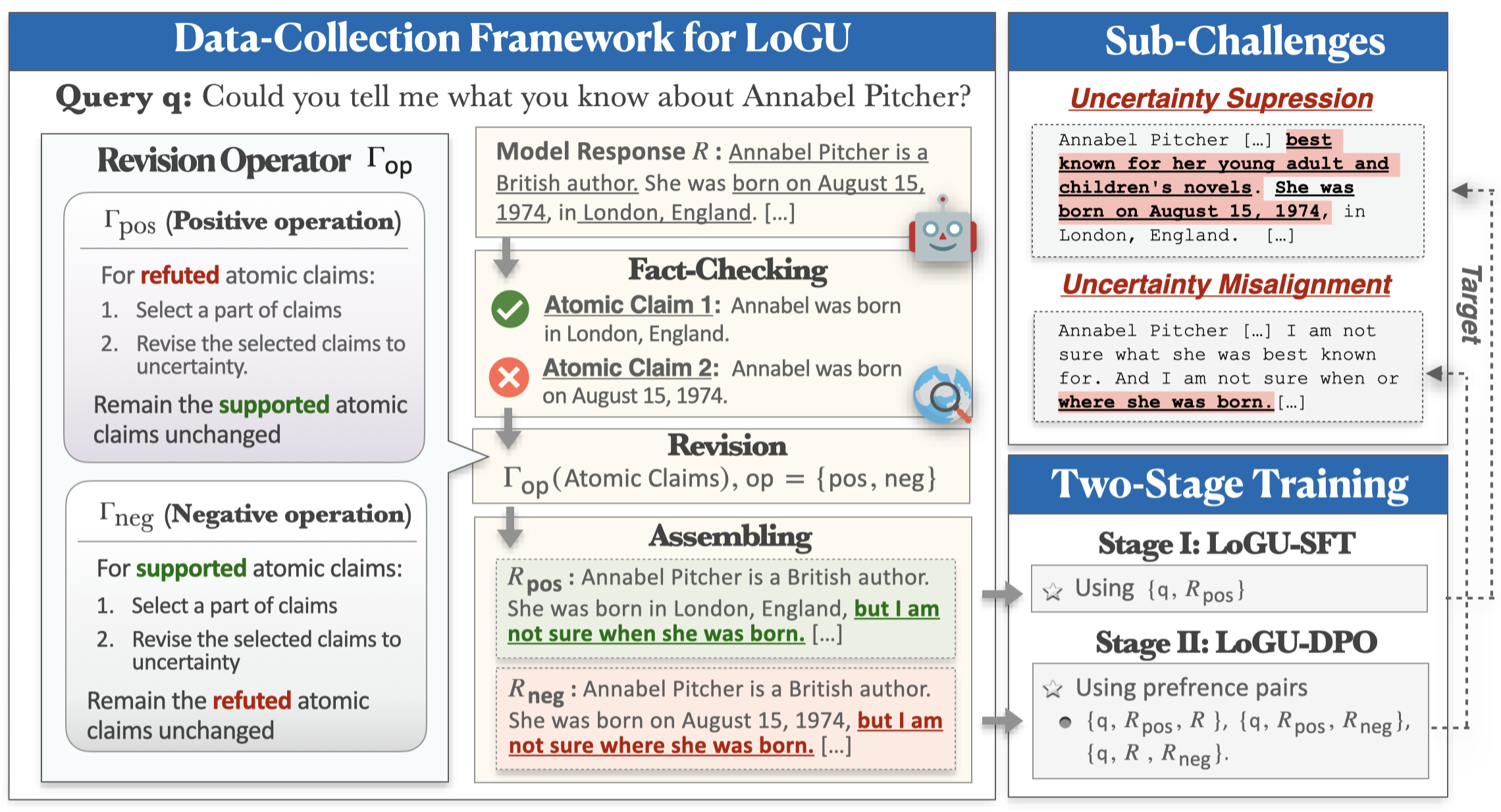

LLMS (Large Language Models)는 인상적인 기능을 보여 주지만 여전히 잘못된 콘텐츠 (예 : 환각)를 생성하는 데 어려움을 겪고 있습니다. 이 문제를 완화하기위한 유망한 접근 방식은 확실하지 않은 경우 모델이 불확실성을 표현할 수있게하는 것입니다. 불확실성 모델링에 대한 이전의 연구는 주로 짧은 형태의 QA에 중점을 두었지만 실제 응용 프로그램은 종종 훨씬 더 긴 응답이 필요합니다. 이 작업에서, 우리는 불확실성 (LOGU)과 함께 장식 세대의 과제를 소개합니다. 우리는 모델이 불확실성을 표현하는 데 주저하는 불확실성 억제 와 불확실성 오정렬 , 즉 모델이 불확실성을 부정하게 전달하는 두 가지 주요 과제를 식별합니다.

이러한 과제를 해결하기 위해 정제 기반 데이터 수집 프레임 워크와 2 단계 교육 파이프 라인을 제안합니다. 우리의 프레임 워크는 분열 및 정복 전략을 채택하여 원자 적 주장에 근거한 불확실성을 정제합니다. 그런 다음 수집 된 데이터는 감독 된 미세 조정 (SFT) 및 DPO (Direct Preference Optimization)를 통해 훈련에 사용되어 불확실성 표현을 향상시킵니다. 데이터 세트에 따른 세 가지 장형 명령에 대한 광범위한 실험은 우리의 방법이 정확도를 크게 향상시키고 환각을 줄이며 응답의 포괄적 성을 유지한다는 것을 보여줍니다.

다음 명령을 사용하여 Logu 용 환경을 설치할 수 있습니다.

conda create -n LoGU python==3.8

conda activate LoGU

pip install -r lf_requirements.txt

pip install -r vllm_requirements.txtBIOS, Longfact, Wildhallu에서 우리의 방법을 테스트하려면 다음 명령을 시도하십시오.

cd ./scripts

bash generate_vllm_responses.shbash eval_pipeline.shbash generate_unc_answers.sh

bash factcheck_unc_answers.sh곧 올 것입니다!

또한 Fast Trail의 Huggingface 모델 허브에 불확실성 표현 모델을 제공합니다.

| 모델 | 링크 |

|---|---|

| Rhyang2021/불확실한 _llama3_8b | 포옹 페이스 |

| Rhyang2021/uncenge_mistral_7b | 포옹 페이스 |

궁금한 점이 있으시면 저에게 이메일을 보내거나 문제를 제기하십시오.