此工具使您可以使用一鍵單擊!

16GB RAM。12GB VRAM的GPU。pytorch安裝命令:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 CUDA 11.7安裝: https://developer.nvidia.com/cuda-11-7-0-download-archive

zlib dll安裝: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html#install-zlib-windows

手動安裝pyopenjtalk: pip install -U pyopenjtalk --no-build-isolation

conda create -n one-click-vits python=3.8conda activate one-click-vitsgit clone https://github.com/ORI-Muchim/One-Click-VITS-Training.git cd One-Click-VITS-Trainingpip install -r requirements.txt將音頻文件如下。

.mp3或.wav文件還可以。

One-Click-VITS-Training

├────datasets

│ ├───speaker0

│ │ ├────1.mp3

│ │ └────1.wav

│ └───speaker1

│ │ ├───1.mp3

│ │ └───1.wav

│ ├integral.py

│ └integral_low.py

│

├────vits

├────inference.py

├────main_low.py

├────main_resume.py

├────main.py

├────Readme.md

└────requirements.txt

這只是一個例子,可以添加更多揚聲器。

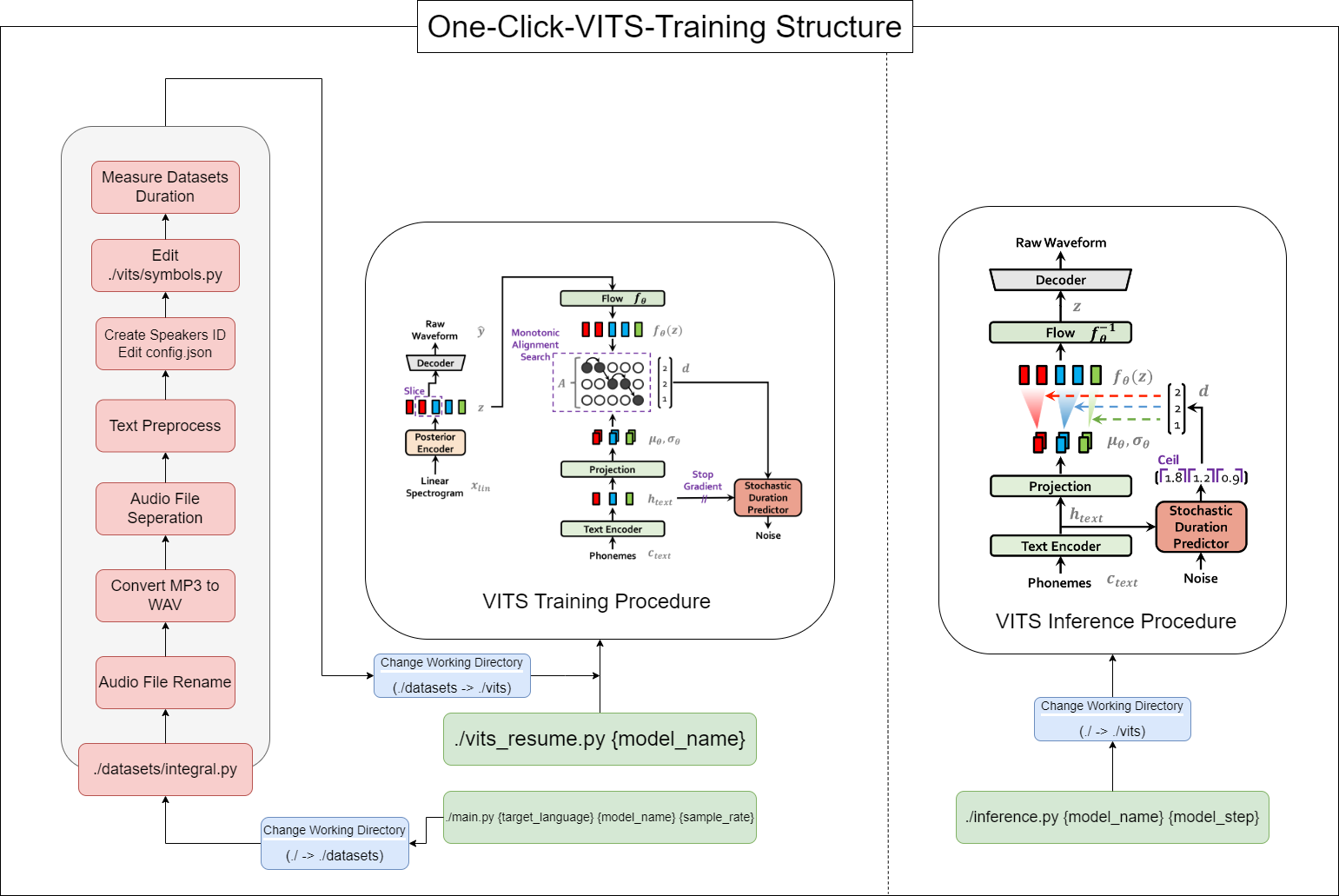

要啟動此工具,請使用以下命令,替換{language},{model_name}和{sample_rate}的{sample_rate}使用您的值({language:ko,ja,en,en,zh} / {sample_rate:22050 /44100}):

python main.py {language} {model_name} {sample_rate}對於規格低的人(VRAM <12GB),請使用此代碼:

python main_low.py {language} {model_name} {sample_rate}如果數據配置已完成並且要恢復培訓,請輸入此代碼:

python main_resume.py {model_name}訓練模型後,您可以使用以下命令來生成預測,以{model_name}和{model_step}的範圍用相應的值替換:

python inference.py {model_name} {model_step}或檢查./vits/inference.ipynb。

如果要更改參考中使用的示例文本,請修改./vits/inferencems.py text部分。

在cjangcjengh/vits的存儲庫中,我對韓國文本清潔方法進行了一些修改。通過將其發佈到cjangcjengh存儲庫中,另一個清潔過程是相同的,但是使用Tenebo/g2pk2庫修改了清潔劑文件,以韓語發音。

有關更多信息,請參閱以下存儲庫: