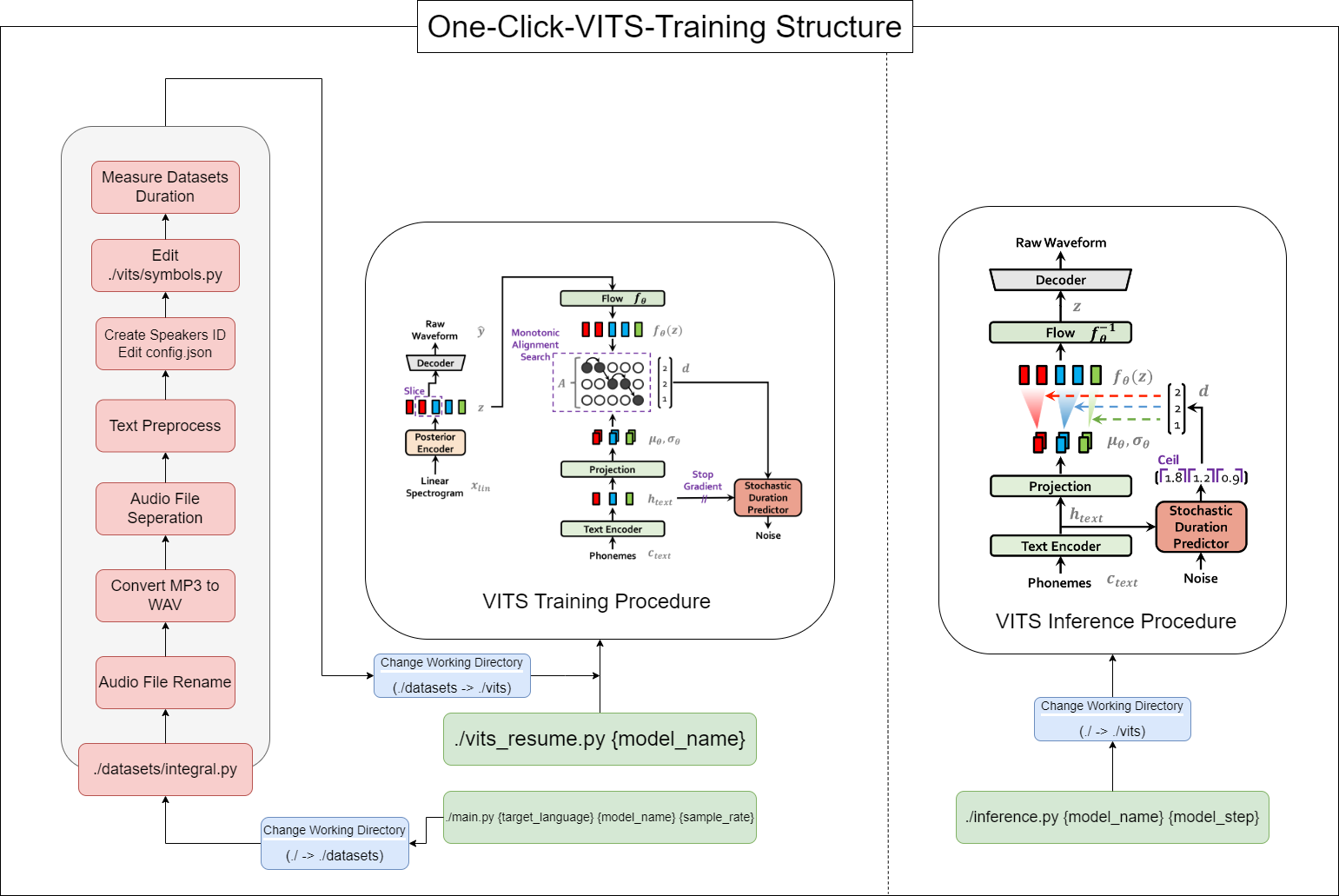

تتيح لك هذه الأداة إكمال عملية FITs بأكملها (المعالجة المسبقة للبيانات + Whisper ASR + Text Preprocessing + Modification Config.json + التدريب ، الاستدلال) بنقرة واحدة!

16GB .12GB من VRAM.أمر تثبيت Pytorch:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 CUDA 11.7 تثبيت: https://developer.nvidia.com/cuda-11-7-0-download-archive

Zlib DLL تثبيت: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html#install-zlib-windows

تثبيت pyopenjtalk يدويًا: pip install -U pyopenjtalk --no-build-isolation

conda create -n one-click-vits python=3.8conda activate one-click-vitsgit clone https://github.com/ORI-Muchim/One-Click-VITS-Training.git cd One-Click-VITS-Trainingpip install -r requirements.txtضع ملفات الصوت على النحو التالي.

.MP3 أو .WAV Files على ما يرام.

One-Click-VITS-Training

├────datasets

│ ├───speaker0

│ │ ├────1.mp3

│ │ └────1.wav

│ └───speaker1

│ │ ├───1.mp3

│ │ └───1.wav

│ ├integral.py

│ └integral_low.py

│

├────vits

├────inference.py

├────main_low.py

├────main_resume.py

├────main.py

├────Readme.md

└────requirements.txt

هذا مجرد مثال ، ولا بأس في إضافة المزيد من مكبرات الصوت.

لبدء هذه الأداة ، استخدم الأمر التالي ، استبدال {language} ، {model_name} ، و {sample_rate} مع قيم كل منهما ({اللغة: ko ، ja ، en ، zh} / {sample_rate: 22050 /44100}):

python main.py {language} {model_name} {sample_rate}بالنسبة لأولئك الذين لديهم مواصفات منخفضة (VRAM <12 جيجابايت) ، يرجى استخدام هذا الرمز:

python main_low.py {language} {model_name} {sample_rate}إذا اكتمل تكوين البيانات وتريد استئناف التدريب ، أدخل هذا الرمز:

python main_resume.py {model_name}بعد تدريب النموذج ، يمكنك إنشاء تنبؤات باستخدام الأمر التالي ، واستبدال {model_name} و {model_step} مع قيم كل منهما:

python inference.py {model_name} {model_step}أو تحقق ./vits/inference.ipynb.

إذا كنت ترغب في تغيير النص المثال المستخدم في المرجع ، فقم بتعديل ./vits/inferencems.py جزء text .

في مستودع cjangcjengh/vits ، قمت ببعض التعديلات على طريقة تنظيف النص الكورية. عملية التنظيف الأخرى هي نفسها من خلال نشرها إلى مستودع Cjangcjengh ، ولكن تم تعديل الملف الأنظف باستخدام مكتبة Tenebo/G2PK2 كما هو واضح.

لمزيد من المعلومات ، يرجى الرجوع إلى المستودعات التالية: