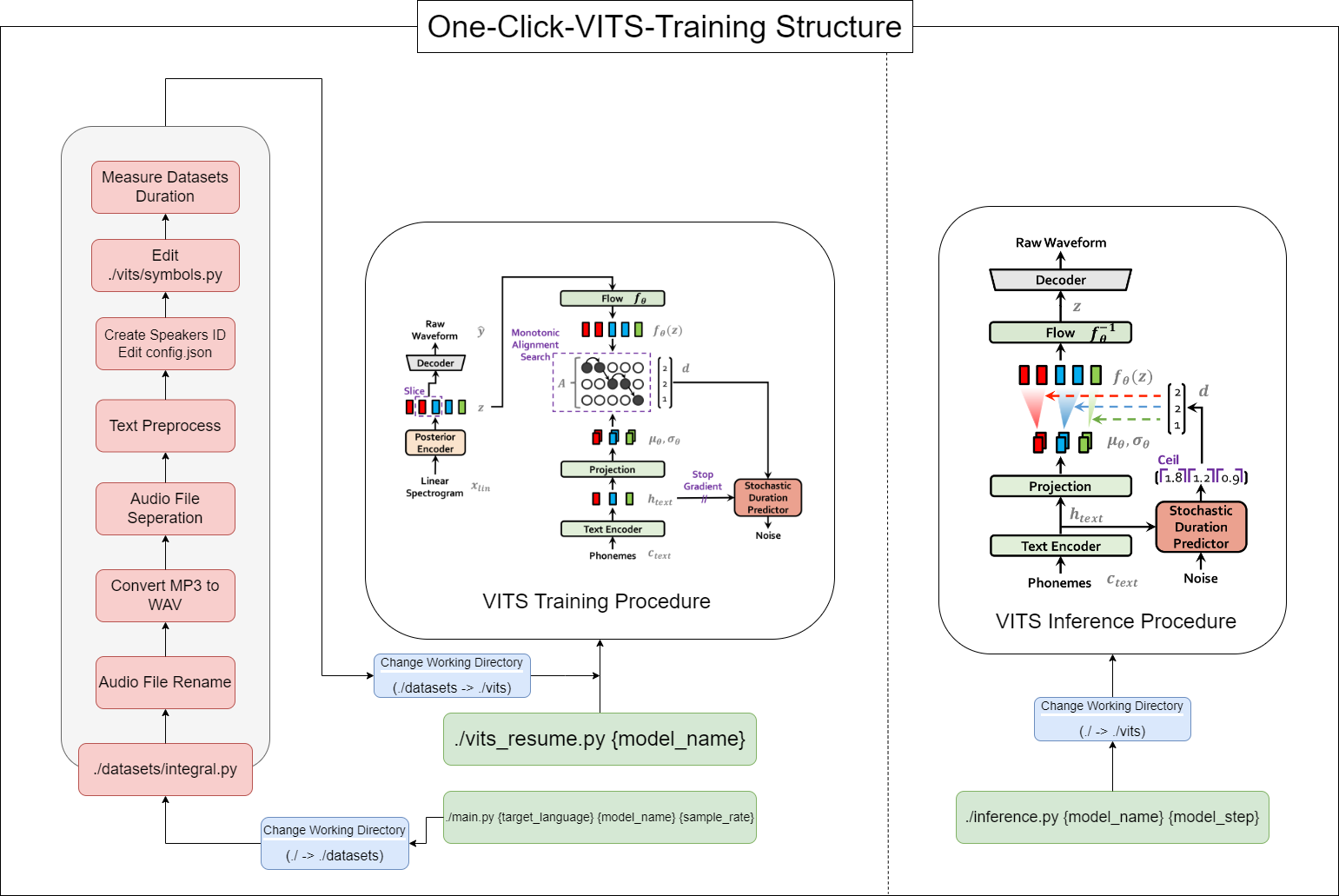

Cet outil vous permet de terminer l'ensemble du processus des VITS (prétraitement des données + Whisper ASR + Prétraitement de texte + Config.json + formation, inférence) avec un clic!

16GB de RAM.12GB de VRAM.Commande d'installation de Pytorch:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 CUDA 11.7 Installation: https://developer.nvidia.com/cuda-11-7-0-download-archive

ZLIB DLL Install: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html#install-zlib-windows

Installer Pyopenjtalk manuellement: pip install -U pyopenjtalk --no-build-isolation

conda create -n one-click-vits python=3.8conda activate one-click-vitsgit clone https://github.com/ORI-Muchim/One-Click-VITS-Training.git cd One-Click-VITS-Trainingpip install -r requirements.txtPlacez les fichiers audio comme suit.

Les fichiers .mp3 ou .wav sont corrects.

One-Click-VITS-Training

├────datasets

│ ├───speaker0

│ │ ├────1.mp3

│ │ └────1.wav

│ └───speaker1

│ │ ├───1.mp3

│ │ └───1.wav

│ ├integral.py

│ └integral_low.py

│

├────vits

├────inference.py

├────main_low.py

├────main_resume.py

├────main.py

├────Readme.md

└────requirements.txt

Ce n'est qu'un exemple, et il est normal d'ajouter plus de haut-parleurs.

Pour démarrer cet outil, utilisez la commande suivante, en remplaçant {Language}, {Model_Name} et {Sample_rate} par vos valeurs respectives ({langage: ko, ja, en, zh} / {samptample_rate: 22050/44100}):

python main.py {language} {model_name} {sample_rate}Pour ceux qui ont de faibles spécifications (VRAM <12 Go), veuillez utiliser ce code:

python main_low.py {language} {model_name} {sample_rate}Si la configuration des données est terminée et que vous souhaitez reprendre la formation, entrez ce code:

python main_resume.py {model_name}Une fois le modèle formé, vous pouvez générer des prédictions en utilisant la commande suivante, en remplaçant {Model_name} et {Model_step} par vos valeurs respectives:

python inference.py {model_name} {model_step}Ou vérifiez ./vits/inference.ipynb.

Si vous souhaitez modifier l'exemple de texte utilisé dans la référence, modifiez ./vits/inferencems.py text Part.

Dans le référentiel de Cjangcjengh / VITS, j'ai apporté quelques modifications à la méthode de nettoyage de texte coréen. L'autre processus de nettoyage est le même en le publiant dans le référentiel Cjangcjengh, mais le fichier plus nettoyant a été modifié à l'aide de la bibliothèque Tenebo / G2PK2 comme prononcé coréen.

Pour plus d'informations, veuillez vous référer aux référentiels suivants: