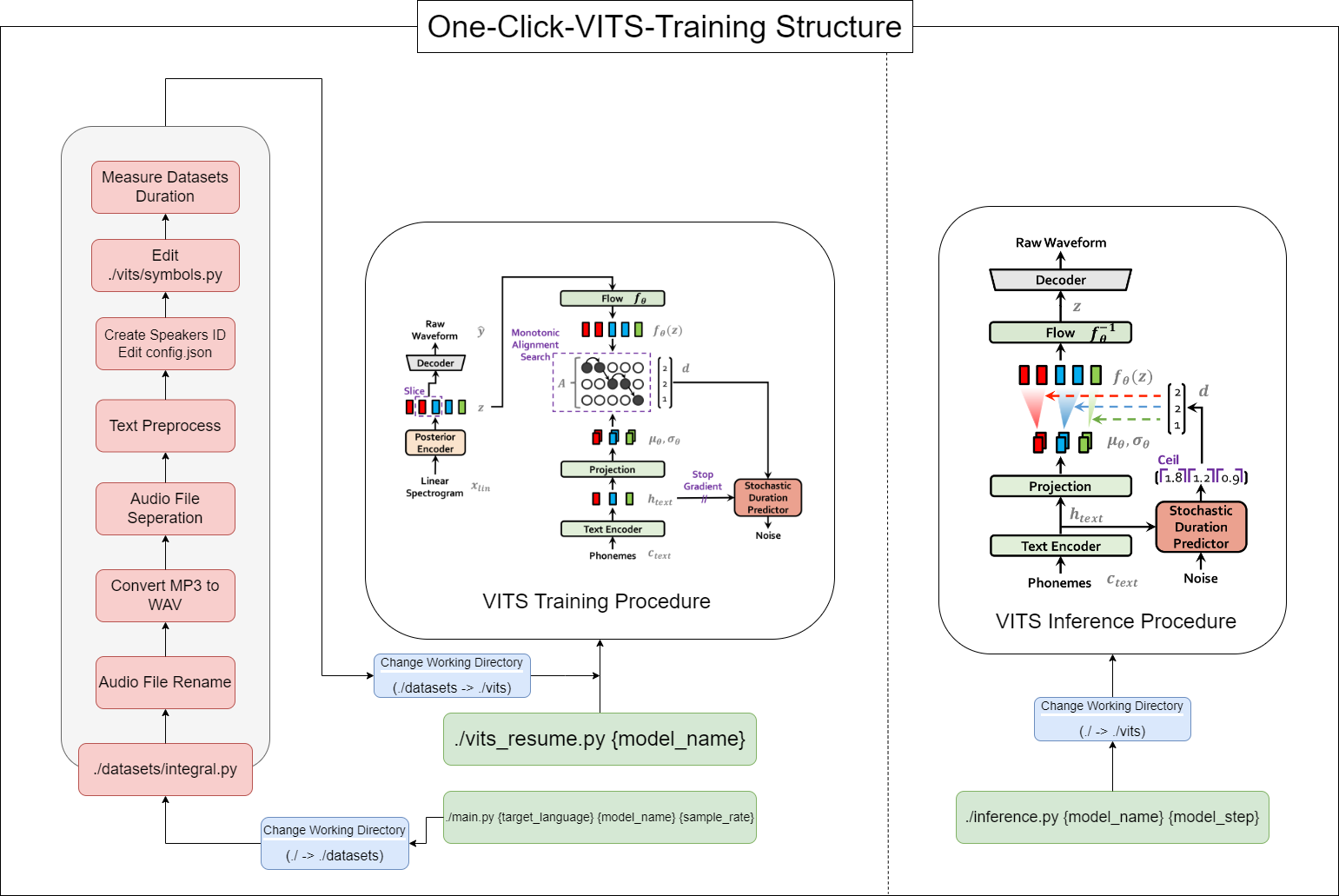

Mit diesem Tool können Sie den gesamten Vorgang von Vits (Datenvorverarbeitung + Flüsterung ASR + Textvorverarbeitung + Modification config.json + Training, Inferenz) mit einem Klick abschließen!

16GB RAM.12GB VRAM.Befehl pytorch installieren:

pip install torch==1.13.1+cu117 torchvision==0.14.1+cu117 torchaudio==0.13.1 --extra-index-url https://download.pytorch.org/whl/cu117 CUDA 11.7 Install: https://developer.nvidia.com/cuda-11-7-0-download-archive

ZLIB DLL Installation: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html#install-zlib-windows

Manuell installieren Sie Pyopenjtalk: pip install -U pyopenjtalk --no-build-isolation

conda create -n one-click-vits python=3.8conda activate one-click-vitsgit clone https://github.com/ORI-Muchim/One-Click-VITS-Training.git cd One-Click-VITS-Trainingpip install -r requirements.txtPlatzieren Sie die Audiodateien wie folgt.

.mp3 oder .wav -Dateien sind in Ordnung.

One-Click-VITS-Training

├────datasets

│ ├───speaker0

│ │ ├────1.mp3

│ │ └────1.wav

│ └───speaker1

│ │ ├───1.mp3

│ │ └───1.wav

│ ├integral.py

│ └integral_low.py

│

├────vits

├────inference.py

├────main_low.py

├────main_resume.py

├────main.py

├────Readme.md

└────requirements.txt

Dies ist nur ein Beispiel und es ist in Ordnung, weitere Lautsprecher hinzuzufügen.

Um dieses Tool zu starten, verwenden Sie den folgenden Befehl, ersetzen Sie {Sprache}, {model_name} und {sample_rate} durch Ihre jeweiligen Werte ({Sprache: Ko, Ja, En, Zh} / {sample_rate: 22050 /44100}):

python main.py {language} {model_name} {sample_rate}Für diejenigen mit niedrigen Spezifikationen (VRAM <12 GB) verwenden Sie diesen Code bitte:

python main_low.py {language} {model_name} {sample_rate}Wenn die Datenkonfiguration abgeschlossen ist und Sie das Training fortsetzen möchten, geben Sie diesen Code ein:

python main_resume.py {model_name}Nachdem das Modell trainiert wurde, können Sie Vorhersagen mithilfe des folgenden Befehls generieren und {model_name} und {model_step} durch Ihre jeweiligen Werte ersetzen:

python inference.py {model_name} {model_step}Oder check ./vits/inference.ipynb.

Wenn Sie den in der Referenz verwendeten Beispieltext ändern möchten, ändern Sie ./vits/inferencems.py text Teil.

Im Repository von Cjangcjengh/vits habe ich einige Änderungen an der koreanischen Textreinigungsmethode vorgenommen. Der andere Reinigungsprozess ist derselbe, indem er es in das CJangcjengh -Repository veröffentlichen, aber die Reiniger -Datei wurde mithilfe der Tenebo/G2PK2 -Bibliothek als Koreanisch geändert.

Weitere Informationen finden Sie unter folgenden Repositories: