在我們的論文中,我們提出了HIFI-GAN:一個基於GAN的模型,能夠有效地產生高忠誠度的語音。

我們將實施和預估計的模型作為此存儲庫中的開源。

摘要:關於語音合成的最近幾項工作已採用生成對抗網絡(GAN)來產生原始波形。儘管此類方法提高了採樣效率和記憶使用量,但它們的樣本質量尚未達到自回歸和基於流動的生成模型的質量。在這項工作中,我們提出了HIFI-GAN,它可以實現有效和高保真的語音綜合。由於語音音頻由具有各個時期的正弦信號組成,因此我們證明了音頻的建模週期性模式對於提高樣品質量至關重要。單個揚聲器數據集的主觀人類評估(平均意見分數,MOS)表明,我們提出的方法與人類質量相似,同時在單個V100 GPU上產生比實時快的22.05 kHz高保真音頻167.9倍。我們進一步展示了Hifi-GAN的通用性與看不見的說話者和端到端語音綜合的旋轉光譜反演。最後,HIFI-GAN的小足跡版本的樣品比實時的CPU生成13.4倍,其質量與自動回歸對應物的質量可比。

訪問我們的演示網站以獲取音頻樣本。

LJSpeech-1.1/wavs python train.py --config config_v1.json

要訓練V2或V3生成器,請用config_v2.json或config_v3.json替換config_v1.json 。

默認情況下,檢查點和配置文件的副本保存在cp_hifigan目錄中。

您可以通過添加--checkpoint_path選項來更改路徑。

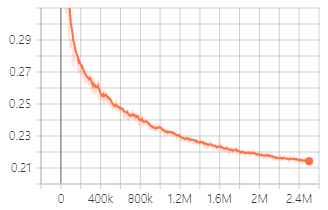

V1發電機培訓期間的驗證損失。

您也可以使用我們提供的驗證型號。

下載驗證的型號

每個文件夾的詳細信息如下:

| 文件夾名稱 | 發電機 | 數據集 | 微調 |

|---|---|---|---|

| LJ_V1 | V1 | ljspeech | 不 |

| LJ_V2 | v2 | ljspeech | 不 |

| LJ_V3 | V3 | ljspeech | 不 |

| lj_ft_t2_v1 | V1 | ljspeech | 是(tacotron2) |

| lj_ft_t2_v2 | v2 | ljspeech | 是(tacotron2) |

| lj_ft_t2_v3 | V3 | ljspeech | 是(tacotron2) |

| VCTK_V1 | V1 | VCTK | 不 |

| VCTK_V2 | v2 | VCTK | 不 |

| VCTK_V3 | V3 | VCTK | 不 |

| Universal_v1 | V1 | 普遍的 | 不 |

我們為通用模型提供了歧視權重,可以用作將學習轉移到其他數據集的基礎。

.npy 。 Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset文件夾,然後將生成的MEL-SPECTROGRAM文件複製到其中。 python train.py --fine_tuning True --config config_v1.json

test_files目錄並將WAV文件複製到目錄中。 python inference.py --checkpoint_file [generator checkpoint file path]

默認情況下,生成的WAV文件保存在generated_files中。

您可以通過添加--output_dir選項來更改路徑。

test_mel_files目錄和復制生成的MEL-SPECTROGRAM文件複製到目錄中。 python inference_e2e.py --checkpoint_file [generator checkpoint file path]

默認情況下,生成的WAV文件保存在generated_files_from_mel中。

您可以通過添加--output_dir選項來更改路徑。

我們提到了Waveglow,Melgan和Tacotron2來實現這一點。