在我们的论文中,我们提出了HIFI-GAN:一个基于GAN的模型,能够有效地产生高忠诚度的语音。

我们将实施和预估计的模型作为此存储库中的开源。

摘要:关于语音合成的最近几项工作已采用生成对抗网络(GAN)来产生原始波形。尽管此类方法提高了采样效率和记忆使用量,但它们的样本质量尚未达到自回归和基于流动的生成模型的质量。在这项工作中,我们提出了HIFI-GAN,它可以实现有效和高保真的语音综合。由于语音音频由具有各个时期的正弦信号组成,因此我们证明了音频的建模周期性模式对于提高样品质量至关重要。单个扬声器数据集的主观人类评估(平均意见分数,MOS)表明,我们提出的方法与人类质量相似,同时在单个V100 GPU上产生比实时快的22.05 kHz高保真音频167.9倍。我们进一步展示了Hifi-GAN的通用性与看不见的说话者和端到端语音综合的旋转光谱反演。最后,HIFI-GAN的小足迹版本的样品比实时的CPU生成13.4倍,其质量与自动回归对应物的质量可比。

访问我们的演示网站以获取音频样本。

LJSpeech-1.1/wavs python train.py --config config_v1.json

要训练V2或V3生成器,请用config_v2.json或config_v3.json替换config_v1.json 。

默认情况下,检查点和配置文件的副本保存在cp_hifigan目录中。

您可以通过添加--checkpoint_path选项来更改路径。

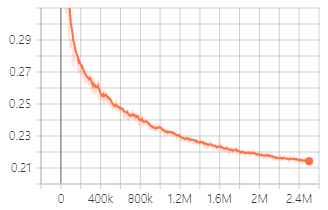

V1发电机培训期间的验证损失。

您也可以使用我们提供的验证型号。

下载验证的型号

每个文件夹的详细信息如下:

| 文件夹名称 | 发电机 | 数据集 | 微调 |

|---|---|---|---|

| LJ_V1 | V1 | ljspeech | 不 |

| LJ_V2 | v2 | ljspeech | 不 |

| LJ_V3 | V3 | ljspeech | 不 |

| lj_ft_t2_v1 | V1 | ljspeech | 是(tacotron2) |

| lj_ft_t2_v2 | v2 | ljspeech | 是(tacotron2) |

| lj_ft_t2_v3 | V3 | ljspeech | 是(tacotron2) |

| VCTK_V1 | V1 | VCTK | 不 |

| VCTK_V2 | v2 | VCTK | 不 |

| VCTK_V3 | V3 | VCTK | 不 |

| Universal_v1 | V1 | 普遍的 | 不 |

我们为通用模型提供了歧视权重,可以用作将学习转移到其他数据集的基础。

.npy 。 Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset文件夹,然后将生成的MEL-SPECTROGRAM文件复制到其中。 python train.py --fine_tuning True --config config_v1.json

test_files目录并将WAV文件复制到目录中。 python inference.py --checkpoint_file [generator checkpoint file path]

默认情况下,生成的WAV文件保存在generated_files中。

您可以通过添加--output_dir选项来更改路径。

test_mel_files目录和复制生成的MEL-SPECTROGRAM文件复制到目录中。 python inference_e2e.py --checkpoint_file [generator checkpoint file path]

默认情况下,生成的WAV文件保存在generated_files_from_mel中。

您可以通过添加--output_dir选项来更改路径。

我们提到了Waveglow,Melgan和Tacotron2来实现这一点。