В нашей статье мы предложили Hifi-Gan: модель на основе GAN, способную эффективно генерировать речь высокой верности.

Мы предоставляем наши модели реализации и предварительно подготовленных в качестве открытого исходного кода в этом репозитории.

Аннотация: Несколько недавних работ по синтезу речи использовали генеративные состязательные сети (GANS) для производства необработанных сигналов. Хотя такие методы улучшают эффективность отбора проб и использование памяти, их качество выборки еще не достигло качества авторегрессии и генеративных моделей на основе потока. В этой работе мы предлагаем Hifi-Gan, который достигает как эффективного, так и высокого синтеза речи с высокой точностью. Поскольку речевой звук состоит из синусоидальных сигналов с различными периодами, мы демонстрируем, что моделирование периодических моделей аудио имеет решающее значение для повышения качества выборки. Субъективная человеческая оценка (средняя оценка мнений, MOS) одного набора данных динамика указывает на то, что предлагаемый наш метод демонстрирует сходство с качеством человека, одновременно генерируя 22,05 кГц звук высокого уровня в 167,9 раза быстрее, чем в режиме реального времени на одном графическом процессоре V100. Мы также показываем общность Hifi-Gan для инверсии мель-спектрограммы невидимых ораторов и синтеза речи. Наконец, небольшая версия Hifi-Gan с участием Hifi-Gan генерирует образцы в 13,4 раза быстрее, чем в режиме реального времени на процессоре с сопоставимым качеством с авторегрессивным аналогом.

Посетите наш демонстрационный веб -сайт для образцов аудио.

LJSpeech-1.1/wavs python train.py --config config_v1.json

Чтобы обучить генератор V2 или V3, замените config_v1.json на config_v2.json или config_v3.json .

Контрольные точки и копия файла конфигурации сохраняются в каталоге cp_hifigan по умолчанию.

Вы можете изменить путь, добавив опцию --checkpoint_path .

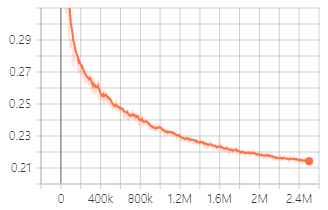

Потеря проверки во время обучения с генератором V1.

Вы также можете использовать предварительные модели, которые мы предоставляем.

Загрузите предварительные модели

Детали каждой папки таковы в следующем:

| Имя папки | Генератор | Набор данных | Тонко настроенный |

|---|---|---|---|

| LJ_V1 | V1 | LJSPEECH | Нет |

| LJ_V2 | V2 | LJSPEECH | Нет |

| LJ_V3 | V3 | LJSPEECH | Нет |

| Lj_ft_t2_v1 | V1 | LJSPEECH | Да (Такотрон2) |

| Lj_ft_t2_v2 | V2 | LJSPEECH | Да (Такотрон2) |

| Lj_ft_t2_v3 | V3 | LJSPEECH | Да (Такотрон2) |

| Vctk_v1 | V1 | VCTK | Нет |

| Vctk_v2 | V2 | VCTK | Нет |

| Vctk_v3 | V3 | VCTK | Нет |

| Universal_V1 | V1 | Универсальный | Нет |

Мы предоставляем универсальную модель с весами дискриминатора, которые можно использовать в качестве базы для переноса обучения на другие наборы данных.

.npy . Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset и скопируйте в нее сгенерированные файлы Mel-Spectrogram. python train.py --fine_tuning True --config config_v1.json

test_files и скопируйте файлы WAV в каталог. python inference.py --checkpoint_file [generator checkpoint file path]

Сгенерированные файлы WAV сохраняются в generated_files по умолчанию.

Вы можете изменить путь, добавив опцию --output_dir .

test_mel_files и скопируйте сгенерированные файлы мель-спектрограммы в каталог. python inference_e2e.py --checkpoint_file [generator checkpoint file path]

Сгенерированные файлы WAV сохраняются в generated_files_from_mel по умолчанию.

Вы можете изменить путь, добавив опцию --output_dir .

Мы сослались на Waveglow, Melgan и Tacotron2, чтобы реализовать это.