Dalam makalah kami, kami mengusulkan HiFi-Gan: model berbasis GAN yang mampu menghasilkan ucapan kesetiaan tinggi secara efisien.

Kami menyediakan implementasi dan model pretrained kami sebagai open source di repositori ini.

Abstrak: Beberapa karya terbaru tentang sintesis bicara telah menggunakan jaringan permusuhan generatif (GANS) untuk menghasilkan bentuk gelombang mentah. Meskipun metode tersebut meningkatkan efisiensi pengambilan sampel dan penggunaan memori, kualitas sampelnya belum mencapai model generatif berbasis autoregresif dan berbasis aliran. Dalam karya ini, kami mengusulkan Hifi-Gan, yang mencapai sintesis ucapan yang efisien dan kesetiaan tinggi. Karena audio bicara terdiri dari sinyal sinusoidal dengan berbagai periode, kami menunjukkan bahwa pemodelan pola periodik audio sangat penting untuk meningkatkan kualitas sampel. Evaluasi manusia subyektif (skor opini rata-rata, MOS) dari dataset pembicara tunggal menunjukkan bahwa metode yang kami usulkan menunjukkan kesamaan dengan kualitas manusia saat menghasilkan audio kesetiaan tinggi 22,05 kHz 167,9 kali lebih cepat daripada real-time pada GPU V100 tunggal. Kami selanjutnya menunjukkan keumuman HiFi-gan ke inversi Mel-spectrogram dari speaker yang tidak terlihat dan sintesis ucapan ujung ke ujung. Akhirnya, versi jejak kaki kecil dari HiFi-Gan menghasilkan sampel 13,4 kali lebih cepat daripada real-time pada CPU dengan kualitas yang sebanding dengan mitra autoregresif.

Kunjungi situs web demo kami untuk sampel audio.

LJSpeech-1.1/wavs python train.py --config config_v1.json

Untuk melatih generator V2 atau V3, ganti config_v1.json dengan config_v2.json atau config_v3.json .

Pos pemeriksaan dan salinan file konfigurasi disimpan dalam direktori cp_hifigan secara default.

Anda dapat mengubah jalur dengan menambahkan --checkpoint_path opsi.

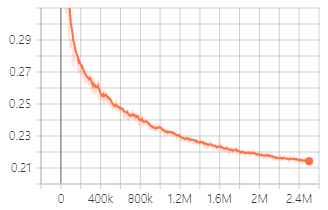

Kehilangan validasi selama pelatihan dengan V1 Generator.

Anda juga dapat menggunakan model pretrained yang kami sediakan.

Unduh model pretrained

Rincian setiap folder adalah seperti berikut:

| Nama folder | Generator | Dataset | Disesuaikan |

|---|---|---|---|

| Lj_v1 | V1 | Ljspeech | TIDAK |

| Lj_v2 | V2 | Ljspeech | TIDAK |

| Lj_v3 | V3 | Ljspeech | TIDAK |

| Lj_ft_t2_v1 | V1 | Ljspeech | Ya (tacotron2) |

| Lj_ft_t2_v2 | V2 | Ljspeech | Ya (tacotron2) |

| Lj_ft_t2_v3 | V3 | Ljspeech | Ya (tacotron2) |

| Vctk_v1 | V1 | Vctk | TIDAK |

| Vctk_v2 | V2 | Vctk | TIDAK |

| Vctk_v3 | V3 | Vctk | TIDAK |

| Universal_v1 | V1 | Universal | TIDAK |

Kami menyediakan model universal dengan bobot diskriminator yang dapat digunakan sebagai basis untuk transfer pembelajaran ke set data lainnya.

.npy . Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset dan salin file Mel-Spectrogram yang dihasilkan ke dalamnya. python train.py --fine_tuning True --config config_v1.json

test_files dan salin file WAV ke dalam direktori. python inference.py --checkpoint_file [generator checkpoint file path]

File WAV yang dihasilkan disimpan di generated_files secara default.

Anda dapat mengubah jalur dengan menambahkan --output_dir opsi.

test_mel_files dan salin file Mel-spectrogram yang dihasilkan ke dalam direktori. python inference_e2e.py --checkpoint_file [generator checkpoint file path]

File WAV yang dihasilkan disimpan di generated_files_from_mel secara default.

Anda dapat mengubah jalur dengan menambahkan --output_dir opsi.

Kami merujuk ke Waveglow, Melgan dan Tacotron2 untuk mengimplementasikan ini.