Dans notre article, nous avons proposé HIFI-GAN: un modèle GAN capable de générer efficacement la parole de haute fidélité.

Nous fournissons nos modèles d'implémentation et de pré-étendue comme open source dans ce référentiel.

Résumé: Plusieurs travaux récents sur la synthèse de la parole ont utilisé des réseaux adversaires génératifs (GAN) pour produire des formes d'onde brutes. Bien que de telles méthodes améliorent l'efficacité d'échantillonnage et l'utilisation de la mémoire, leur qualité d'échantillon n'a pas encore atteint celle des modèles génératifs autorégressifs et basés sur le débit. Dans ce travail, nous proposons Hifi-Gan, qui atteint une synthèse de la parole à la fois efficace et haute fidélité. Étant donné que l'audio de la parole se compose de signaux sinusoïdaux avec diverses périodes, nous démontrons que la modélisation des modèles périodiques d'un audio est cruciale pour améliorer la qualité de l'échantillon. Une évaluation humaine subjective (score d'opinion moyen, MOS) d'un seul ensemble de données de haut-parleur indique que notre méthode proposée démontre une similitude avec la qualité humaine tout en générant 22,05 kHz audio haute fidélité 167,9 fois plus rapide que en temps réel sur un seul GPU V100. Nous montrons en outre la généralité de HIFI-GAN à l'inversion de Spectrogramme Mel des haut-parleurs invisibles et de la synthèse de la parole de bout en bout. Enfin, une petite version d'empreinte de HIFI-AG génère des échantillons 13,4 fois plus rapides que en temps réel sur CPU avec une qualité comparable à un homologue autorégressif.

Visitez notre site Web de démonstration pour des échantillons audio.

LJSpeech-1.1/wavs python train.py --config config_v1.json

Pour former le générateur V2 ou V3, remplacez config_v1.json par config_v2.json ou config_v3.json .

Les points de contrôle et la copie du fichier de configuration sont enregistrés dans le répertoire cp_hifigan par défaut.

Vous pouvez modifier le chemin en ajoutant l'option --checkpoint_path .

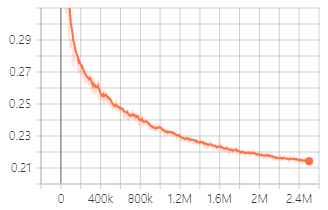

Perte de validation pendant la formation avec le générateur V1.

Vous pouvez également utiliser des modèles pré-entraînés que nous fournissons.

Télécharger les modèles pré-entraînés

Les détails de chaque dossier sont comme suit:

| Nom du dossier | Générateur | Ensemble de données | Affronté |

|---|---|---|---|

| Lj_v1 | V1 | Ljspeech | Non |

| Lj_v2 | V2 | Ljspeech | Non |

| Lj_v3 | V3 | Ljspeech | Non |

| Lj_ft_t2_v1 | V1 | Ljspeech | Oui (tacotron2) |

| Lj_ft_t2_v2 | V2 | Ljspeech | Oui (tacotron2) |

| Lj_ft_t2_v3 | V3 | Ljspeech | Oui (tacotron2) |

| Vctk_v1 | V1 | Vctk | Non |

| Vctk_v2 | V2 | Vctk | Non |

| Vctk_v3 | V3 | Vctk | Non |

| Universal_v1 | V1 | Universel | Non |

Nous fournissons au modèle universel des poids discriminants qui peuvent être utilisés comme base pour l'apprentissage du transfert vers d'autres ensembles de données.

.npy . Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset et copiez les fichiers MEL générés dedans. python train.py --fine_tuning True --config config_v1.json

test_files et copiez les fichiers WAV dans le répertoire. python inference.py --checkpoint_file [generator checkpoint file path]

Les fichiers WAV générés sont enregistrés dans generated_files par défaut.

Vous pouvez modifier le chemin en ajoutant l'option --output_dir .

test_mel_files et copiez des fichiers de spectrogramme MEL dans le répertoire. python inference_e2e.py --checkpoint_file [generator checkpoint file path]

Les fichiers WAV générés sont enregistrés dans generated_files_from_mel par défaut.

Vous pouvez modifier le chemin en ajoutant l'option --output_dir .

Nous avons fait référence à Wave Glow, Melgan et Tacotron2 pour implémenter cela.