في ورقتنا ، اقترحنا HIFI-GAN: نموذج قائم على GAN قادر على توليد خطاب عالي الإخلاص بكفاءة.

نحن نقدم تنفيذنا ونماذج ما قبل المصدر مفتوح المصدر في هذا المستودع.

الخلاصة: استخدمت العديد من الأعمال الحديثة في تخليق الكلام شبكات عدوانية (GANS) لإنتاج أشكال موجية خام. على الرغم من أن مثل هذه الطرق تعمل على تحسين كفاءة أخذ العينات واستخدام الذاكرة ، إلا أن جودة عينةها لم تصل بعد إلى تلك النماذج التوليدية القائمة على التدفق الذاتي. في هذا العمل ، نقترح HIFI-GAN ، الذي يحقق كل من توليف الكلام الفعال والعالي الدقة. نظرًا لأن صوت الكلام يتكون من إشارات الجيوب الأنفية مع فترات مختلفة ، فإننا نوضح أن نمذجة الأنماط الدورية للصوت أمر بالغ الأهمية لتعزيز جودة العينة. يشير التقييم البشري الذاتي (متوسط درجة الرأي ، MOS) لمجموعة بيانات مكبر الصوت واحدة إلى أن طريقتنا المقترحة توضح التشابه مع الجودة البشرية مع توليد 22.05 كيلو هرتز الصوت عالي الدقة 167.9 مرة أسرع من الوقت الفعلي على وحدة معالجة الرسومات V100 واحدة. نوضح أيضًا عمومية HIFI-GAN إلى انعكاس طيف الطيف للمكبرات غير المرئية وتوليف الكلام من شامل إلى طرف. أخيرًا ، تقوم نسخة صغيرة من البصمة من HIFI بإنشاء عينات أسرع 13.4 مرة من الوقت الفعلي على وحدة المعالجة المركزية مع جودة مماثلة لنظير الانحدار التلقائي.

تفضل بزيارة موقعنا التجريبي لعينات الصوت.

LJSpeech-1.1/wavs python train.py --config config_v1.json

لتدريب مولد V2 أو V3 ، استبدل config_v1.json باستخدام config_v2.json أو config_v3.json .

يتم حفظ نقاط التفتيش ونسخ ملف التكوين في دليل cp_hifigan افتراضيًا.

يمكنك تغيير المسار عن طريق إضافة -خيار --checkpoint_path .

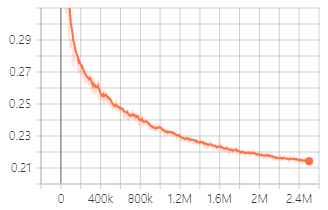

خسارة التحقق من الصحة أثناء التدريب مع مولد V1.

يمكنك أيضًا استخدام النماذج المسبقة التي نقدمها.

تنزيل النماذج المسبق

تفاصيل كل مجلد كما في التالي:

| اسم المجلد | مولد | مجموعة البيانات | ضبطها |

|---|---|---|---|

| LJ_V1 | V1 | ljspeech | لا |

| LJ_V2 | V2 | ljspeech | لا |

| LJ_V3 | V3 | ljspeech | لا |

| LJ_FT_T2_V1 | V1 | ljspeech | نعم (Tacotron2) |

| lj_ft_t2_v2 | V2 | ljspeech | نعم (Tacotron2) |

| lj_ft_t2_v3 | V3 | ljspeech | نعم (Tacotron2) |

| VCTK_V1 | V1 | VCTK | لا |

| VCTK_V2 | V2 | VCTK | لا |

| VCTK_V3 | V3 | VCTK | لا |

| Universal_V1 | V1 | عالمي | لا |

نحن نوفر النموذج العالمي مع أوزان تمييز يمكن استخدامها كقاعدة لتحويل التعلم إلى مجموعات البيانات الأخرى.

.npy . Audio File : LJ001-0001.wav

Mel-Spectrogram File : LJ001-0001.npy

ft_dataset ونسخ ملفات طيف MEL-SPERCORGR التي تم إنشاؤها فيه. python train.py --fine_tuning True --config config_v1.json

test_files ونسخ ملفات WAV إلى الدليل. python inference.py --checkpoint_file [generator checkpoint file path]

يتم حفظ ملفات WAV التي تم إنشاؤها في generated_files بشكل افتراضي.

يمكنك تغيير المسار عن طريق إضافة --output_dir خيار.

test_mel_files ونسخ ملفات طيف Mel-spectrogram التي تم إنشاؤها في الدليل. python inference_e2e.py --checkpoint_file [generator checkpoint file path]

يتم حفظ ملفات WAV التي تم إنشاؤها في generated_files_from_mel بشكل افتراضي.

يمكنك تغيير المسار عن طريق إضافة --output_dir خيار.

أشرنا إلى WaveGlow و Melgan و Tacotron2 لتنفيذ هذا.