Neighborhood Attention Transformer

1.0.0

強大的層次視覺變壓器基於滑動窗口的關注。

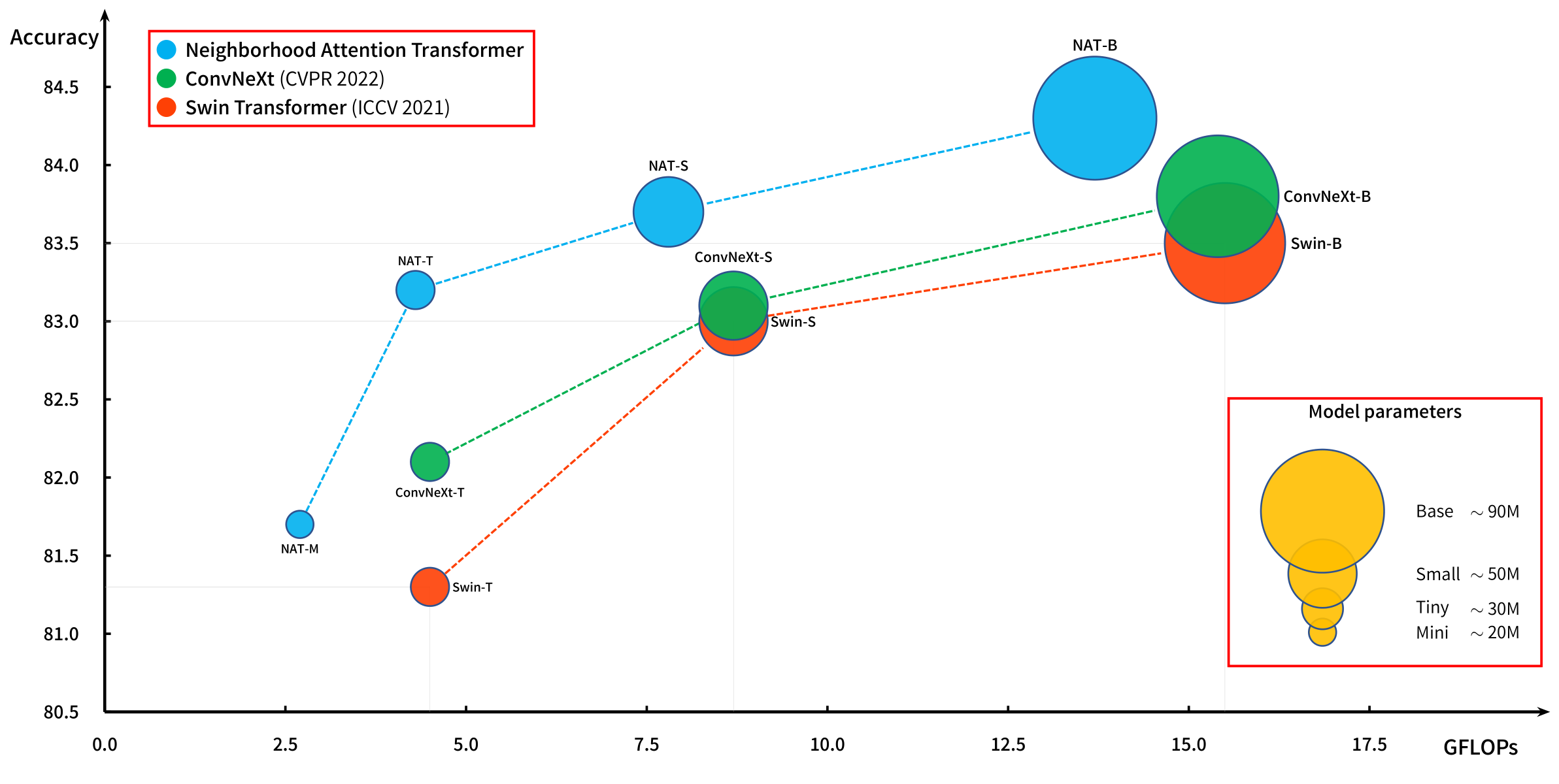

我們的原始論文NAT引入了鄰里注意力(NA,本地關注),並隨著向Natten Pytorch的擴展而有效地運行。

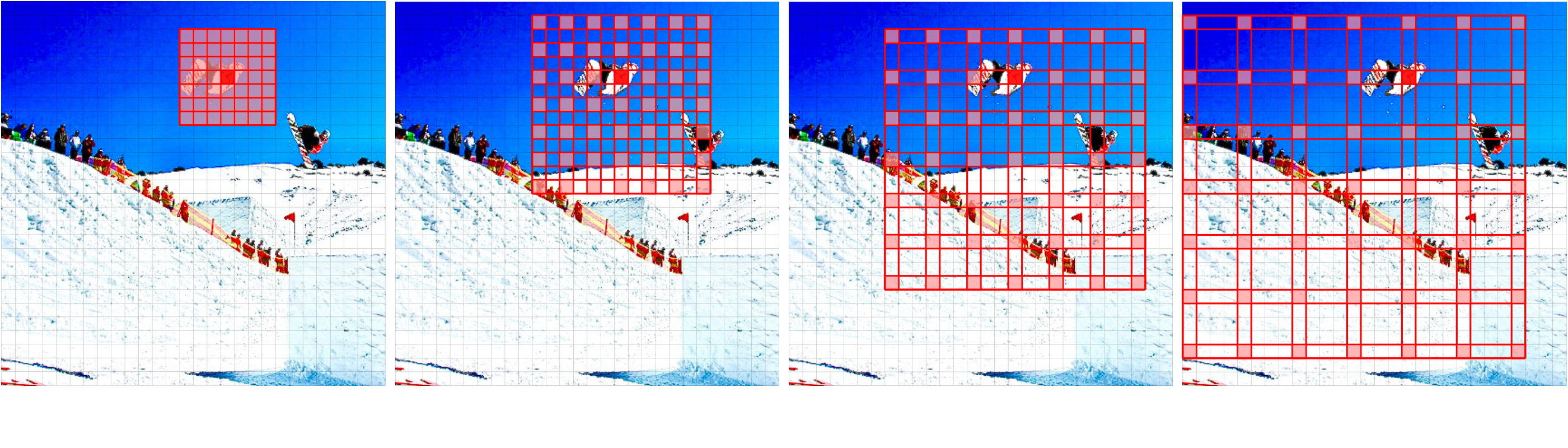

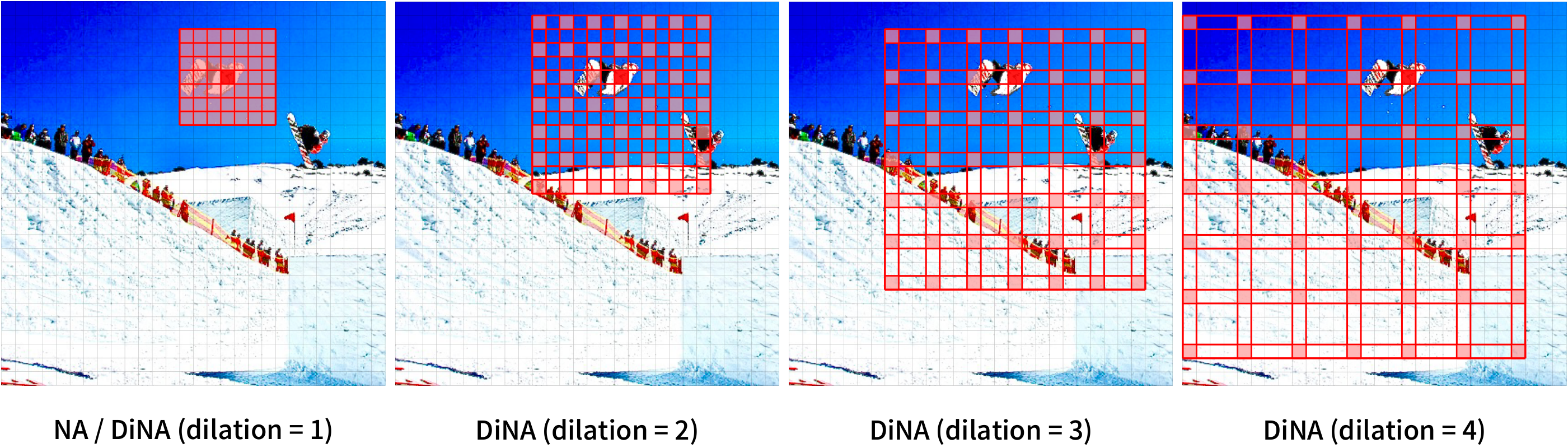

我們最近引入了一種新的模型Dinat,該模型通過擴張社區(Dina,稀疏的全球關注,又稱本地關注)來擴展NA。

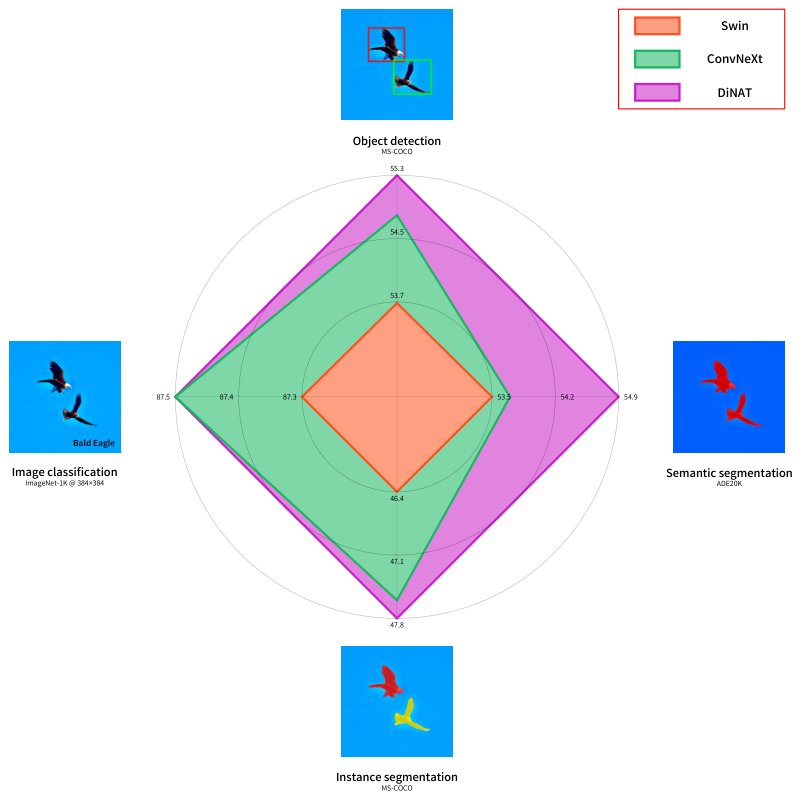

NA/DINA的組合能夠保留位置,維持翻譯模棱兩可,呈指數式擴展並捕獲長期相互依賴性,從而在下游視覺任務中顯著提高性能,例如用於圖像生成的Stylenat。

基於鄰里注意力(當地註意力)和擴張鄰里注意力(稀疏全球關注)的新的分層視覺變壓器,在下游任務中具有顯著的性能增強。

查看Dinat Readme。

我們的原始論文《鄰里注意力變壓器》(NAT),這是第一個有效的滑動窗口當地關注。

鄰里的注意力將查詢令牌的(紅色)接收場定位在鑰匙值對(綠色)中最近的附近令牌。當鄰域大小與圖像尺寸相同時,這等同於點產生的自我注意力。請注意,邊緣是特殊的(邊緣)情況。

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}