Neighborhood Attention Transformer

1.0.0

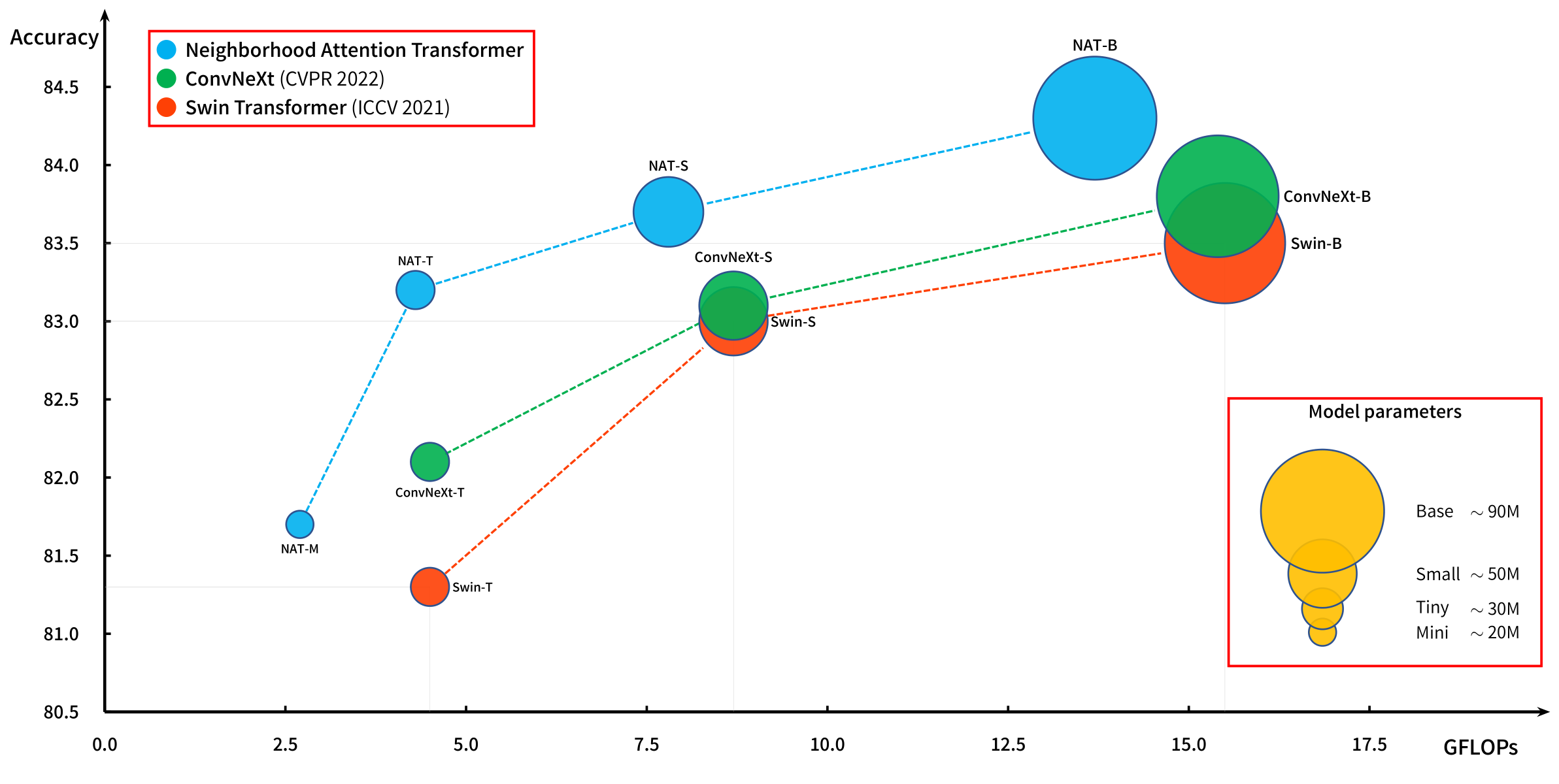

슬라이딩 윈도우주의를 기반으로 한 강력한 계층 적 비전 변압기.

이웃의 관심 (NA, 지역주의)은 원래 논문 인 Nat에 소개되었으며 Natten의 Pytorch 로의 확장으로 효율적으로 운영됩니다.

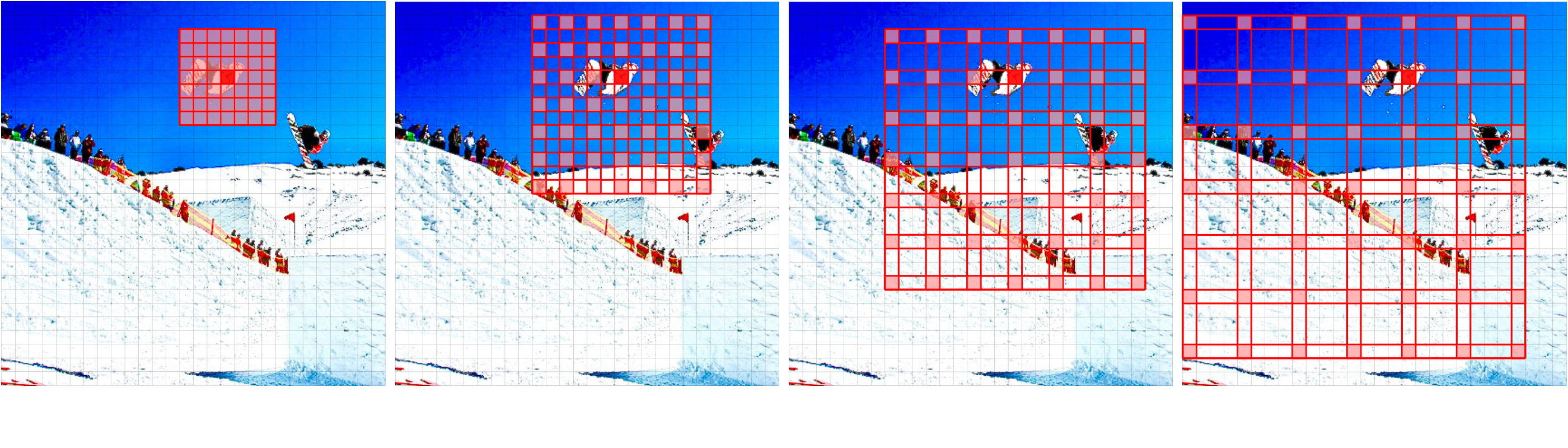

우리는 최근에 새로운 모델 인 Dinat를 소개했습니다. Dinat는 이웃을 확장하여 NA를 확장했습니다 (Dina, Sparse Global Interection, 일명 지역주의가 확정되었습니다).

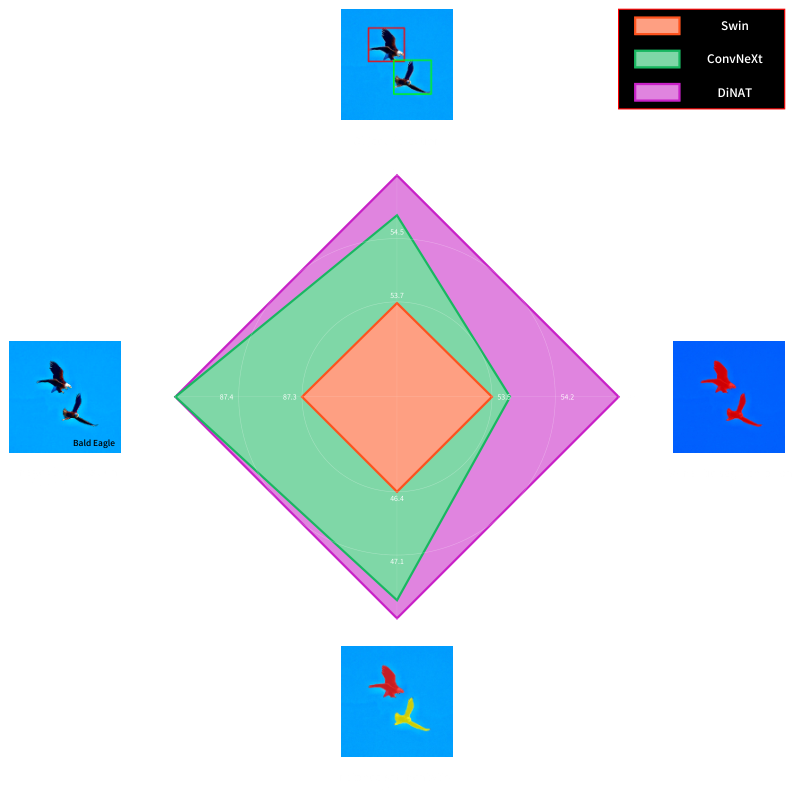

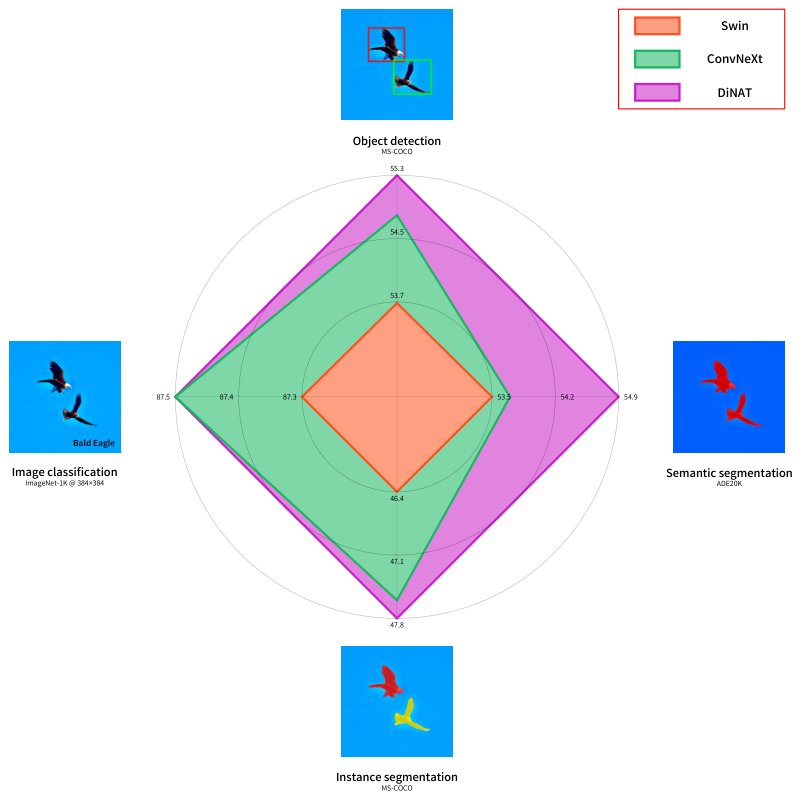

NA/DINA의 조합은 지역을 보존하고, 번역 등가를 유지하고, 수용 필드를 기하 급수적으로 확장하고, 장거리 상호 의존성을 캡처하여 이미지 생성을위한 Stylenat와 같은 다운 스트림 비전 작업에서 상당한 성능 향상을 초래할 수 있습니다.

다운 스트림 작업에서 상당한 성능 향상을 즐기는 인근의 관심 (지역주의) 및 확장 된 이웃주의 관심 (희소 한 글로벌 관심)을 기반으로 한 새로운 계층 적 비전 변압기.

Dinat Readme를 확인하십시오.

우리의 원래 논문, Nat (Neighborhood Interection Transformer), 최초의 효율적인 슬라이딩 윈도우 로컬 관심.

이웃의 관심은 쿼리 토큰 (빨간색) 수용 필드를 키 값 쌍 (녹색)의 가장 가까운 이웃 토큰에 국한합니다. 이웃 크기가 이미지 크기와 동일 할 때 점-제품 자체주의와 동일합니다. 가장자리는 특별한 (가장자리) 케이스입니다.

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}