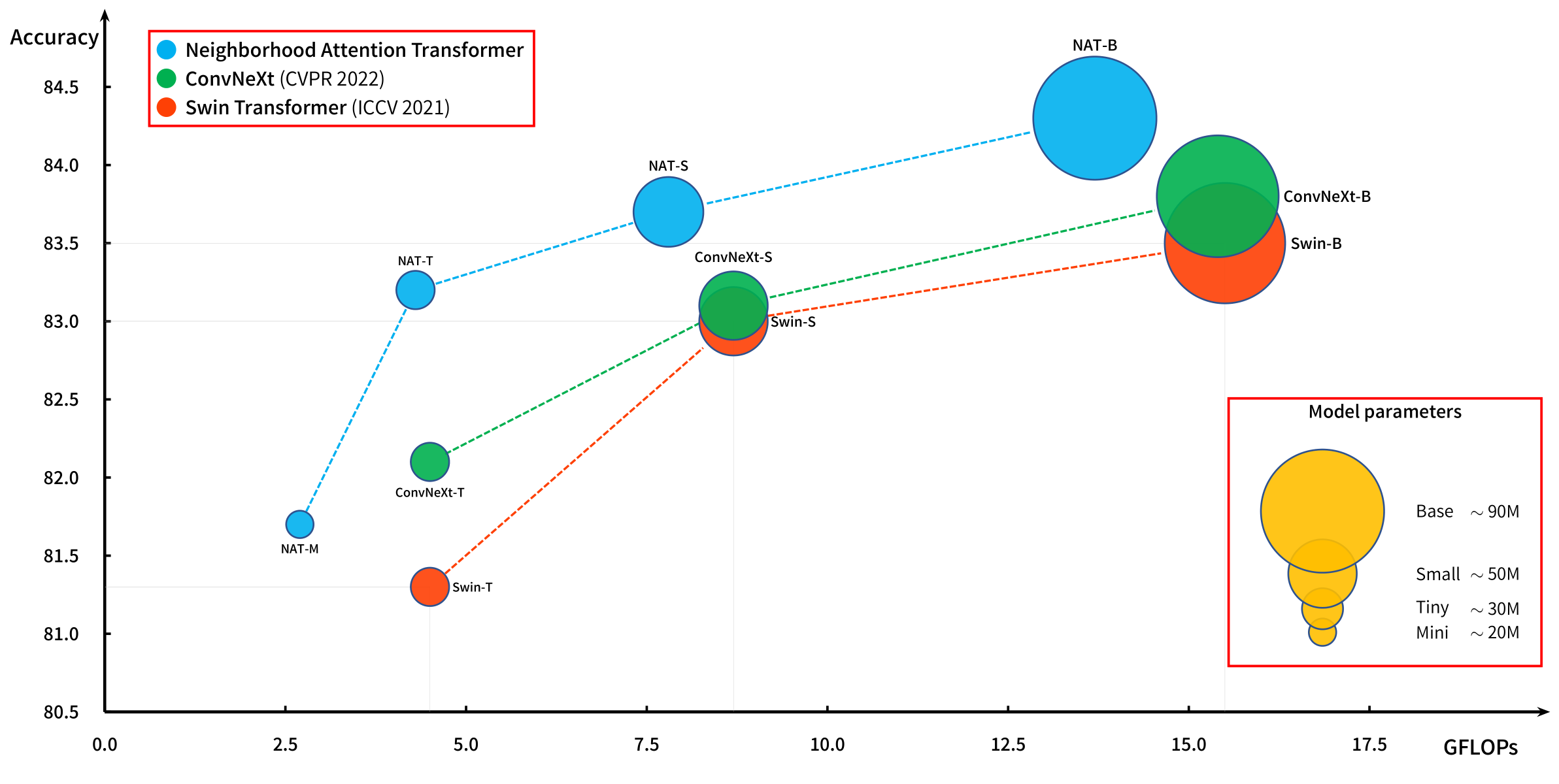

Neighborhood Attention Transformer

1.0.0

スライドウィンドウの注意に基づいた強力な階層ビジョントランス。

近隣の注意(NA、地元の注意)が元の論文であるNATに導入され、ナッテンのピトルチへの延長とともに効率的に実行されました。

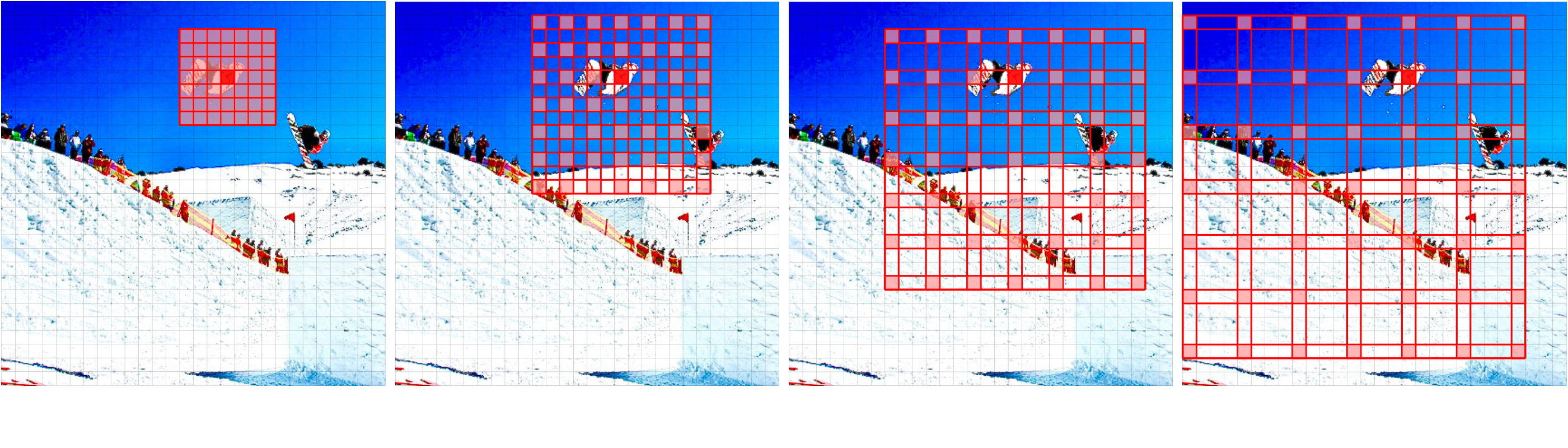

私たちは最近、近隣の拡張によってNAを拡張する新しいモデルであるDinatを導入しました(Dina、まばらな世界的な注意、別名局所的な注意)。

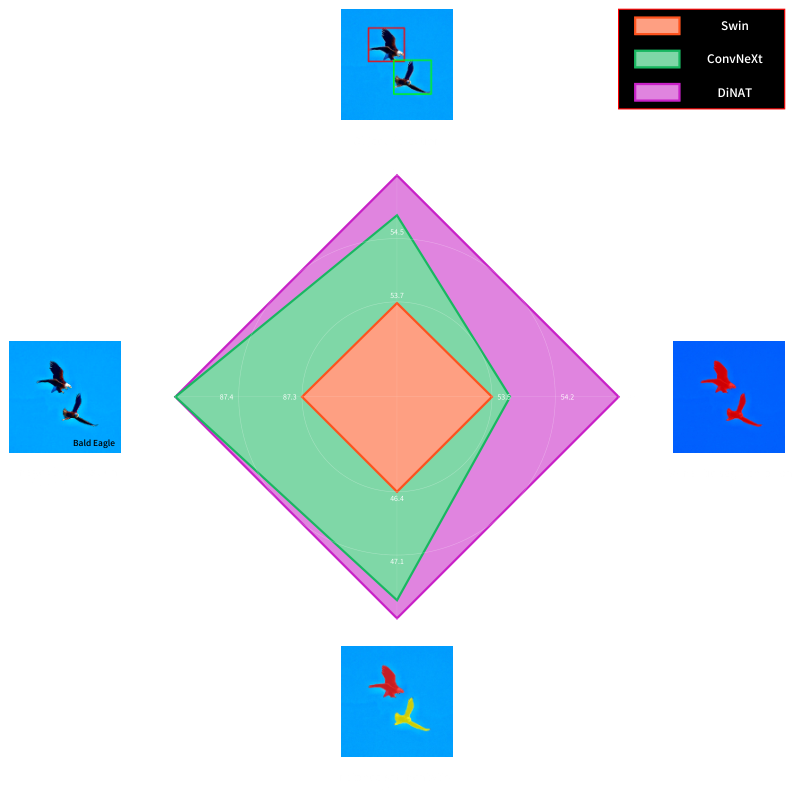

Na/DINAの組み合わせは、地域を維持し、翻訳の等語性を維持し、受容フィールドを指数関数的に拡大し、長距離間依存性をキャプチャすることができ、画像生成のStylenatなどの下流の視力タスクの大幅なパフォーマンス向上をもたらします。

近隣の注意(局所的な注意)と拡張された近隣の注意(まばらな世界的な注意)に基づいた新しい階層ビジョン変圧器が、下流のタスクで大きなパフォーマンスが向上します。

Dinat Readmeをご覧ください。

最初の効率的なスライディングウィンドウのローカルな注意である、私たちのオリジナルの紙、近隣注意変圧器(NAT)。

近隣の注意は、キー価値ペア(緑)の最近隣接するトークンにクエリトークン(赤)受容フィールドをローカライズします。これは、近隣サイズが画像の寸法と同一である場合、DOT製品の自己注意と同等です。エッジは特別な(エッジ)ケースであることに注意してください。

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}