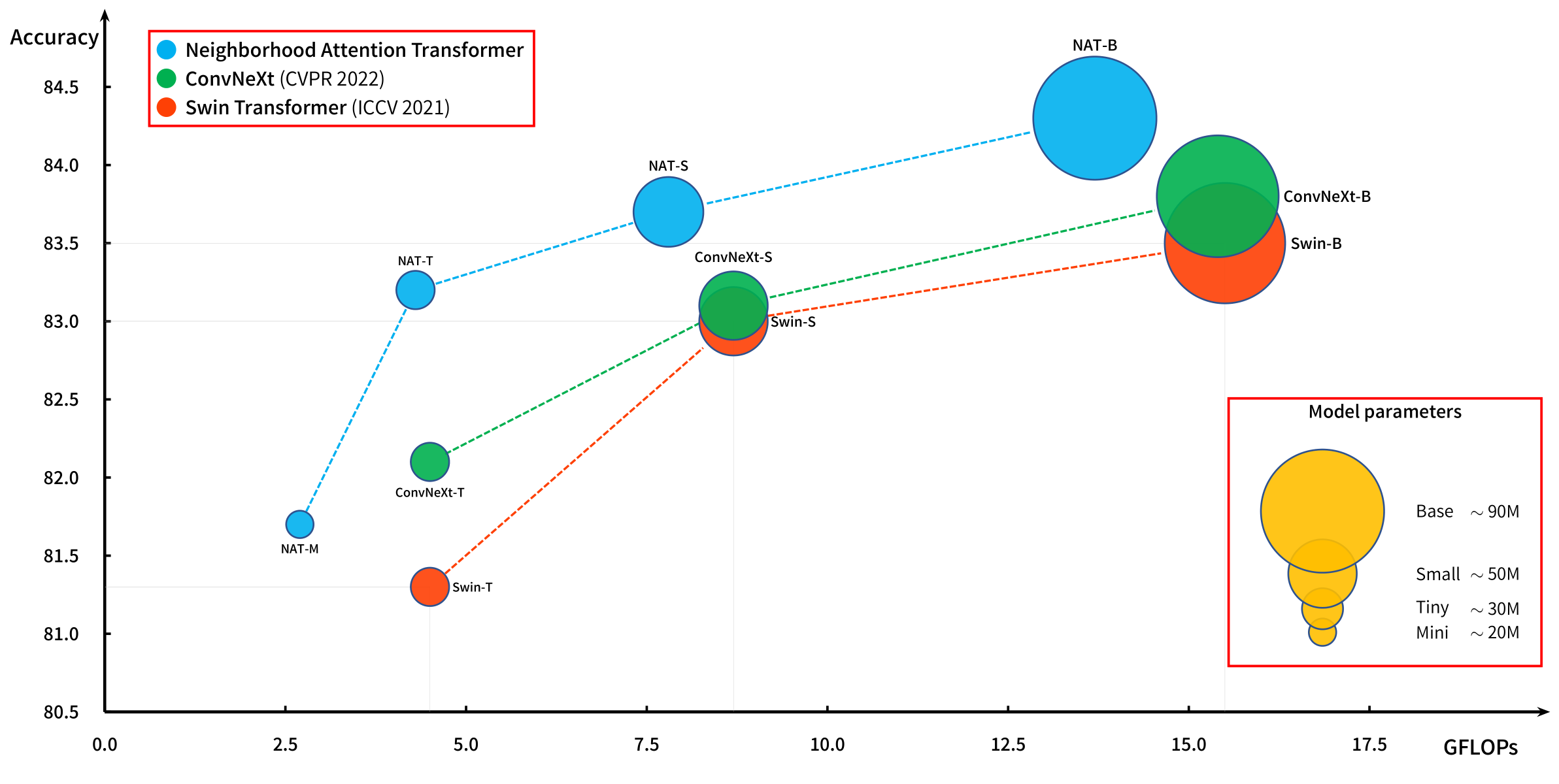

محولات الرؤية الهرمية القوية على أساس انزلاق النافذة.

تم إدخال اهتمام الحي (NA ، الاهتمام المحلي) في ورقتنا الأصلية ، NAT ، ويعمل بكفاءة مع امتدادنا إلى Pytorch ، ناتن.

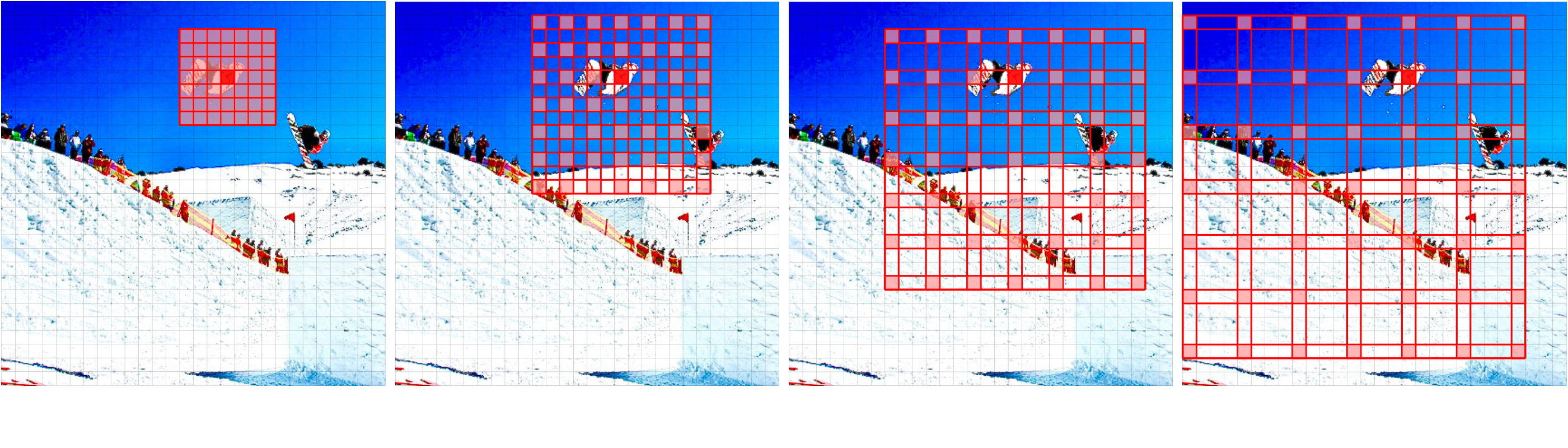

قدمنا مؤخرًا نموذجًا جديدًا ، Dinat ، الذي يمتد NA عن طريق تمديد الأحياء (Dina ، الاهتمام العالمي المتفرق ، ويعرف أيضًا باسم الاهتمام المحلي المتوسع).

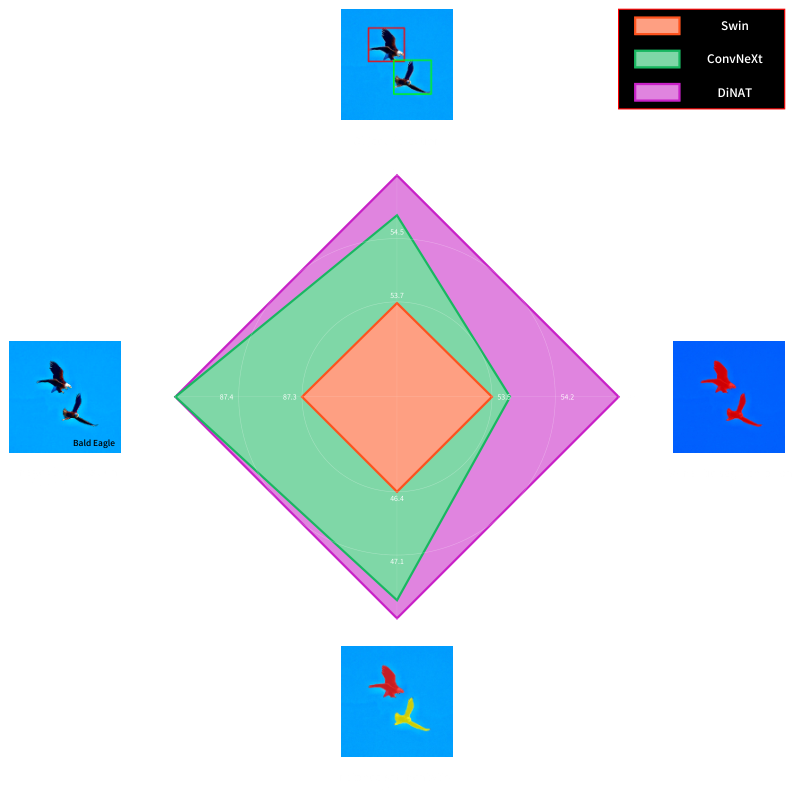

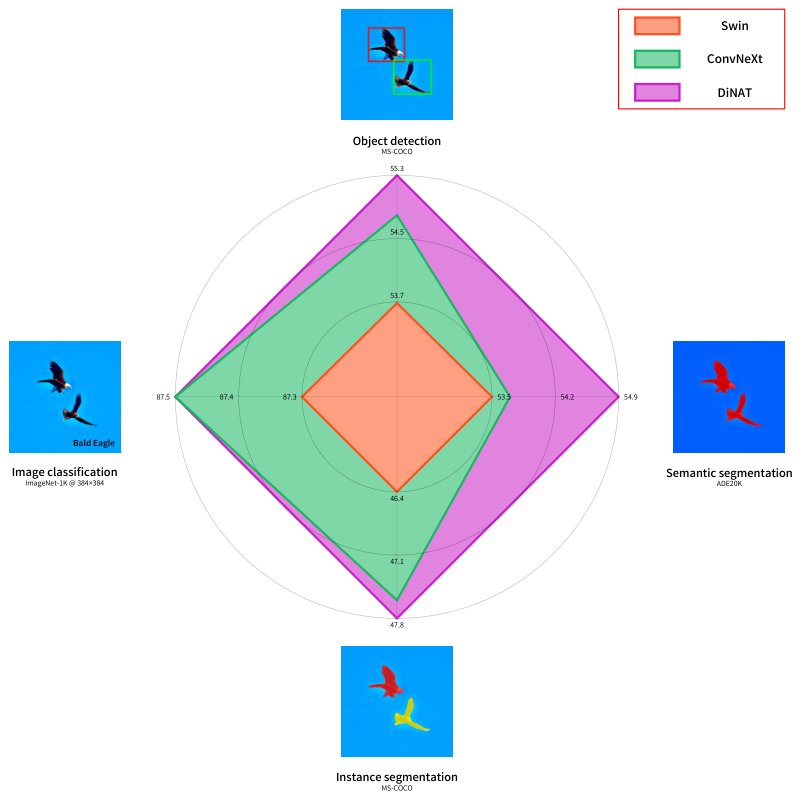

مجموعات من NA/DINA قادرة على الحفاظ على الموقع المحلي ، والحفاظ على ما يعادله في مجال الترجمة ، وتوسيع مجال الاستقبال بشكل كبير ، والتقاط عمليات تعتمد على المدى طويل المدى ، مما يؤدي إلى تعزيزات كبيرة في الأداء في مهام الرؤية المصب ، مثل الأسلوب لتوليد الصور.

محول رؤية هرمي جديد يعتمد على انتباه الحي (الاهتمام المحلي) واهتمام الحي المتوسع (الانتباه العالمي المتفوق) الذي يتمتع بموجب أداء كبير في مهام المصب.

تحقق من dinat readme.

ورقيتنا الأصلية ، محول انتباه الحي (NAT) ، أول اهتمام محلي فعال للانزلاق.

يترجم انتباه الحي حقل استقبال الرمز المميز (الأحمر) إلى أقرب الرموز المجاورة له في زوج القيمة الرئيسية (الأخضر). هذا يعادل انتباه النتيجة الناتجة عن النتيجة عندما يكون حجم الحي متطابقًا مع أبعاد الصورة. لاحظ أن الحواف هي حالات خاصة (حافة).

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}