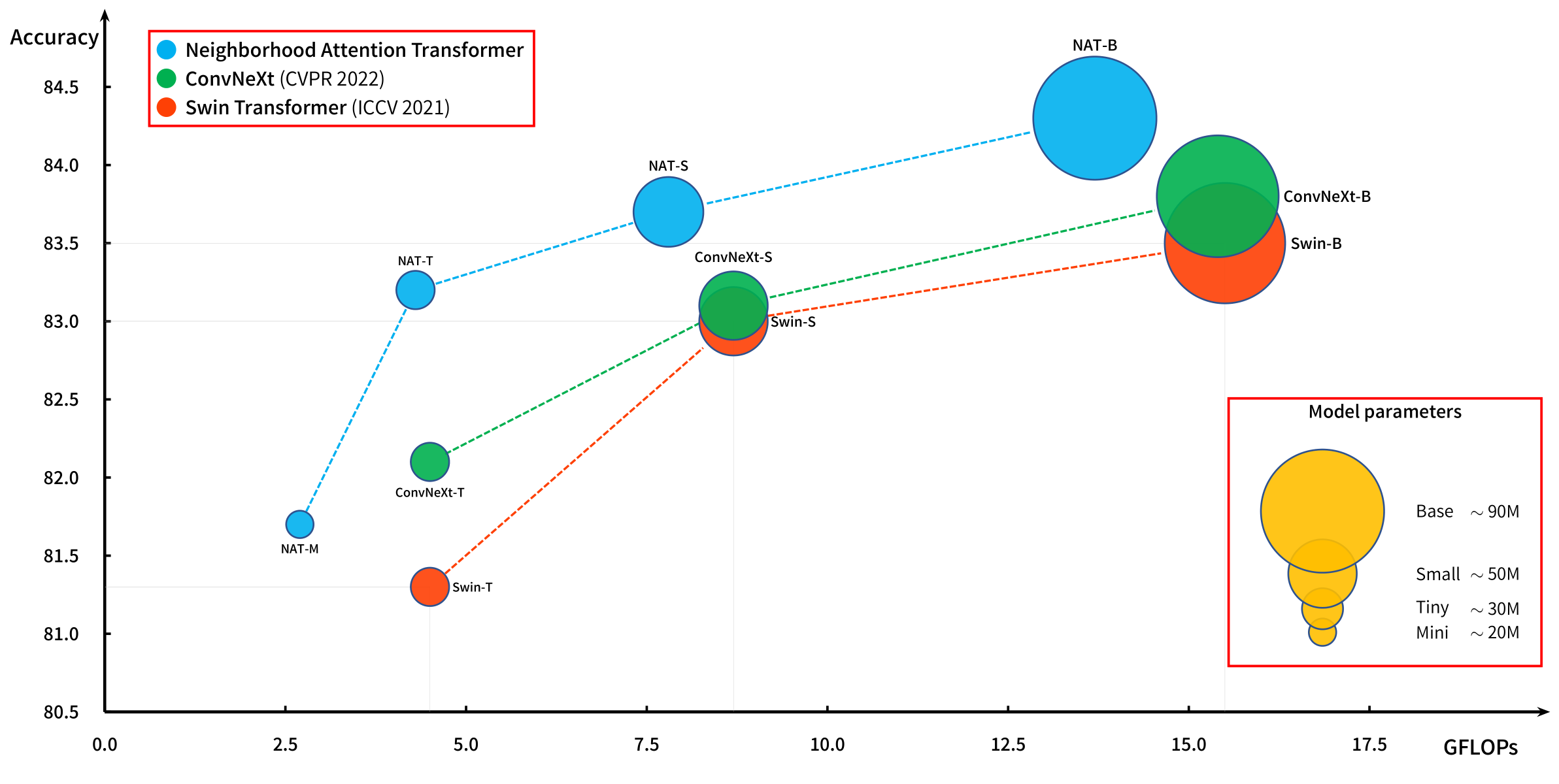

Poderosos transformadores de visión jerárquica basados en la atención de la ventana deslizante.

La atención del vecindario (NA, atención local) se introdujo en nuestro artículo original, NAT, y se ejecuta de manera eficiente con nuestra extensión a Pytorch, Natten.

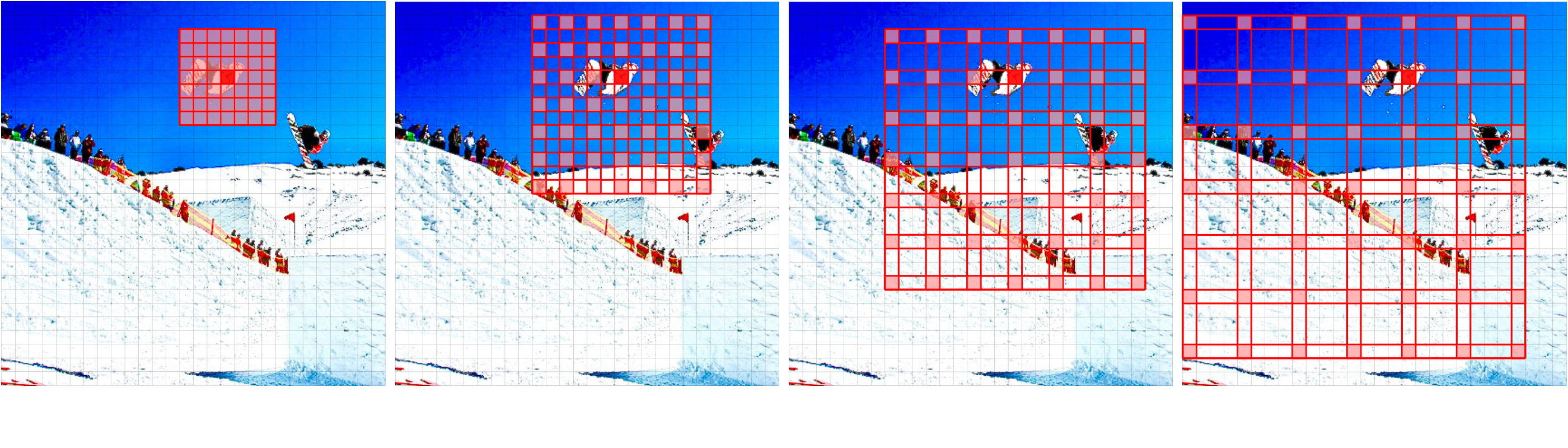

Recientemente presentamos un nuevo modelo, Dinat, que extiende NA mediante la dilatación de los vecindarios (Dina, escasa atención global, también conocido como atención local dilatada).

Las combinaciones de Na/Dina son capaces de preservar la localidad, mantener la equivariancia traslacional, expandir el campo receptivo exponencialmente y capturar las interdependencias de mayor alcance, lo que lleva a aumentos significativos de rendimiento en las tareas de visión posterior, como Stylenat para la generación de imágenes.

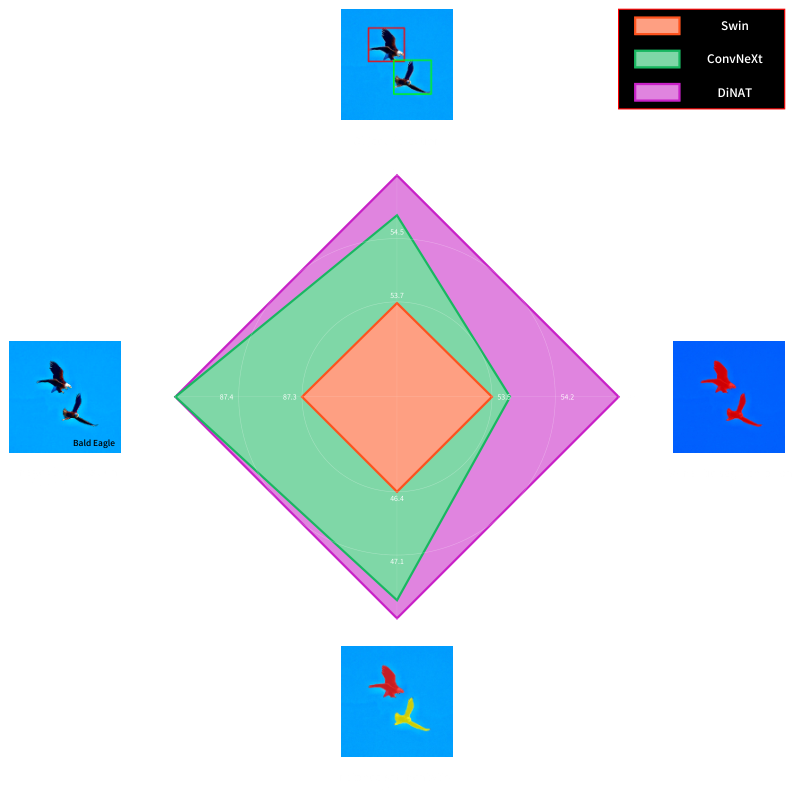

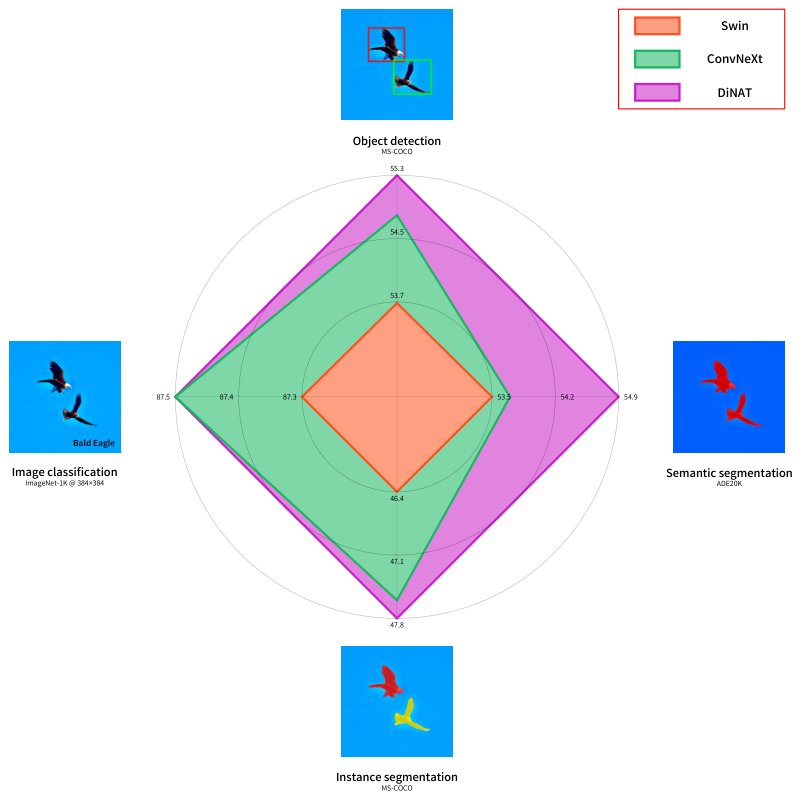

Un nuevo transformador de visión jerárquica basado en la atención del vecindario (atención local) y la atención dilatada del vecindario (atención global escasa) que disfruta de un aumento significativo del rendimiento en las tareas aguas abajo.

Echa un vistazo a Dinat Readme.

Nuestro artículo original, Transformer de atención del vecindario (NAT), la primera atención local de ventana deslizante eficiente.

La atención del vecindario localiza el campo receptivo de token (rojo) de la consulta en sus tokens vecinos más cercanos en el par de valores clave (verde). Esto es equivalente a la atención propia del producto DOT cuando el tamaño del vecindario es idéntico a las dimensiones de la imagen. Tenga en cuenta que los bordes son casos especiales (borde).

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}