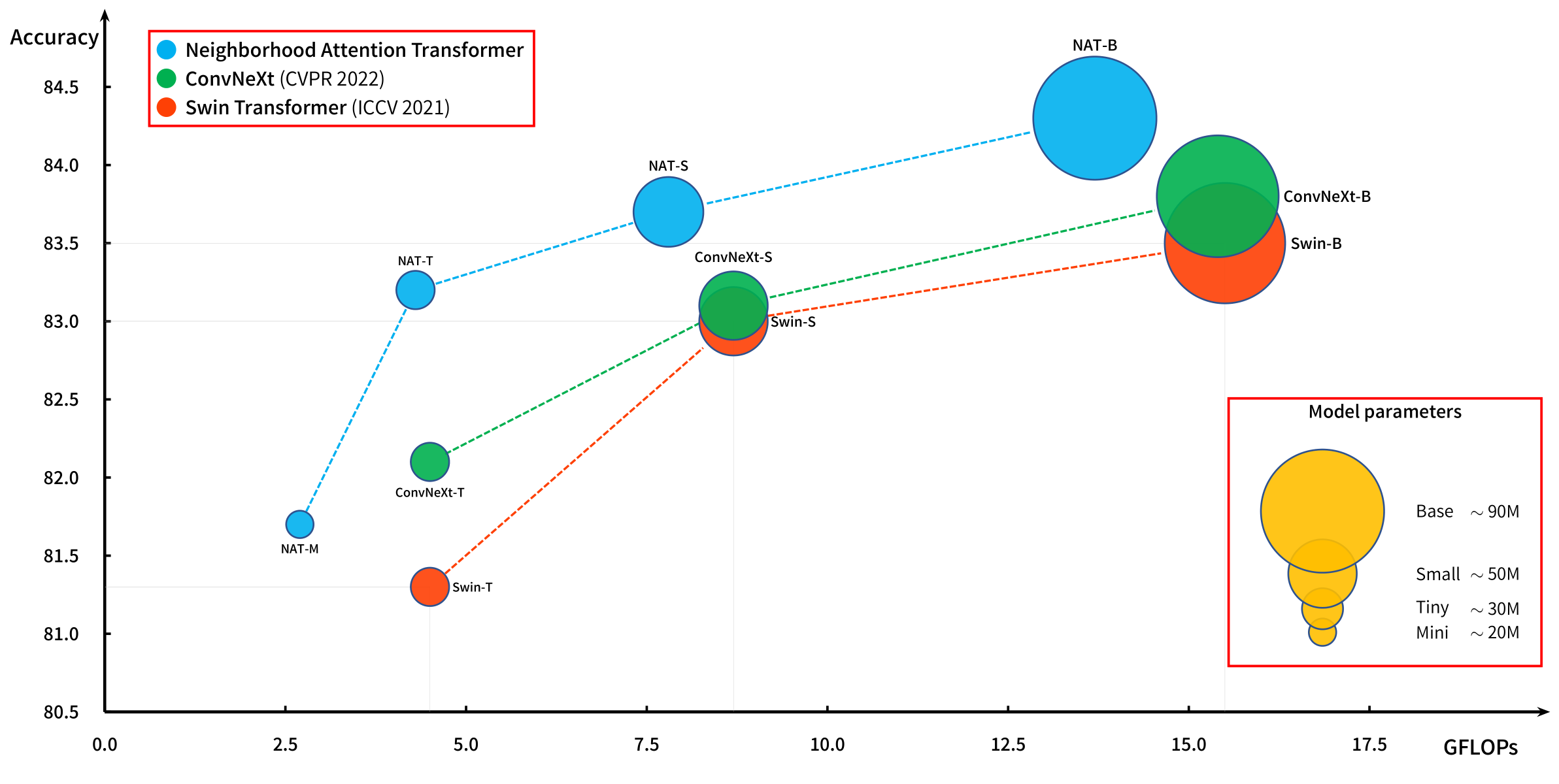

Des transformateurs de vision hiérarchiques puissants basés sur l'attention coulissante des fenêtres.

L'attention du quartier (NA, attention locale) a été introduite dans notre article d'origine, NAT, et fonctionne efficacement avec notre extension à Pytorch, Natten.

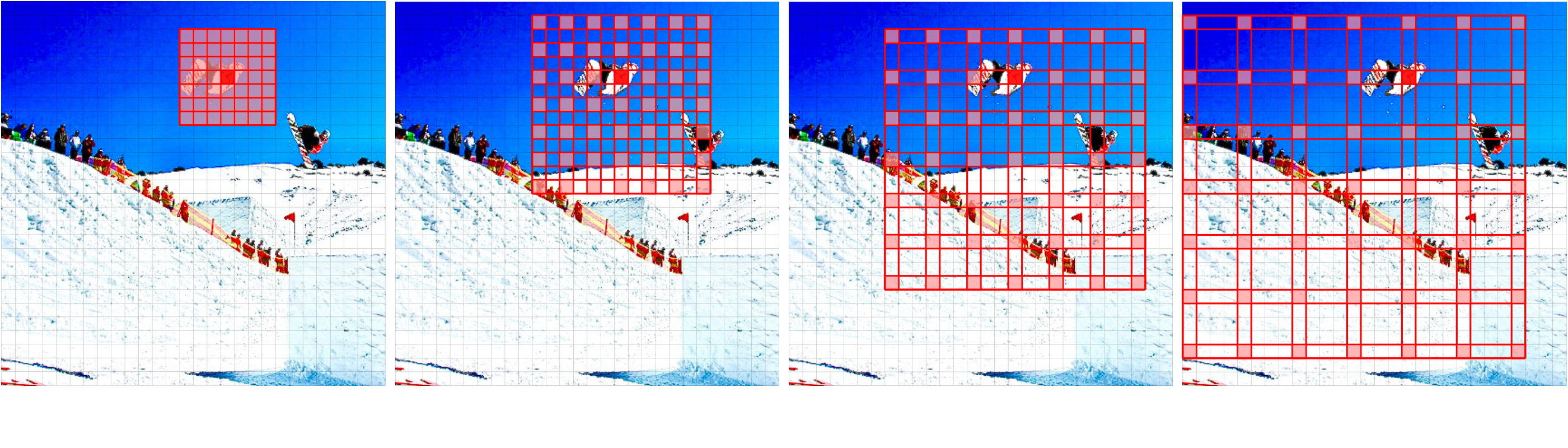

Nous avons récemment introduit un nouveau modèle, Dinat, qui étend NA par les quartiers dilatants (Dina, clairsemé l'attention mondiale, alias l'attention locale dilatée).

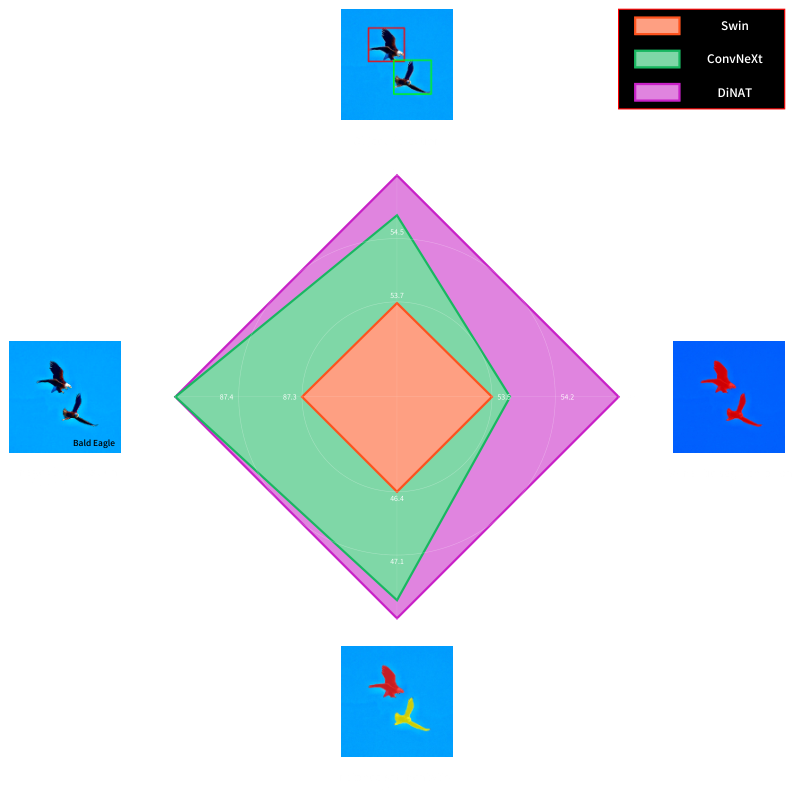

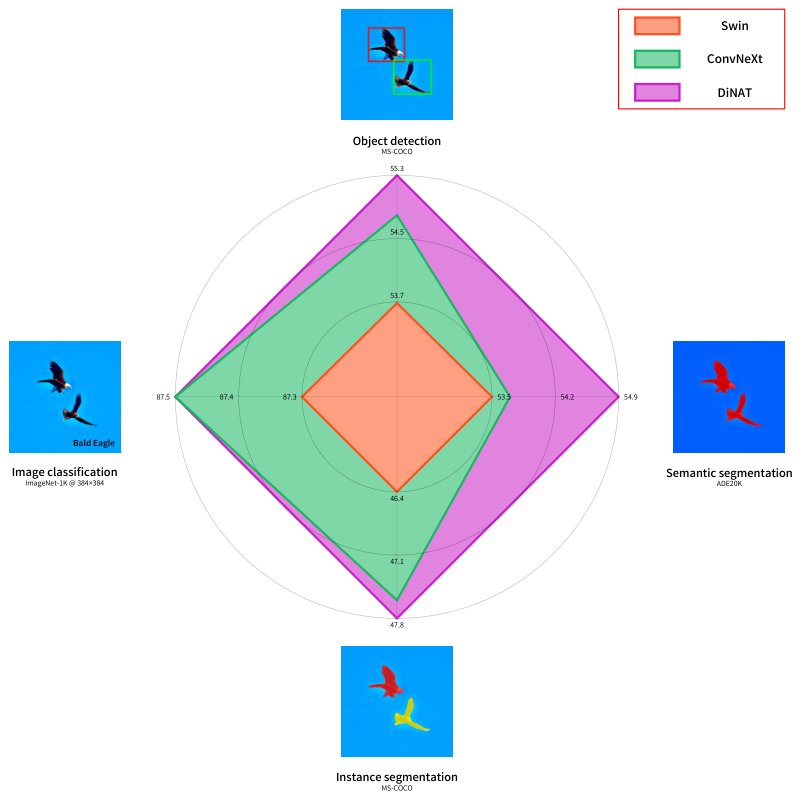

Les combinaisons de Na / Dina sont capables de préserver la localité, de maintenir l'équivariance translationnelle, d'élargir le champ réceptif de façon exponentielle et de capturer des interdépendances à plus longue portée, conduisant à des augmentations de performances significatives dans les tâches de vision en aval, telles que Stylenat pour la génération d'images.

Un nouveau transformateur de vision hiérarchique basé sur l'attention du quartier (attention locale) et l'attention du quartier dilatée (attention clairsemée mondiale) qui bénéficie d'une augmentation significative des performances des tâches en aval.

Découvrez le Dinat Readme.

Notre article d'origine, Transformateur d'attention du quartier (NAT), la première attention locale efficace de la fenêtre coulissante.

L'attention du quartier localise le champ réceptif du jeton de requête (rouge) à ses jetons voisins les plus proches dans la paire de valeurs clés (vert). Cela équivaut à l'attention de soi du produit de points lorsque la taille du quartier est identique aux dimensions de l'image. Notez que les bords sont des cas spéciaux (bord).

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}