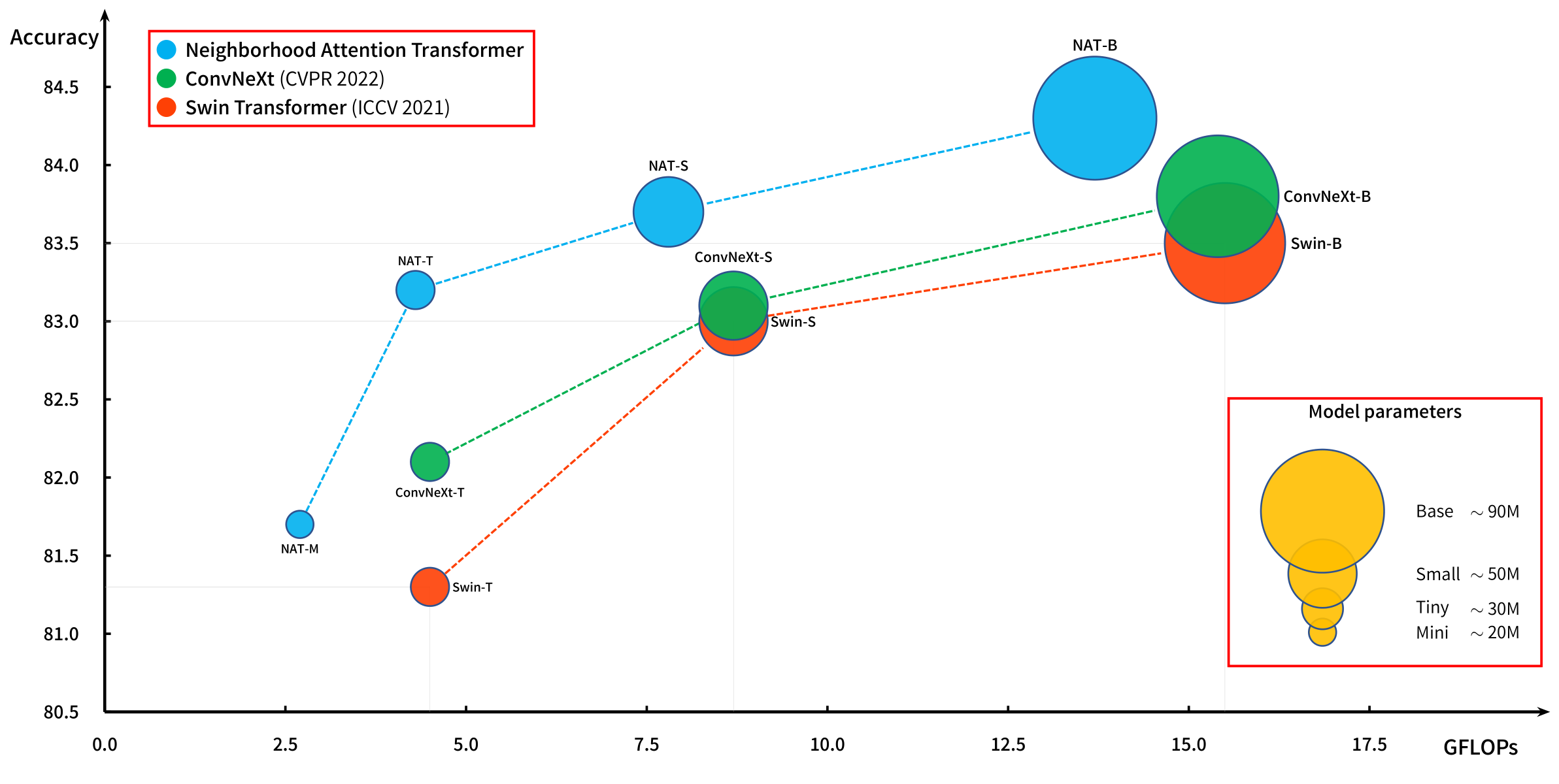

Kraftvolle hierarchische Vision -Transformatoren basierend auf der Aufmerksamkeit des Schiebens.

Die Aufmerksamkeit der Nachbarschaft (NA, lokale Aufmerksamkeit) wurde in unserem ursprünglichen Papier NAT eingeführt und wird mit unserer Erweiterung von Pytorch, Natten, effizient.

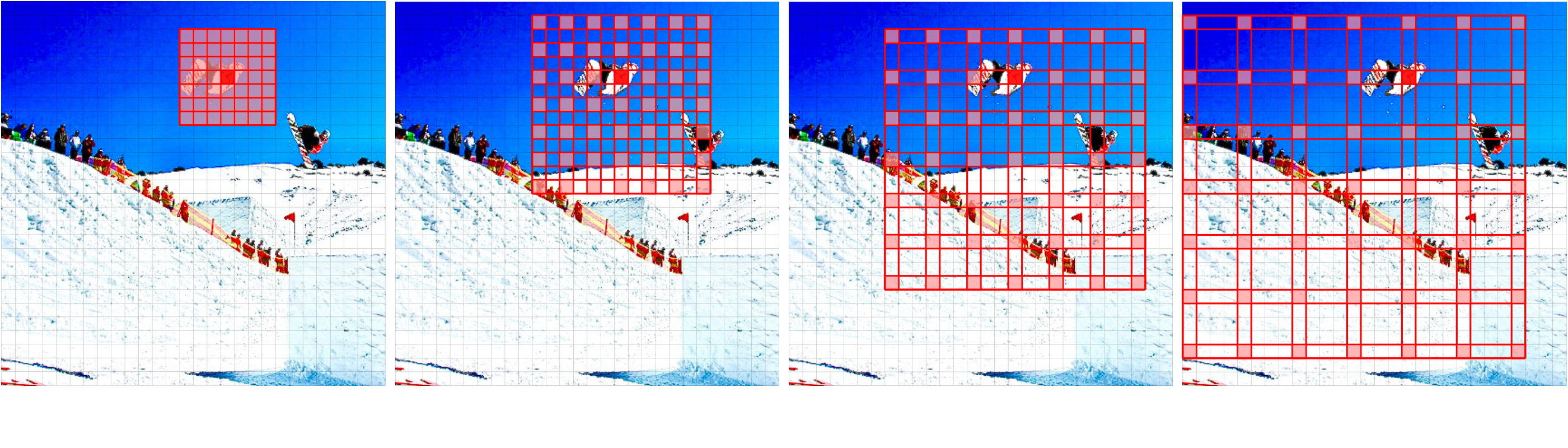

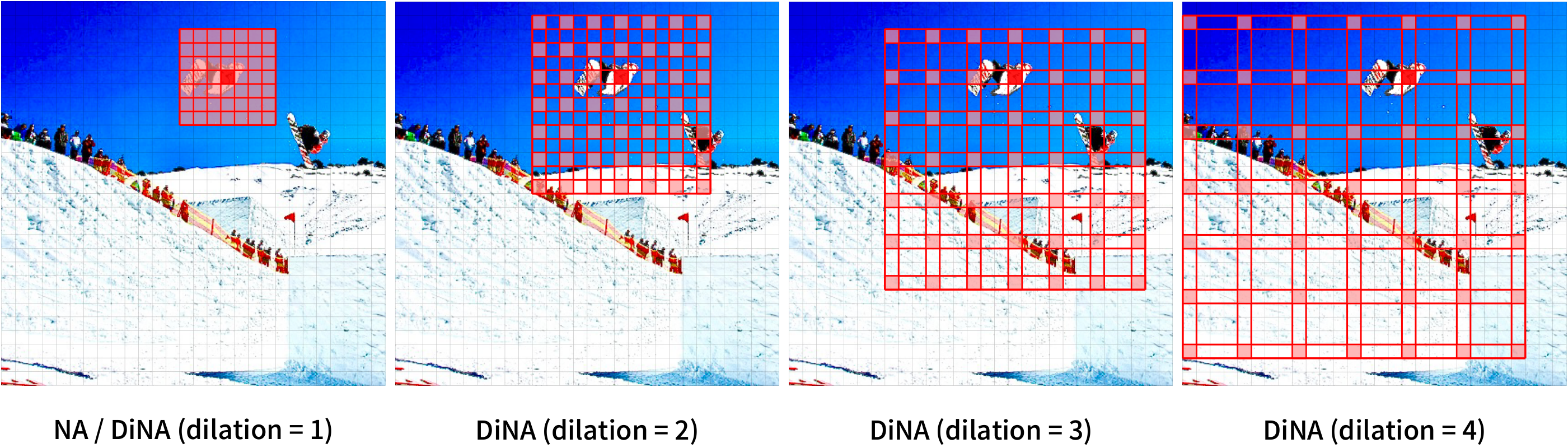

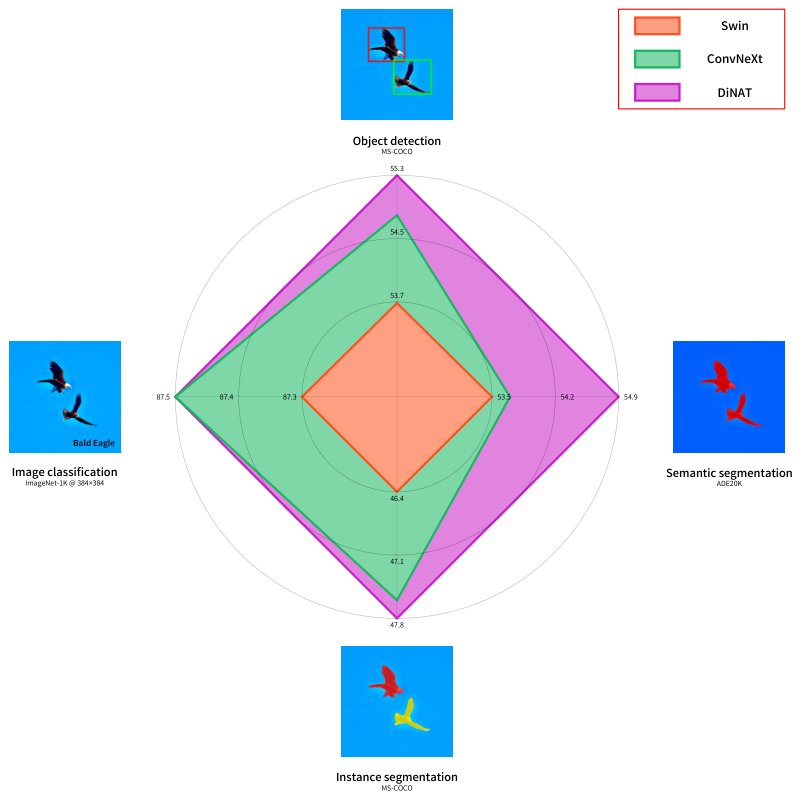

Wir haben kürzlich ein neues Modell vorgestellt, Dinat, das NA durch erweiterte Nachbarschaften erweitert (Dina, spärliche globale Aufmerksamkeit, auch bekannt als erweiterte lokale Aufmerksamkeit).

Kombinationen von Na/Dina sind in der Lage, die Lokalität zu erhalten, translationale Zweideutigkeit aufrechtzuerhalten, das empfängliche Feld exponentiell zu erweitern und die Interpendenzen von längerem Bereich zu erfassen, was zu erheblichen Leistungssteigerungen bei nachgelagerten Visionsaufgaben wie Stylenat für die Bildgenerierung führt.

Ein neuer hierarchischer Visionstransformator, der auf Aufmerksamkeit der Nachbarschaft (lokale Aufmerksamkeit) und erweiterte Aufmerksamkeit der Nachbarschaft (spärliche globale Aufmerksamkeit) basiert und die nachgeschalteten Aufgaben erheblich steigert.

Schauen Sie sich den Dinat Readme an.

Unser ursprüngliches Papier, Aufmerksamkeitstransformator der Nachbarschaft (NAT), die erste effiziente Aufmerksamkeit der lokalen Aufmerksamkeit.

Die Aufmerksamkeit der Nachbarschaft lokalisiert das Empfängnisfeld des Abfrage-Tokens (rot) für seine nächsten benachbarten Token im Schlüsselwertpaar (grün). Dies entspricht der Selfgeschwindigkeit von Dot-Produkte, wenn die Nachbarschaftsgröße mit den Bilddimensionen identisch ist. Beachten Sie, dass die Kanten spezielle Fälle sind.

@inproceedings { hassani2023neighborhood ,

title = { Neighborhood Attention Transformer } ,

author = { Ali Hassani and Steven Walton and Jiachen Li and Shen Li and Humphrey Shi } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2023 } ,

pages = { 6185-6194 }

}

@article { hassani2022dilated ,

title = { Dilated Neighborhood Attention Transformer } ,

author = { Ali Hassani and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2209.15001 } ,

eprint = { 2209.15001 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}

@article { walton2022stylenat ,

title = { StyleNAT: Giving Each Head a New Perspective } ,

author = { Steven Walton and Ali Hassani and Xingqian Xu and Zhangyang Wang and Humphrey Shi } ,

year = 2022 ,

url = { https://arxiv.org/abs/2211.05770 } ,

eprint = { 2211.05770 } ,

archiveprefix = { arXiv } ,

primaryclass = { cs.CV }

}