在這項研究中,我們旨在通過零射擊及時優化提高大語言模型(LLM)的算術推理能力。我們在這種優化中確定了以前被忽視的查詢依賴性目標,並闡明了兩種挑戰,這些挑戰阻礙了迅速優化技術的成功和經濟設計。一個主要問題是沒有有效的方法來評估在推斷黃金答案時提示。同時,通過與LLM的互動來學習以導航寬敞的自然語言促使空間被證明是資源密集的。為了解決這個問題,我們介紹了及時的女郎,該及時啟動女郎可以利用離線逆強化學習,以從離線提示示威數據中獲取見解。當在可訪問的數據集上對不同的提示進行基準測試時,這些數據存在為副產品。借助迅速女郎,通過首先學習離線獎勵模型來實現與查詢有關的及時優化目標。該模型可以在不訪問llms的情況下評估任何查詢促銷對。隨後,採用最佳的N策略來推薦最佳提示。我們在各種LLM量表和算術推理數據集中進行的實驗評估強調了擬議方法的功效和經濟可行性。

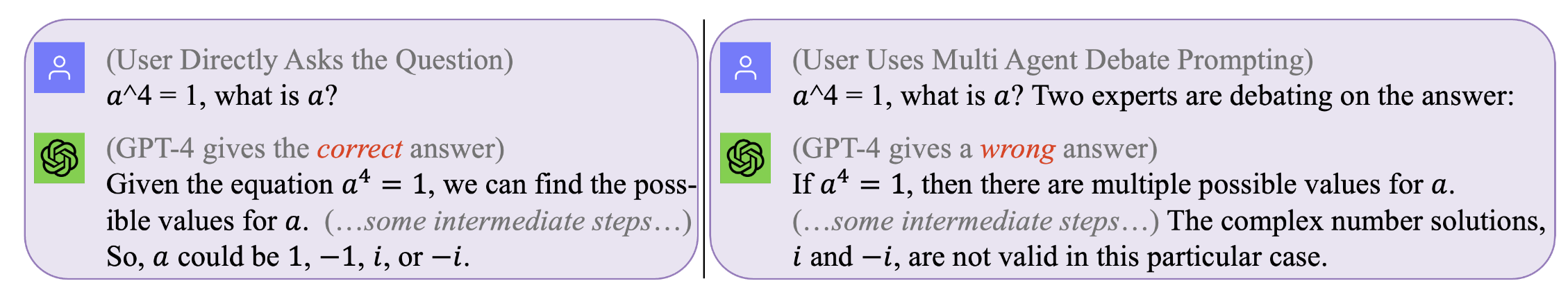

圖1。沒有提示是適用於所有查詢的完美之處。最佳提示與查詢有關。然而,尋求此類提示可能是昂貴且效率低下的。迅速女郎在推理期間有效且具有成本效益在推理期間優化提示。 (可以使用GPT4的原始聊天日誌,用於那些激勵示例,在左側,右)

圖1。沒有提示是適用於所有查詢的完美之處。最佳提示與查詢有關。然而,尋求此類提示可能是昂貴且效率低下的。迅速女郎在推理期間有效且具有成本效益在推理期間優化提示。 (可以使用GPT4的原始聊天日誌,用於那些激勵示例,在左側,右)

複製我們的結果(例如,使用Llama2)

獲取使用Llama-2的許可證。

獲取數據集:SVAMP,GSM8K,MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

這個步驟將需要很長時間 - 通常幾天。為了避免重複此類計算上的昂貴(在本地機器上運行LLM)或昂貴(調用GPT3.5或Tigerbot(Tigerbot)的商業API時,我們已經發布了與實驗中收集的LLM的所有交互式日誌。 。

例如,如果您想複製離線數據集,例如,使用Llama2模型,您需要在DIR下工作

[email protected]:facebookresearch/llama.git

然後移動Prompt-OIRL/llama_exps/llama_step1_gen_offline.py到llama文件夾

然後

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

此步驟將需要幾秒鐘才能完成,它將進行一些文件重命名和培訓測試拆分,並將相應的文件保存到新的文件夾LMllama2

python3 llama_step2_reorg_data.py

此步驟將需要幾秒鐘的時間才能完成,它將處理數據並存儲嵌入式和標籤,以使用.npy格式文件進行不同的實驗設置(即,培訓提示的不同可用性)。

python3 llama_step3_data_processing.py

根據選擇的算法和處理器,此步驟將需要幾分鐘到幾個小時才能完成。通常,培訓XGBoost獎勵模型將需要更長的時間,並且使用LightGBM獎勵模型可以更快。

python3 llama_step4_offline_evaluation.py

此步驟將需要幾分鐘才能完成。通過與LLMS進行交互來評估算法也可以選擇,但可能會較慢。在不同設置下的結果將全部保存到.csv文件

python3 llama_step5_offline_optimization.py

及時啟動女性使用RLAIF方法解決了LLMS中的提示問題。對於也對RLHF和RLAIF感興趣的讀者,以及在RL和LLM研究之間的交集中,我們將參考與LLM研究中討論RL的相關定位論文:LLMS時代的RL:什麼是必不可少的?需要什麼? rlhf,提示,及以後。

如果您想引用我們的代碼或紙張,請使用

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}