Neste estudo, pretendemos melhorar a capacidade de raciocínio aritmético de grandes modelos de linguagem (LLMs) através da otimização rápida de tiro zero. Identificamos um objetivo anteriormente esquecido da dependência de consultas em tal otimização e elucidaram dois desafios subsequentes que impedem o design bem -sucedido e econômico de técnicas de otimização imediata. Uma questão primária é a ausência de um método eficaz para avaliar as instruções durante a inferência quando a resposta dourada não estiver disponível. Simultaneamente, o aprendizado por meio de interações com o LLMS para navegar na extensa linguagem natural que provoca espaço é intensiva em recursos. Para abordar isso, introduzimos o Prompt-Oirl, que aproveita o aprendizado de reforço inverso offline para obter informações de dados offline de demonstração. Esses dados existem como subprodutos quando diversos avisos são comparados com conjuntos de dados acessíveis a abertura. Com o Prompt-Oirl, o objetivo de otimização de prompt dependente da consulta é alcançado primeiro aprendendo um modelo de recompensa offline. Este modelo pode avaliar quaisquer pares de promoção de consulta sem acessar o LLMS. Posteriormente, uma estratégia de melhor do N é implantada para recomendar o prompt ideal. Nossas avaliações experimentais em várias escalas de LLM e conjuntos de dados de raciocínio aritmético ressaltam a eficácia e a viabilidade econômica da abordagem proposta.

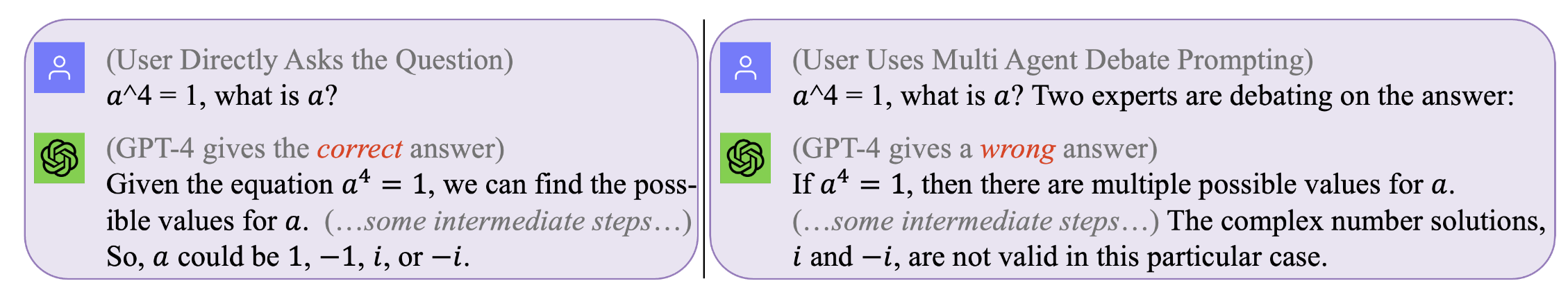

Figura 1. Nenhum prompt é perfeito que funciona para todas as consultas . O prompt ideal depende da consulta. No entanto, a busca de tais instruções pode ser cara e ineficiente. O Prompt-Oirl otimiza o prompt durante o tempo de inferência em um nível dependente da consulta de maneira eficaz e econômica. (Logs de bate -papo originais com GPT4 para esses exemplos motivadores podem ser encontrados à esquerda, à direita)

Figura 1. Nenhum prompt é perfeito que funciona para todas as consultas . O prompt ideal depende da consulta. No entanto, a busca de tais instruções pode ser cara e ineficiente. O Prompt-Oirl otimiza o prompt durante o tempo de inferência em um nível dependente da consulta de maneira eficaz e econômica. (Logs de bate -papo originais com GPT4 para esses exemplos motivadores podem ser encontrados à esquerda, à direita)

Para reproduzir nossos resultados (por exemplo, usando llama2)

Obtenha a licença para usar llama-2.

Obtenha acesso aos conjuntos de dados: Svamp, GSM8K, MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

Esta etapa levará muito tempo-normalmente alguns dias. Para evitar repetir um processo tão caro (ao executar LLMs em máquinas locais) ou caro (ao ligar para as APIs comerciais como GPT3.5 ou Tigerbot), lançamos todos os registros interativos com os LLMs coletados em nossos experimentos. .

Se você deseja reproduzir o conjunto de dados offline, por exemplo, com o modelo LLAMA2, você precisa trabalhar sob o diretor de

[email protected]:facebookresearch/llama.git

e mover Prompt-OIRL/llama_exps/llama_step1_gen_offline.py para a pasta llama

então

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

Esta etapa levará alguns segundos para terminar, ele fará alguma renomeação de arquivos e divisão de teste de treinamento e salvará arquivos correspondentes em uma nova pasta LMllama2

python3 llama_step2_reorg_data.py

Esta etapa levará alguns segundos para terminar, processará os dados e armazenará incorporação e etiquetas para diferentes configurações de experimentos (ou seja, com diferentes disponibilidade de avisos de treinamento) com arquivos de formato .npy .

python3 llama_step3_data_processing.py

Esta etapa levará alguns minutos a algumas horas para terminar, dependendo dos algoritmos escolhidos e do processador. Em geral, o treinamento de um modelo de recompensa XGBoost levará um pouco mais de tempo e o uso de um modelo de recompensa do LightGBM pode ser mais rápido.

python3 llama_step4_offline_evaluation.py

Esta etapa levará alguns minutos para terminar. Avaliar os algoritmos, interagindo com os LLMs também pode ser uma opção, mas pode ser mais lenta. Os resultados em diferentes configurações serão todos salvos nos arquivos .csv

python3 llama_step5_offline_optimization.py

O Promp-Oirl aborda os problemas de promoção no LLMS usando uma abordagem RLAIF. Para os leitores que também estão interessados em RLHF e RLAIF e, na interseção entre a pesquisa de RL e LLM, nos referiríamos ao nosso documento de posicionamento relacionado discutindo RL na pesquisa de LLM: RL na era do LLMS: O que é essencial? O que é necessário? RlHf, solicitando e além.

Se você deseja citar nosso código ou papel, use

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}