Dalam penelitian ini, kami bertujuan untuk meningkatkan kemampuan penalaran aritmatika dari model bahasa besar (LLM) melalui optimasi cepat nol-shot. Kami mengidentifikasi tujuan ketergantungan kueri yang sebelumnya diabaikan dalam optimasi tersebut dan menjelaskan dua tantangan berikutnya yang menghambat desain teknik optimisasi yang sukses dan ekonomis. Salah satu masalah utama adalah tidak adanya metode yang efektif untuk mengevaluasi petunjuk selama inferensi ketika jawaban emas tidak tersedia. Bersamaan dengan itu, belajar melalui interaksi dengan LLMS untuk menavigasi bahasa alami yang luas yang mendorong ruang terbukti padat sumber daya. Untuk mengatasi hal ini, kami memperkenalkan prompt-oirl, yang memanfaatkan penguatan terbalik secara offline belajar untuk menarik wawasan dari secara offline mendorong data demonstrasi. Data semacam itu ada sebagai produk sampingan ketika beragam petunjuk dibandingkan pada set data yang dapat diakses terbuka. Dengan prompt-oirl, tujuan optimisasi prompt yang bergantung pada kueri dicapai dengan terlebih dahulu mempelajari model hadiah offline. Model ini dapat mengevaluasi pasangan yang dimiliki kueri tanpa mengakses LLMS. Selanjutnya, strategi Best-of-N digunakan untuk merekomendasikan prompt optimal. Evaluasi eksperimental kami di berbagai skala LLM dan dataset penalaran aritmatika menggarisbawahi kemanjuran dan kelayakan ekonomi dari pendekatan yang diusulkan.

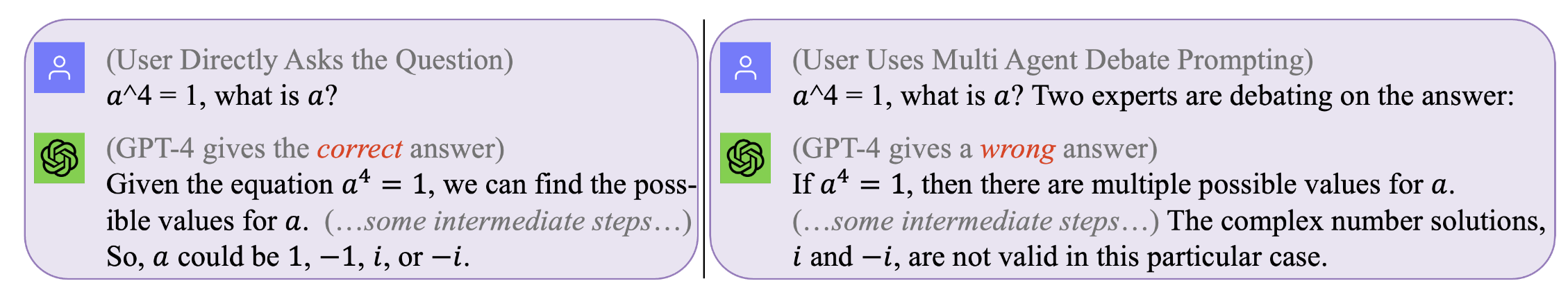

Gambar 1. Tidak ada prompt yang sempurna yang berfungsi untuk semua pertanyaan . Prompt optimal bergantung pada kueri. Namun pencarian dorongan semacam itu bisa mahal dan tidak efisien. Prompt-oirl mengoptimalkan prompt selama waktu inferensi pada tingkat yang bergantung pada kueri secara efektif dan hemat biaya. (Log obrolan asli dengan GPT4 untuk contoh yang memotivasi dapat ditemukan di kiri, kanan)

Gambar 1. Tidak ada prompt yang sempurna yang berfungsi untuk semua pertanyaan . Prompt optimal bergantung pada kueri. Namun pencarian dorongan semacam itu bisa mahal dan tidak efisien. Prompt-oirl mengoptimalkan prompt selama waktu inferensi pada tingkat yang bergantung pada kueri secara efektif dan hemat biaya. (Log obrolan asli dengan GPT4 untuk contoh yang memotivasi dapat ditemukan di kiri, kanan)

Untuk mereproduksi hasil kami (misalnya, menggunakan llama2)

Dapatkan lisensi untuk menggunakan LLAMA-2.

Dapatkan akses ke set data: SVAMP, GSM8K, MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

Langkah ini akan memakan waktu lama --- biasanya beberapa hari. Untuk menghindari mengulangi mahal secara komputasi seperti itu (saat menjalankan LLM pada mesin lokal) atau mahal (saat memanggil API komersial seperti GPT3.5 atau Tigerbot), kami telah merilis semua log interaktif dengan LLM yang dikumpulkan dalam percobaan kami. .

Jika Anda ingin mereproduksi dataset offline, misalnya, dengan model LLAMA2, Anda perlu bekerja di bawah Dir dari

[email protected]:facebookresearch/llama.git

dan pindahkan Prompt-OIRL/llama_exps/llama_step1_gen_offline.py ke folder llama

Kemudian

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

Langkah ini akan membutuhkan beberapa detik untuk menyelesaikannya, ini akan melakukan beberapa nama file dan uji-pelatihan dan menyimpan file yang sesuai ke folder baru LMllama2

python3 llama_step2_reorg_data.py

Langkah ini akan membutuhkan beberapa detik untuk menyelesaikannya, ini akan memproses data dan menyimpan embeddings dan label untuk pengaturan percobaan yang berbeda (yaitu, dengan ketersediaan petunjuk pelatihan yang berbeda) dengan file format .npy .

python3 llama_step3_data_processing.py

Langkah ini akan memakan waktu beberapa menit hingga beberapa jam untuk menyelesaikannya, tergantung pada algoritma yang dipilih dan prosesor. Secara umum, melatih model hadiah XGBoost akan membutuhkan waktu sedikit lebih lama, dan menggunakan model hadiah LightGBM bisa lebih cepat.

python3 llama_step4_offline_evaluation.py

Langkah ini akan memakan waktu beberapa menit untuk menyelesaikannya. Mengevaluasi algoritma dengan berinteraksi dengan LLM juga bisa menjadi pilihan tetapi bisa lebih lambat. Hasil di bawah pengaturan yang berbeda semua akan disimpan ke file .csv

python3 llama_step5_offline_optimization.py

Prompt-oirl mengatasi masalah yang diminta di LLMS menggunakan pendekatan RLAIF. Bagi pembaca yang juga tertarik pada RLHF dan RLAIF, dan di persimpangan antara penelitian RL dan LLM, kami akan merujuk pada makalah penentuan posisi terkait kami yang membahas RL dalam penelitian LLM: RL di era LLM: Apa yang penting? Apa yang dibutuhkan? Rlhf, mendorong, dan seterusnya.

Jika Anda ingin mengutip kode atau kertas kami, silakan gunakan

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}