この研究では、ゼロショットプロンプトの最適化により、大規模な言語モデル(LLMS)の算術推論能力を強化することを目指しています。このような最適化におけるクエリ依存性の以前に見落とされがちな目的を特定し、迅速な最適化技術の成功した経済的設計を妨げる2つの課題を解明します。主な問題の1つは、黄金の答えが利用できない場合に、推論中にプロンプトを評価する効果的な方法がないことです。同時に、LLMとの相互作用を介して学習して、広大な自然言語を促すスペースを促すことで、リソースが集中していることがわかります。これに対処するために、オフラインの逆補強学習を活用して、オフラインで洞察を導き出してデモンストレーションデータを導入します。このようなデータは、オープンアクセス可能なデータセットに多様なプロンプトがベンチマークされている場合、副産物として存在します。プロンプトOirlを使用すると、クエリ依存のプロンプト最適化目標は、最初にオフライン報酬モデルを学習することで実現されます。このモデルは、LLMSにアクセスすることなく、任意のクエリプロムプトペアを評価できます。その後、最適なプロンプトを推奨するために、Best-of-n-n戦略が展開されます。さまざまなLLMスケールと算術推論データセットにわたる実験的評価は、提案されたアプローチの有効性と経済的実行可能性の両方を強調しています。

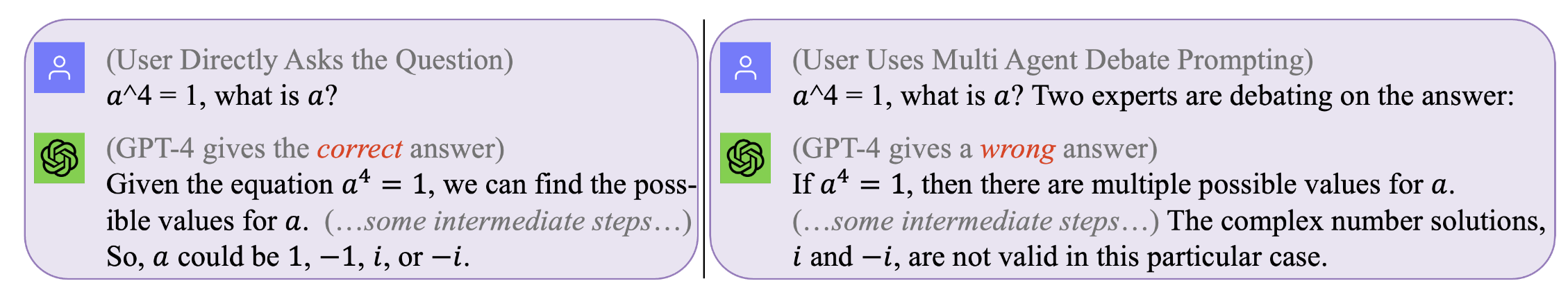

図1。すべてのクエリに機能する完璧なプロンプトはありません。最適なプロンプトはクエリ依存です。しかし、そのようなプロンプトの探求は、費用がかかり、非効率的です。プロンプトオールは、クエリ依存レベルでの推論時間中にプロンプトを効果的かつ費用効率を高めます。 (動機付けの例については、GPT4との元のチャットログは、左、右側にあります)

図1。すべてのクエリに機能する完璧なプロンプトはありません。最適なプロンプトはクエリ依存です。しかし、そのようなプロンプトの探求は、費用がかかり、非効率的です。プロンプトオールは、クエリ依存レベルでの推論時間中にプロンプトを効果的かつ費用効率を高めます。 (動機付けの例については、GPT4との元のチャットログは、左、右側にあります)

結果を再現するには(例えば、llama2を使用)

llama-2を使用するライセンスを取得します。

SVAMP、GSM8K、MAWPS:データセットへのアクセスを取得します

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

このステップには長い時間がかかります---通常数日。このような計算上の高価(ローカルマシンでLLMを実行するとき)またはコスト(GPT3.5やTigerbotなどの市販のAPIを呼び出す場合)プロセスを繰り返すことを避けるために、実験で収集されたLLMとのインタラクティブログをすべてリリースしました。 。

たとえば、llama2モデルを使用して、オフラインデータセットを再現したい場合は、dir ofの下で作業する必要があります。

[email protected]:facebookresearch/llama.git

Prompt-OIRL/llama_exps/llama_step1_gen_offline.pyをllamaフォルダーに移動します

それから

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

このステップは完了に数秒かかります。ファイルの名前変更とトレーニングテストの分割を実行し、対応するファイルを新しいフォルダーLMllama2に保存します。

python3 llama_step2_reorg_data.py

このステップは完了に数秒かかります。データを処理し、 .npy形式ファイルを使用して、さまざまな実験設定(つまり、トレーニングプロンプトのさまざまな可用性がある)の埋め込みとラベルを保存します。

python3 llama_step3_data_processing.py

このステップは、選択したアルゴリズムとプロセッサに応じて、数時間から数時間かかります。一般に、Xgboost Rewardモデルのトレーニングには少し時間がかかり、LightGBM報酬モデルの使用はより速い場合があります。

python3 llama_step4_offline_evaluation.py

このステップには数分かかります。 LLMとの対話によってアルゴリズムを評価することもオプションになる可能性がありますが、遅くなる可能性があります。さまざまな設定の下での結果はすべて.csvファイルに保存されます

python3 llama_step5_offline_optimization.py

Prompt-Oirlは、RLAIFアプローチを使用してLLMSのプロンプトの問題に対処します。 RLHFとRLAIFにも興味がある読者、およびRLとLLMの研究の交差点では、LLM研究でRLについて議論する関連するポジショニングペーパーを参照します。LLMSの時代のRL:何が不可欠ですか?何が必要ですか? RLHF、プロンプト、そしてそれ以降。

コードや紙を引用したい場合は、使用してください

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}