في هذه الدراسة ، نهدف إلى تعزيز قدرة المنطق الحسابي لنماذج اللغة الكبيرة (LLMS) من خلال تحسين موجه الصفر. نحدد هدفًا تم تجاهله مسبقًا من التبعية للاستعلام في مثل هذا التحسين وتوضيح تحديين تلا ذلك يعيقان التصميم الناجح والاقتصادي لتقنيات التحسين الفوري. إحدى القضايا الأساسية هي عدم وجود طريقة فعالة لتقييم المطالبات أثناء الاستدلال عندما تكون الإجابة الذهبية غير متوفرة. في الوقت نفسه ، يثبت التعلم عبر التفاعلات مع LLMs للتنقل في مجال اللغة الطبيعية الواسعة أن يكون كثيفة الموارد. لمعالجة هذا ، نقدم orirl orirl ، والتي تسخر في وضع عدم وجود التعزيز العكسي في وضع عدم الاتصال لاستخلاص رؤى من بيانات العرض التوضيحي في وضع عدم الاتصال. توجد هذه البيانات كمنتجات ثانوية عندما تكون مطالبات متنوعة معروفة في مجموعات بيانات يمكن الوصول إليها مفتوحة. باستخدام Form-Oirl ، يتم تحقيق هدف تحسين المطالبة المعتمدة على الاستعلام من خلال تعلم نموذج مكافأة غير متصل بالإنترنت. يمكن لهذا النموذج تقييم أي أزواج تعبير الاستعلام دون الوصول إلى LLMs. بعد ذلك ، يتم نشر أفضل استراتيجية من N للتوصية بالمطالبة المثلى. تؤكد تقييماتنا التجريبية عبر مختلف مقاييس LLM ومجموعات بيانات التفكير الحسابية على كل من فعالية النهج المقترح والقابلية الاقتصادية.

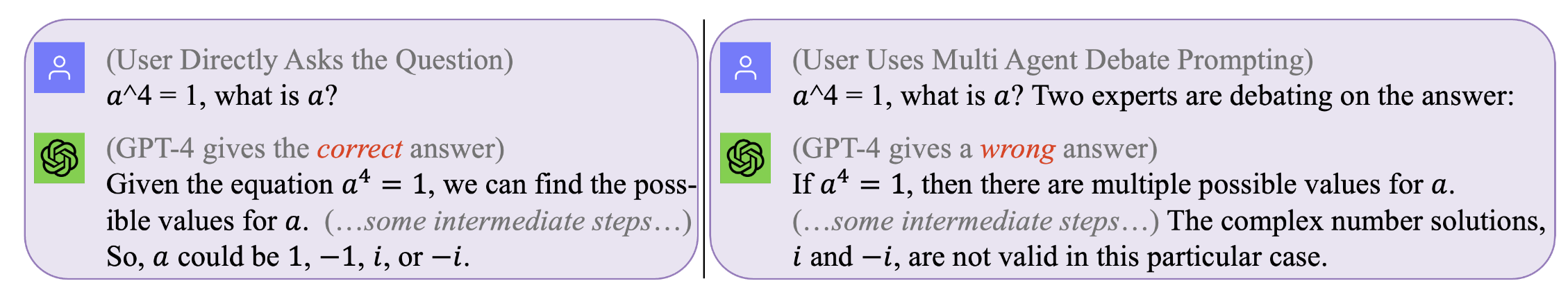

الشكل 1. لا توجد موجه مثالي يعمل لجميع الاستفسارات . المطالبة المثلى تعتمد على الاستعلام. ومع ذلك ، يمكن أن يكون البحث عن مثل هذه المطالبات مكلفة وغير فعالة. تقوم شركة Form-Oirl بتحسين المطالبة أثناء وقت الاستدلال على مستوى يعتمد على الاستعلام بشكل فعال وفعالية من حيث التكلفة. (سجلات الدردشة الأصلية مع GPT4 لتلك الأمثلة المحفزة يمكن العثور عليها في اليسار ، يمينًا)

الشكل 1. لا توجد موجه مثالي يعمل لجميع الاستفسارات . المطالبة المثلى تعتمد على الاستعلام. ومع ذلك ، يمكن أن يكون البحث عن مثل هذه المطالبات مكلفة وغير فعالة. تقوم شركة Form-Oirl بتحسين المطالبة أثناء وقت الاستدلال على مستوى يعتمد على الاستعلام بشكل فعال وفعالية من حيث التكلفة. (سجلات الدردشة الأصلية مع GPT4 لتلك الأمثلة المحفزة يمكن العثور عليها في اليسار ، يمينًا)

لإعادة إنتاج نتائجنا (على سبيل المثال ، باستخدام llama2)

احصل على ترخيص لاستخدام Llama-2.

يمكنك الوصول إلى مجموعات البيانات: Svamp ، GSM8K ، MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

ستستغرق هذه الخطوة وقتًا طويلاً --- عادة بضعة أيام. لتجنب تكرار مثل هذه عملية باهظة الثمن (عند تشغيل LLMs على الآلات المحلية) أو المكلفة (عند استدعاء واجهات برمجة التطبيقات التجارية مثل GPT3.5 أو Tigerbot) ، أصدرنا جميع السجلات التفاعلية مع LLMs التي تم جمعها في تجاربنا. .

إذا كنت ترغب في إعادة إنتاج مجموعة البيانات في وضع عدم الاتصال ، على سبيل المثال ، مع نموذج LLAMA2 ، فأنت بحاجة إلى العمل تحت DIR OF

[email protected]:facebookresearch/llama.git

وانقل Prompt-OIRL/llama_exps/llama_step1_gen_offline.py إلى مجلد llama

ثم

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

ستستغرق هذه الخطوة بضع ثوانٍ لإنهائها ، وسوف تقوم ببعض تقسيم الملفات ومختبرات التدريب وحفظ الملفات المقابلة إلى مجلد جديد LMllama2

python3 llama_step2_reorg_data.py

ستستغرق هذه الخطوة بضع ثوانٍ لإنهائها ، وسوف تقوم بمعالجة البيانات وتخزين التضمينات والعلامات لإعدادات التجربة المختلفة (أي ، مع توافر مختلف مطالبات التدريب) مع ملفات تنسيق .npy .

python3 llama_step3_data_processing.py

ستستغرق هذه الخطوة بضع دقائق إلى بضع ساعات حتى تنتهي ، اعتمادًا على الخوارزميات المختارة والمعالج. بشكل عام ، سيستغرق تدريب نموذج مكافأة XgBoost وقتًا أطول قليلاً ، ويمكن أن يكون استخدام نموذج مكافأة LightGBM أسرع.

python3 llama_step4_offline_evaluation.py

ستستغرق هذه الخطوة بضع دقائق حتى تنتهي. يمكن أن يكون تقييم الخوارزميات من خلال التفاعل مع LLMs خيارًا أيضًا ولكن قد يكون أبطأ. سيتم حفظ النتائج تحت إعدادات مختلفة في ملفات .csv

python3 llama_step5_offline_optimization.py

يعالج Form-Oirl مشاكل المطالبة في LLMS باستخدام نهج RLAIF. بالنسبة للقراء المهتمين أيضًا بـ RLHF و RLAIF ، وفي التقاطع بين RL و LLM Research ، فإننا نشير إلى ورقة تحديد المواقع ذات الصلة التي تناقش RL في بحث LLM: RL في عصر LLMS: ما هو الضروري؟ ما هو مطلوب؟ RLHF ، المطالبة ، وما وراءها.

إذا كنت ترغب

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}