在这项研究中,我们旨在通过零射击及时优化提高大语言模型(LLM)的算术推理能力。我们在这种优化中确定了以前被忽视的查询依赖性目标,并阐明了两种挑战,这些挑战阻碍了迅速优化技术的成功和经济设计。一个主要问题是没有有效的方法来评估在推断黄金答案时提示。同时,通过与LLM的互动来学习以导航宽敞的自然语言促使空间被证明是资源密集的。为了解决这个问题,我们介绍了及时的女郎,该及时启动女郎可以利用离线逆强化学习,以从离线提示示威数据中获取见解。当在可访问的数据集上对不同的提示进行基准测试时,这些数据存在为副产品。借助迅速女郎,通过首先学习离线奖励模型来实现与查询有关的及时优化目标。该模型可以在不访问llms的情况下评估任何查询促销对。随后,采用最佳的N策略来推荐最佳提示。我们在各种LLM量表和算术推理数据集中进行的实验评估强调了拟议方法的功效和经济可行性。

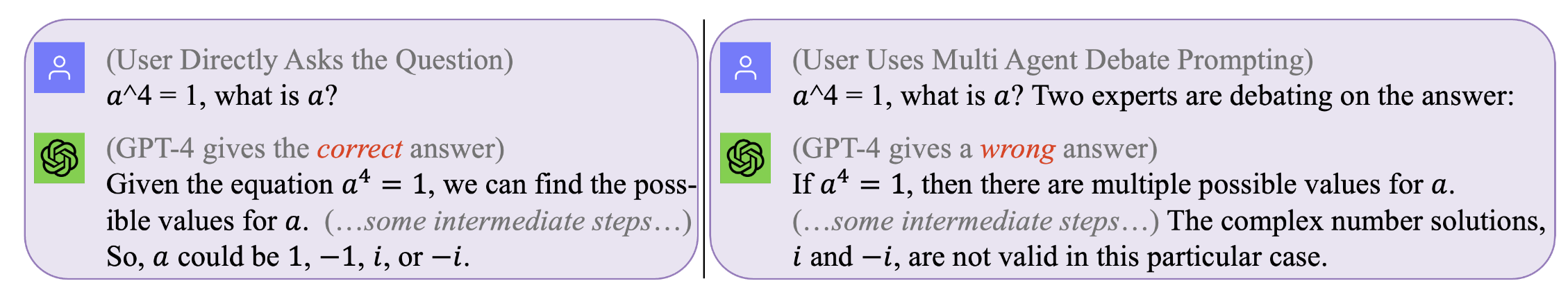

图1。没有提示是适用于所有查询的完美之处。最佳提示与查询有关。然而,寻求此类提示可能是昂贵且效率低下的。迅速女郎在推理期间有效且具有成本效益在推理期间优化提示。 (可以使用GPT4的原始聊天日志,用于那些激励示例,在左侧,右)

图1。没有提示是适用于所有查询的完美之处。最佳提示与查询有关。然而,寻求此类提示可能是昂贵且效率低下的。迅速女郎在推理期间有效且具有成本效益在推理期间优化提示。 (可以使用GPT4的原始聊天日志,用于那些激励示例,在左侧,右)

复制我们的结果(例如,使用Llama2)

获取使用Llama-2的许可证。

获取数据集:SVAMP,GSM8K,MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

这个步骤将需要很长时间 - 通常几天。为了避免重复此类计算上的昂贵(在本地机器上运行LLM)或昂贵(调用GPT3.5或Tigerbot(Tigerbot)的商业API时,我们已经发布了与实验中收集的LLM的所有交互式日志。 。

例如,如果您想复制离线数据集,例如,使用Llama2模型,您需要在DIR下工作

[email protected]:facebookresearch/llama.git

然后移动Prompt-OIRL/llama_exps/llama_step1_gen_offline.py到llama文件夹

然后

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

此步骤将需要几秒钟才能完成,它将进行一些文件重命名和培训测试拆分,并将相应的文件保存到新的文件夹LMllama2

python3 llama_step2_reorg_data.py

此步骤将需要几秒钟的时间才能完成,它将处理数据并存储嵌入式和标签,以使用.npy格式文件进行不同的实验设置(即,培训提示的不同可用性)。

python3 llama_step3_data_processing.py

根据选择的算法和处理器,此步骤将需要几分钟到几个小时才能完成。通常,培训XGBoost奖励模型将需要更长的时间,并且使用LightGBM奖励模型可以更快。

python3 llama_step4_offline_evaluation.py

此步骤将需要几分钟才能完成。通过与LLMS进行交互来评估算法也可以选择,但可能会较慢。在不同设置下的结果将全部保存到.csv文件

python3 llama_step5_offline_optimization.py

及时启动女性使用RLAIF方法解决了LLMS中的提示问题。对于也对RLHF和RLAIF感兴趣的读者,以及在RL和LLM研究之间的交集中,我们将参考与LLM研究中讨论RL的相关定位论文:LLMS时代的RL:什么是必不可少的?需要什么? rlhf,提示,及以后。

如果您想引用我们的代码或纸张,请使用

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}