ในการศึกษานี้เรามุ่งมั่นที่จะเพิ่มความสามารถในการใช้เหตุผลทางคณิตศาสตร์ของแบบจำลองภาษาขนาดใหญ่ (LLMS) ผ่านการเพิ่มประสิทธิภาพที่รวดเร็วเป็นศูนย์ เราระบุวัตถุประสงค์ที่ถูกมองข้ามก่อนหน้านี้ของการพึ่งพาการสืบค้นในการเพิ่มประสิทธิภาพดังกล่าวและอธิบายความท้าทายที่ตามมาสองประการที่ขัดขวางการออกแบบที่ประสบความสำเร็จและประหยัดของเทคนิคการเพิ่มประสิทธิภาพที่รวดเร็ว ปัญหาหลักอย่างหนึ่งคือไม่มีวิธีการที่มีประสิทธิภาพในการประเมินพรอมต์ระหว่างการอนุมานเมื่อคำตอบสีทองไม่พร้อมใช้งาน ในขณะที่การเรียนรู้ผ่านการโต้ตอบกับ LLM เพื่อนำทางภาษาธรรมชาติที่กว้างขวางพร้อมที่จะพิสูจน์ให้เห็นว่ามีทรัพยากรมาก ในการแก้ไขปัญหานี้เราแนะนำ Prompt-Oirl ซึ่งควบคุมการเสริมแรงแบบผกผันแบบออฟไลน์เพื่อดึงข้อมูลเชิงลึกจากข้อมูลการสาธิตออฟไลน์ ข้อมูลดังกล่าวมีอยู่เป็นผลพลอยได้เมื่อพรอมต์ที่หลากหลายได้รับการเปรียบเทียบในชุดข้อมูลแบบเปิดที่สามารถเข้าถึงได้ ด้วย Prompt-Oirl วัตถุประสงค์การเพิ่มประสิทธิภาพที่รวดเร็วขึ้นอยู่กับการสืบค้นนั้นสามารถทำได้โดยการเรียนรู้แบบจำลองรางวัลออฟไลน์เป็นครั้งแรก รุ่นนี้สามารถประเมินคู่การสอบถามใด ๆ โดยไม่ต้องเข้าถึง LLM ต่อจากนั้นกลยุทธ์ที่ดีที่สุดของ N-N จะถูกปรับใช้เพื่อแนะนำพรอมต์ที่ดีที่สุด การประเมินผลการทดลองของเราในเครื่องชั่ง LLM และชุดข้อมูลการใช้เหตุผลทางคณิตศาสตร์ที่หลากหลายเน้นทั้งประสิทธิภาพและความเป็นไปได้ทางเศรษฐกิจของวิธีการที่เสนอ

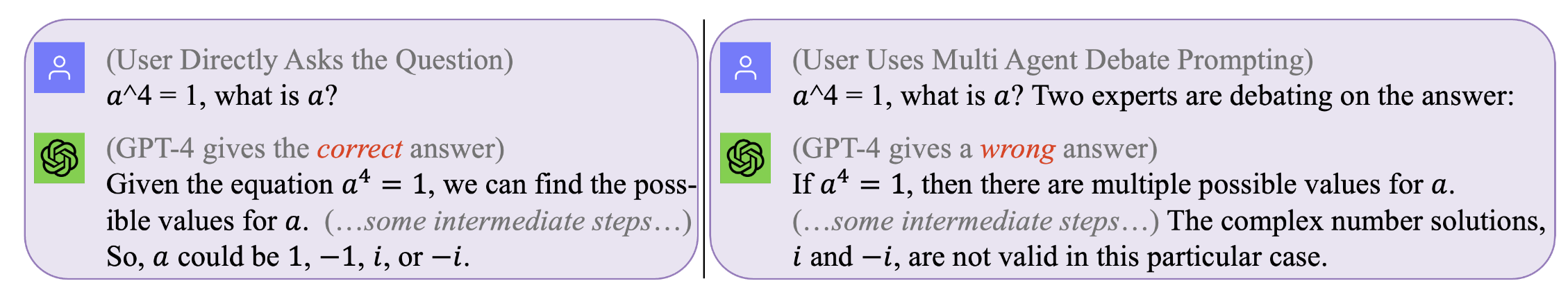

รูปที่ 1. ไม่มีพรอมต์ที่สมบูรณ์แบบสำหรับการสืบค้นทั้งหมด พรอมต์ที่ดีที่สุดคือขึ้นอยู่กับการสืบค้น แต่การแสวงหาพรอมต์ดังกล่าวอาจมีค่าใช้จ่ายสูงและไม่มีประสิทธิภาพ พรอมต์โอลล์เพิ่มประสิทธิภาพการแจ้งความพร้อมในระหว่างการอนุมานในระดับ ที่ขึ้นกับการสืบค้น อย่างมีประสิทธิภาพและประหยัดค่าใช้จ่าย (บันทึกการแชทดั้งเดิมด้วย GPT4 สำหรับตัวอย่างแรงจูงใจเหล่านั้นสามารถพบได้ทางซ้ายซ้ายขวา)

รูปที่ 1. ไม่มีพรอมต์ที่สมบูรณ์แบบสำหรับการสืบค้นทั้งหมด พรอมต์ที่ดีที่สุดคือขึ้นอยู่กับการสืบค้น แต่การแสวงหาพรอมต์ดังกล่าวอาจมีค่าใช้จ่ายสูงและไม่มีประสิทธิภาพ พรอมต์โอลล์เพิ่มประสิทธิภาพการแจ้งความพร้อมในระหว่างการอนุมานในระดับ ที่ขึ้นกับการสืบค้น อย่างมีประสิทธิภาพและประหยัดค่าใช้จ่าย (บันทึกการแชทดั้งเดิมด้วย GPT4 สำหรับตัวอย่างแรงจูงใจเหล่านั้นสามารถพบได้ทางซ้ายซ้ายขวา)

เพื่อทำซ้ำผลลัพธ์ของเรา (เช่นการใช้ LLAMA2)

รับใบอนุญาตในการใช้ LLAMA-2

เข้าถึงชุดข้อมูล: SVAMP, GSM8K, MAWPS

git clone [email protected]:holarissun/Prompt-OIRL.git

conda create --name prompt-oirl python==3.10

conda activate prompt-oirl

cd Prompt-OIRL

pip install -r requirements.txt

ขั้นตอนนี้จะใช้เวลานาน --- โดยทั่วไปสองสามวัน เพื่อหลีกเลี่ยงการทำซ้ำการคำนวณที่มีราคาแพง (เมื่อใช้ LLMs บนเครื่องจักรในท้องถิ่น) หรือราคาแพง (เมื่อเรียก API เชิงพาณิชย์เช่น GPT3.5 หรือ Tigerbot) กระบวนการเราได้ เปิดตัวบันทึกการโต้ตอบทั้งหมดด้วย LLMs ที่รวบรวมในการทดลองของเรา -

หากคุณต้องการทำซ้ำชุดข้อมูลออฟไลน์เช่นกับโมเดล LLAMA2 คุณต้องทำงานภายใต้ DIR ของ

[email protected]:facebookresearch/llama.git

และย้าย Prompt-OIRL/llama_exps/llama_step1_gen_offline.py ไปยังโฟลเดอร์ llama

แล้ว

torchrun --nproc_per_node 1 llama_step1_gen_offline.py

--ckpt_dir llama-2-7b-chat/

--tokenizer_path tokenizer.model

--max_seq_len 512 --max_batch_size 8 --prompt_idx 0 --dataset_eval gsm8k

ขั้นตอนนี้จะใช้เวลาสองสามวินาทีในการทำให้เสร็จสิ้นมันจะทำการเปลี่ยนชื่อไฟล์และการทดสอบการทดสอบการฝึกอบรมและบันทึกไฟล์ที่สอดคล้องกันลงในโฟลเดอร์ใหม่ LMllama2

python3 llama_step2_reorg_data.py

ขั้นตอนนี้จะใช้เวลาสองสามวินาทีในการเสร็จสิ้นมันจะประมวลผลข้อมูลและจัดเก็บการฝังและฉลากสำหรับการตั้งค่าการทดลองที่แตกต่างกัน (เช่นมีความพร้อมของการฝึกอบรมที่แตกต่างกัน) พร้อมไฟล์รูปแบบ. .npy

python3 llama_step3_data_processing.py

ขั้นตอนนี้จะใช้เวลาไม่กี่นาทีถึงสองสามชั่วโมงกว่าจะเสร็จสิ้นขึ้นอยู่กับอัลกอริทึมที่เลือกและโปรเซสเซอร์ โดยทั่วไปการฝึกอบรมรุ่นรางวัล XGBOOST จะใช้เวลานานขึ้นเล็กน้อยและการใช้โมเดลรางวัล LightGBM สามารถเร็วขึ้น

python3 llama_step4_offline_evaluation.py

ขั้นตอนนี้จะใช้เวลาไม่กี่นาที การประเมินอัลกอริทึมโดยการโต้ตอบกับ LLMs อาจเป็นตัวเลือก แต่อาจช้าลง ผลลัพธ์ภายใต้การตั้งค่าที่แตกต่างกันจะถูกบันทึกไว้ในไฟล์ .csv ทั้งหมด

python3 llama_step5_offline_optimization.py

Prompt-Oirl กล่าวถึงปัญหาการแจ้งเตือนใน LLM โดยใช้วิธี RLAIF สำหรับผู้อ่านที่มีความสนใจใน RLHF และ RLAIF และในจุดตัดระหว่างการวิจัย RL และ LLM เราจะอ้างถึงกระดาษตำแหน่งที่เกี่ยวข้องของเราที่พูดถึง RL ในการวิจัย LLM: RL ในยุคของ LLMS: อะไรคือสิ่งสำคัญ? สิ่งที่จำเป็น? RLHF การแจ้งเตือนและอื่น ๆ

หากคุณต้องการอ้างอิงรหัสหรือกระดาษของเราโปรดใช้

@inproceedings{sun2023query,

title={Query-Dependent Prompt Evaluation and Optimization with Offline Inverse RL},

author={Sun, Hao and H{"u}y{"u}k, Alihan and van der Schaar, Mihaela},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024}

}

@article{sun2023reinforcement,

title={Reinforcement Learning in the Era of LLMs: What is Essential? What is needed? An RL Perspective on RLHF, Prompting, and Beyond},

author={Sun, Hao},

journal={arXiv preprint arXiv:2310.06147},

year={2023}

}